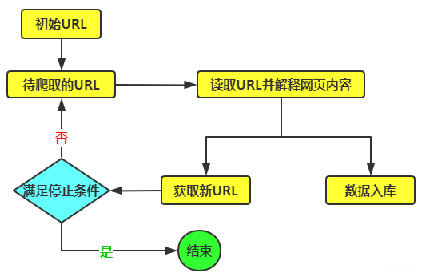

以下是 Java 爬虫实现分布式部署的关键要点及示例代码片段辅助理解: 一、任务分配与管理 划分任务: 根据要爬取的目标网站结构和数据量,将爬取任务拆分成多个小的子任务。例如,如果要爬取一个大型电商网站的所有商品信息,可以按照商品类别进行划分,每个类别作为一个独立的子任务。这样可以确保每个爬虫节点只负责处理一部分数据,提高效率和可管理性。 对于网页链接的爬取任务,可以根据链接的特征进行划分。比如按照域名的哈希值进行分配,确保不同的爬虫节点处理不同部分的链接,避免重复爬取。 任务调度: 使用一个中央任务调度器来分配任务给各个爬虫节点。这个调度器可以是一个独立的服务或者组件,负责监控每个爬虫节点的工作状态,并根据其负载情况动态分配任务。例如,当一个爬虫节点完成了当前的任务,调度器会立即分配新的任务给它,以确保资源的充分利用。 可以采用分布式任务调度框架,如 Apache Mesos 或 Kubernetes,来实现任务的自动化调度和管理。这些框架提供了强大的资源管理和任务分配功能,可以根据集群的资源状况和任务需求自动调整任务的分配策略。 二、数据存储与共享 分布式数据库: 使用分布式数据库来存储爬取到的数据,以便各个爬虫节点可以共享和访问。例如,Apache Cassandra 或 MongoDB 等分布式数据库系统可以支持大规模的数据存储和高并发的读写操作。爬虫节点在爬取到数据后,将数据存储到分布式数据库中,其他节点可以根据需要从数据库中读取数据进行进一步的处理或分析。 在存储数据时,需要考虑数据的一致性和完整性。可以使用数据库的事务机制或分布式一致性算法来确保数据的正确存储和更新。例如,当多个爬虫节点同时写入数据到数据库时,需要使用数据库的并发控制机制来避免数据冲突和错误。 数据缓存: 在各个爬虫节点中使用本地缓存来存储已经爬取过的页面或数据,以减少重复请求和提高爬取效率。例如,使用 Ehcache 或 Redis 等缓存技术,将经常访问的页面或数据缓存在内存中,下次需要时可以直接从缓存中获取,而不需要再次发送网络请求。 对于分布式缓存系统,需要考虑缓存的同步和更新策略。当一个爬虫节点更新了缓存中的数据时,需要将更新信息同步到其他节点,以确保缓存数据的一致性。可以使用分布式缓存的发布 - 订阅机制或数据同步工具来实现缓存的同步。 三、通信与协调 消息队列: 使用消息队列来实现爬虫节点之间的通信和协调。例如,当一个爬虫节点发现了新的链接需要爬取时,可以将链接信息发送到消息队列中,其他节点可以从队列中获取链接并进行爬取。消息队列可以起到缓冲和异步通信的作用,避免节点之间的直接依赖和同步等待。 常见的消息队列系统有 RabbitMQ、Apache Kafka 等。可以根据业务需求选择合适的消息队列,并配置相应的队列结构和消息格式。例如,可以创建不同类型的队列,分别用于任务分配、数据传输和状态报告等。 分布式锁: 在分布式环境下,为了避免多个爬虫节点同时访问和修改同一资源导致的数据冲突和错误,需要使用分布式锁机制。例如,当一个爬虫节点正在爬取一个特定的网页时,可以使用分布式锁将该网页锁定,其他节点在尝试访问该网页时会被阻塞,直到锁被释放。 可以使用分布式锁服务,如 ZooKeeper 或 Redis 的分布式锁实现,来确保在分布式环境下的资源互斥访问。在使用分布式锁时,需要注意锁的超时时间和重试机制,以避免因网络故障或节点故障导致的锁无法释放或死锁问题。 四、代码实现示例(部分关键代码展示) 使用分布式任务调度框架(如 Kubernetes)的任务分配示例代码:

import io.fabric8.kubernetes.client.KubernetesClientBuilder;

import io.fabric8.kubernetes.client.dsl.MixedOperation;

import io.fabric8.kubernetes.client.dsl.Resource;

import io.fabric8.kubernetes.model.apps.Deployment;

import io.fabric8.kubernetes.model.apps.DeploymentBuilder;

public class TaskScheduler {

public static void main(String[] args) {

KubernetesClient client = new KubernetesClientBuilder().build();

// 创建一个 Deployment 对象,表示爬虫节点的部署

Deployment deployment = new DeploymentBuilder()

.withNewMetadata()

.withName("crawler-node")

.endMetadata()

.withNewSpec()

.withReplicas(3) // 设置爬虫节点的数量

.withNewTemplate()

.withNewMetadata()

.addToLabels("app", "crawler")

.endMetadata()

.withNewSpec()

.addNewContainer()

.withName("crawler-container")

.withImage("your-crawler-image") // 设置爬虫容器的镜像

.addNewPort()

.withContainerPort(8080)

.endPort()

.endContainer()

.endSpec()

.endTemplate()

.endSpec()

.build();

// 使用 Kubernetes API 创建 Deployment

MixedOperation<Deployment, DeploymentList, Resource<Deployment>> deploymentOperation = client.apps().deployments();

deploymentOperation.create(deployment);

}

}使用消息队列(如 RabbitMQ)进行通信的示例代码(使用 Java 的 RabbitMQ 客户端库):

import com.rabbitmq.client.Connection;

import com.rabbitmq.client.ConnectionFactory;

import com.rabbitmq.client.DeliverCallback;

public class CrawlerNode {

private static final String QUEUE_NAME = "crawler_queue";

public static void main(String[] argv) throws Exception {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("localhost");

Connection connection = factory.newConnection();

Channel channel = connection.createChannel();

channel.queueDeclare(QUEUE_NAME, false, false, false, null);

System.out.println("Waiting for messages. To exit press CTRL+C");

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), "UTF-8");

System.out.println("Received link: " + message);

// 在这里处理接收到的链接,进行爬取操作

};

channel.basicConsume(QUEUE_NAME, true, deliverCallback, consumerTag -> { });

}

}使用分布式锁(如 Redis 实现)的示例代码(使用 Jedis 客户端库):

public class DistributedLock {

private static final String LOCK_KEY = "crawler_lock";

public static boolean acquireLock(Jedis jedis, int timeout) {

long startTime = System.currentTimeMillis();

while (System.currentTimeMillis() - startTime < timeout) {

if (jedis.setnx(LOCK_KEY, "locked") == 1) {

jedis.expire(LOCK_KEY, 10); // 设置锁的过期时间为 10 秒

return true;

}

try {

Thread.sleep(100);

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

}

return false;

}

public static void releaseLock(Jedis jedis) {

jedis.del(LOCK_KEY);

}

}以上示例代码仅为简单的演示,实际的 Java 爬虫分布式部署需要根据具体的业务需求和环境进行更详细的设计和实现。同时,还需要考虑错误处理、性能优化、监控和日志记录等方面的问题,以确保分布式爬虫系统的稳定运行和高效工作。