BOSS直聘作为国内领先的招聘平台,拥有海量的职位信息,对于求职者、招聘者以及行业分析师来说,这些数据具有极高的价值。本文将详细介绍如何使用Scrapy框架精准爬取BOSS直聘上特定行业的职位信息,并在爬虫中集成代理服务器以提高爬取的稳定性和安全性。 一、项目背景与目标 BOSS直聘平台提供了丰富的职位信息,涵盖各个行业和领域。对于特定行业的深入分析,如互联网、金融、医疗等,精准获取该行业的职位数据至关重要。通过这些数据,可以分析行业人才需求趋势、薪资水平、技能要求等,为相关利益方提供决策支持。Scrapy作为一个高效、灵活的Python爬虫框架,非常适合用于此类数据爬取任务。本文的目标是构建一个Scrapy爬虫,能够精准爬取BOSS直聘上特定行业的职位信息,并通过代理服务器确保爬虫的稳定运行。 二、环境搭建与项目初始化

- 环境搭建 确保你的开发环境中已安装Python。推荐使用Python 3.8及以上版本。接着,安装Scrapy框架: 安装完成后,通过在终端输入 scrapy 命令来验证安装是否成功。

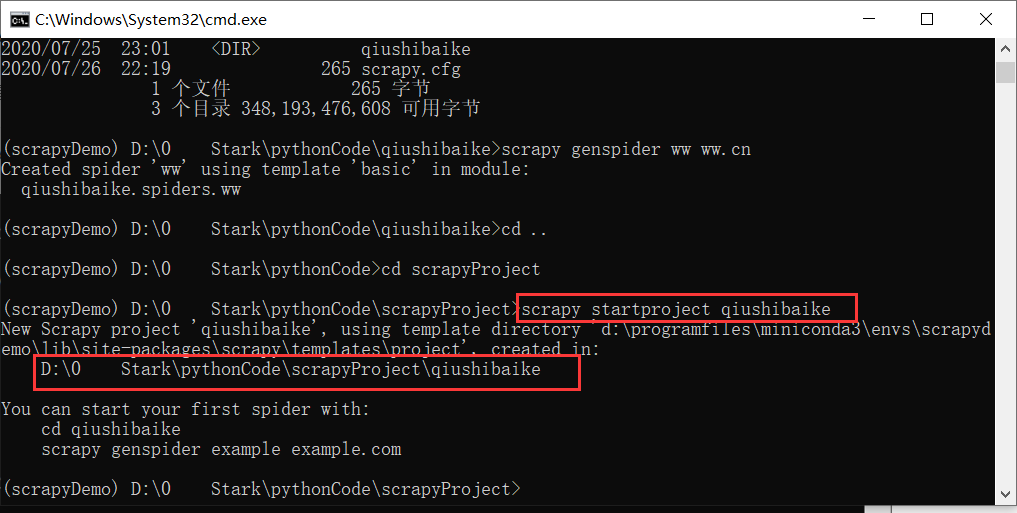

- 创建Scrapy项目 在合适的目录下,执行以下命令创建一个新的Scrapy项目: 这将生成一个名为 bosszhipin 的项目目录,包含多个预定义的文件和文件夹,如 items.py、middlewares.py、pipelines.py 和 settings.py 等。 三、编写爬虫代码

- 定义数据项

在 items.py 文件中定义一个数据项类,用于存储爬取到的职位信息:

import scrapy

class JobItem(scrapy.Item): job_name = scrapy.Field() # 职位名称 salary = scrapy.Field() # 薪资范围 company_name = scrapy.Field() # 公司名称 city = scrapy.Field() # 工作城市 experience = scrapy.Field() # 工作经验要求 education = scrapy.Field() # 学历要求 job_description = scrapy.Field() # 职位描述

2. 编写爬虫

在 spiders 目录下创建一个新的爬虫文件,例如 job_spider.py。编写爬虫代码,包括定义爬虫类、设置爬虫名称、起始URL、解析方法等:

``` python

import scrapy

from bosszhipin.items import JobItem

class JobSpider(scrapy.Spider):

name = 'job_spider'

allowed_domains = ['www.zhipin.com']

start_urls = ['https://www.zhipin.com/c101010100/?query=互联网&page=1']

def parse(self, response):

job_list = response.css('div.job-list ul li')

for job in job_list:

item = JobItem()

item['job_name'] = job.css('div.job-primary div.info-primary h3 a::text').get()

item['salary'] = job.css('div.job-primary div.info-primary h3 span::text').get()

item['company_name'] = job.css('div.job-primary div.info-company div.company-text h3 a::text').get()

item['city'] = job.css('div.job-primary div.info-primary p::text').get().split(' ')[0]

item['experience'] = job.css('div.job-primary div.info-primary p::text').get().split(' ')[1]

item['education'] = job.css('div.job-primary div.info-primary p::text').get().split(' ')[2]

detail_url = job.css('div.job-primary div.info-primary h3 a::attr(href)').get()

yield response.follow(detail_url, self.parse_detail, meta={'item': item})

next_page = response.css('div.page a.next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)

def parse_detail(self, response):

item = response.meta['item']

item['job_description'] = response.css('div.job-sec div.text::text').get()

yield item- 集成代理服务器

为了提高爬虫的稳定性和安全性,我们将在爬虫中集成代理服务器。在 middlewares.py 文件中添加代理中间件:

在 settings.py 文件中启用该中间件:

import scrapy

class JobItem(scrapy.Item): job_name = scrapy.Field() # 职位名称 salary = scrapy.Field() # 薪资范围 company_name = scrapy.Field() # 公司名称 city = scrapy.Field() # 工作城市 experience = scrapy.Field() # 工作经验要求 education = scrapy.Field() # 学历要求 job_description = scrapy.Field() # 职位描述

四、数据处理与存储

1. 数据清洗

在爬取到的数据中,可能会存在一些不需要的信息或格式不规范的数据。可以在 parse 和 parse_detail 方法中,对数据进行简单的清洗。例如,去除薪资范围中的“元/月”字样,提取出具体的薪资数值;去除职位描述中的HTML标签等。

2. 数据存储

Scrapy提供了多种数据存储方式,如存储到JSON文件、CSV文件、数据库等。在 pipelines.py 文件中定义一个数据处理管道,用于将数据存储到指定的格式中。以下是一个将数据存储到JSON文件的示例:

``` python

import json

class JsonPipeline(object):

def open_spider(self, spider):

self.file = open('jobs.json', 'w', encoding='utf-8')

def close_spider(self, spider):

self.file.close()

def process_item(self, item, spider):

line = json.dumps(dict(item), ensure_ascii=False) + '\n'

self.file.write(line)

return item在 settings.py 文件中启用该管道:

ITEM_PIPELINES = {

'bosszhipin.pipelines.JsonPipeline': 300,

}五、运行爬虫 在项目根目录下,通过以下命令运行爬虫:

scrapy crawl job_spider爬虫将开始爬取BOSS直聘上互联网行业的职位数据,并将数据存储到 jobs.json 文件中。 六、注意事项与优化建议

- 遵守网站协议 在爬取数据时,应遵守BOSS直聘的网站协议和法律法规,不要对网站造成过大的负担或影响其正常运行。

- 处理反爬机制 BOSS直聘可能会有一定的反爬机制,如IP限制、请求频率限制等。可以通过设置代理IP、随机请求头、调整下载延迟等方式来应对反爬机制。

- 优化性能 在保证数据准确性和爬取效率的前提下,合理设置并发请求的数量、下载延迟等参数,以优化爬虫性能。

- 数据分析与应用 爬取到的职位数据可以用于多种分析和应用,如行业薪资水平分析、人才需求趋势预测、企业招聘策略优化等。可以结合数据分析工具和可视化技术,深入挖掘数据的价值,为企业和求职者提供有价值的参考和建议。