01

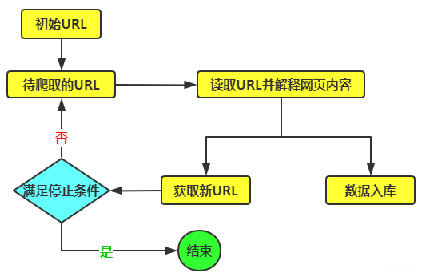

- 网络爬虫简介 网络爬虫是一种能够自动获取和解析网页内容的工具,利用C语言编写网络爬虫程序能够有效地提取所需数据。通过C语言,您可以轻松地实现对网页的解析和数据的提取。

1.1 ◆ C语言与网络爬虫 在C语言中,您可以利用诸如cspider这样的库来简化网络爬虫的编写。这个库提供了丰富的功能,使得解析网页和提取数据变得轻而易举。您只需自定义一个解析函数,该函数会接收一个HTML页面字符串作为输入,并执行相应的处理。以下是一个简单的示例:

void parse(cspider_t cspider, char html) {

// 在这里编写您的解析逻辑

// 使用cspider库提供的功能来解析html字符串,并提取所需数据

}

请注意,这只是一个示例,并且实际的解析逻辑会因您的需求而有所不同。您需要参考cspider库的文档和API来了解如何使用它来解析HTML页面并提取所需数据。

1.2 ◆ 使用cspider库

在使用cspider库时,您需要首先设置好相关的库和编译环境。通过调用cs_setopt_threadnum函数,可以为蜘蛛对象指定线程数量,这对于确保爬虫的高效执行至关重要。

1.3 ◆ XPath解析HTML 接下来,我们使用XPath来解析HTML。 XPath是一种有效解析HTML的语言,通过元素的标签名、属性值或位置来查找和提取数据,大大提升了数据提取的效率。它允许我们通过元素的标签名、属性值或位置来定位和提取数据。以下是一个简单的示例,展示如何使用XPath来解析HTML:

int size = xpath(d, "//div[@class='target-class']");

在这个示例中,我们假设d是一个包含HTML文档的字符串,而XPath表达式"//div[@class='target-class']"用于定位所有具有class属性值为target-class的div元素。函数xpath将返回这些元素的数量,即size。您可以根据实际需求修改XPath表达式来提取所需的数据。

02 2. HTML解析与数据持久化 在HTML解析过程中,我们获取到了电影名称等数据。为了将这些数据持久化保存,我们需要调用一个数据持久化函数,如saveString()。这个函数接受从解析函数中获取的数据作为参数,并进行相应的保存操作。

2.1 ◆ 数据持久化与配置 在设置好要抓取的页面URL、用户代理字符串和包含多个键值对的cookie字符串后,我们需要进一步配置蜘蛛对象。例如,传入解析函数和数据持久化函数的指针,以及设置线程数量等选项,这些配置步骤都是为了确保我们的爬虫能够 高效且可靠地运行。

2.2 ◆ 日志文件设置 通过使用fopen函数以"wb+"模式打开一个名为"log"的文件,该文件将用于记录爬虫的日志信息。接着,通过cs_setopt_logfile函数将该文件与蜘蛛对象相关联。这样,在爬虫执行过程中,所有重要的日志信息都将被记录在这个文件中,便于后续分析和调试。

2.3 ◆ 启动爬虫 最后,调用cs_run函数来启动爬虫,并等待其执行完毕。该函数将返回一个结果代码,指示爬虫是否成功执行以及是否存在任何错误。通过检查这个结果代码,我们可以了解爬虫的执行情况,并据此采取相应的处理措施。

03 3. 爬虫优化策略 爬虫程序通常包含数据采集、数据分析和反爬策略三个核心模块。通过针对性地优化这些模块,我们可以确保爬虫能够稳定且持续地执行任务。

3.1 ◆ 采集模块 在爬虫程序中,采集模块是首要环节。目标服务器通常会提供多种接口,如url、app或数据api,以供研发人员选择。针对不同的 采集需求,如数据难度、每日数据量及目标服务器的反爬限制等,研发人员需进行细致的测试,从而挑选出最适合的采集接口和方式。

3.2 ◆ 数据分析模块 在完成数据解析后,数据分析模块需 精心处理异常情况,具备定位重启功能,以确保程序不会异常退出,同时防止数据采集出现遗漏或重复。

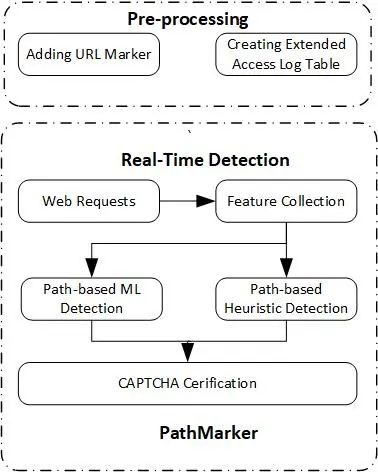

3.3 ◆ 反爬策略模块 反爬策略模块在爬虫程序中至关重要。它 分析目标服务器的爬虫策略,通过控制爬虫请求的频率,甚至包括破解验证码和加密数据,来应对目标服务器的反爬措施。同时,该模块还会寻找优质代理或爬虫代理,以确保业务独享、网络稳定、高并发且低延迟的代理产品,从而确保目标服务器无法实施反爬限制及预警。通过这些优化策略,爬虫程序能够长期稳定地运行。

示例: http://0477aikfp.wikidot.com/ http://028aikfp.wikidot.com/ http://029aikfp.wikidot.com/ http://0871aikfp.wikidot.com/ http://0991aikfp.wikidot.com/ http://021dsp.wikidot.com/ http://028dsp.wikidot.com/ http://029dsp.wikidot.com/ http://0871dsp.wikidot.com/ http://0551dsp.wikidot.com/