作者:京东科技 杨菲

前言

在科技浪潮汹涌澎湃的今天,人工智能与软件开发工具不断迭代升级,深度融合前沿技术来满足个性化知识管理与开发需求,已然成为技术爱好者和开发者们竞相探索的方向。本文将利用 Ollama、Deepseek-R1、AnythingLLM 搭建强大的本地个人知识库,并详细介绍 Continue 在 VScode 中的本地集成,带你解锁全新的技术应用体验,开启高效知识管理与开发的新征程。

一、Ollama+Deepseek-R1+AnythingLLM本地个人知识库搭建

在搭建强大的本地个人知识库以及提升开发效率的技术体系中,Ollama、DeepSeek-R1 和 AnythingLLM 扮演着举足轻重的角色。Ollama 作为模型运行与管理工具,是整个技术架构中的关键枢纽,负责模型的高效调度;DeepSeek-R1 凭借其卓越的语言理解和生成能力,为后续的知识处理和应用提供核心支持;AnythingLLM 则凭借丰富功能,助力构建多样化知识体系,丰富知识储备。

1、Ollama安装

1) 安装前了解

Ollama 是什么?

Ollama 是一个开源项目,用于运行和管理大型语言模型(LLM)的工具或平台。它提供了一个简化的框架,让用户能够在个人计算机或服务器上部署和运行这些模型,而无需依赖云端服务。Ollama 支持多种模型,并允许用户通过命令行或 API 与模型进行交互。

为什么 DeepSeek 本地化部署先安装 Ollama?

DeepSeek 是一个基于大型语言模型的应用,可以独立配置部署。

不过使用Ollama 提供的本地化部署能力,有以下几个原因:

1.模型管理:Ollama 简化了大型语言模型的下载、安装和管理,DeepSeek 需要这些模型来运行。

2.本地运行:Ollama 支持在本地运行模型,确保数据隐私和安全,这对 DeepSeek 的本地化部署至关重要。

3.性能优化:Ollama 针对本地环境进行了优化,确保模型在本地硬件上高效运行,提升 DeepSeek 的性能。

4.依赖集成:在其它工具中集成能简化部署、高效管理模型、优化性能,还能借助社区生态拓展应用。

2)官网下载

打开官网:ollama官网 ( https://ollama.com/ ),点击DownLoad,选择与自己电脑匹配的版本进行下载,我的电脑是Mackbook Pro,芯片是 Apple M3 Pro,所以下载macOS。

3)安装Ollama

下载到本地后,只需双击对应的下载包,按照安装向导的提示逐步完成安装操作。安装完成后,点击启动按钮,此时你便能在电脑右上角的任务栏中看到已启动的 Ollama 应用图标,

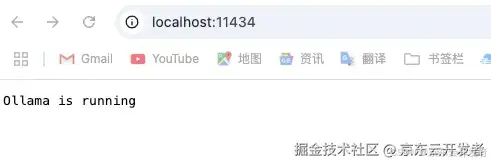

然后使用浏览器检查是否安装启动成功,地址: http://localhost:11434/ ,如果页面显示“Ollama is running”,则代表启动成功

📢 后面的安装,注意不要退出Ollama哦~

2、DeepSeek-R1安装

1)安装前了解

deepseek-r1下载方式

方式有"Download via Ollama"和"Download via Hugging Face"途径下载,本文是通过ollama来下载,直接打开地址选好模型: deepseek-r1下载 ( https://ollama.com/library/deepseek-r1 )

为什么 Apple M3 Pro 18GB 的设备最后还是要选择DeepSeek-R1 的 1.5b 版本?

按照理想状态的选择逻辑是:

•最佳选择:7b 版本(尤其是量化版本),在性能和资源占用之间取得最佳平衡。

•轻量级选择:1.5b 版本,适合对性能要求不高的场景。

•高性能选择:如果 DeepSeek-R1 提供 8b 量化版本,可以尝试运行,但需要监控内存使用情况。

但实际运行发现,如果涉及代码较多的改动或生成个小项目,电脑会卡顿,所以:

对于 Apple M3 Pro 18GB 的设备,推荐运行 DeepSeek-R1 的 1.5b 版本。如果任务稍复杂,可以选择 DeepSeek-R1 的 7b 版本。但是运行较大模型时,务必监控内存使用情况,避免系统资源不足。

📢 我本机使用的DeepSeek-R1 的 7b版本,后续介绍依于此哈!!!

硬件配置可以参考

| 模型参数规模 | 典型用途 | CPU 建议 | GPU 建议 | 内存建议 (RAM) | 磁盘空间建议 | 适用场景 |

|---|---|---|---|---|---|---|

| 1.5b (15亿) | 小型推理、轻量级任务 | 4核以上 (Intel i5 / AMD Ryzen 5) | 可选,入门级 GPU (如 NVIDIA GTX 1650, 4GB 显存) | 8GB | 10GB 以上 SSD | 小型 NLP 任务、文本生成、简单分类 |

| 7b (70亿) | 中等推理、通用任务 | 6核以上 (Intel i7 / AMD Ryzen 7) | 中端 GPU (如 NVIDIA RTX 3060, 12GB 显存) | 16GB | 20GB 以上 SSD | 中等规模 NLP、对话系统、文本分析 |

| 14b (140亿) | 中大型推理、复杂任务 | 8核以上 (Intel i9 / AMD Ryzen 9) | 高端 GPU (如 NVIDIA RTX 3090, 24GB 显存) | 32GB | 50GB 以上 SSD | 复杂 NLP、多轮对话、知识问答 |

| 32b (320亿) | 大型推理、高性能任务 | 12核以上 (Intel Xeon / AMD Threadripper) | 高性能 GPU (如 NVIDIA A100, 40GB 显存) | 64GB | 100GB 以上 SSD | 大规模 NLP、多模态任务、研究用途 |

| 70b (700亿) | 超大规模推理、研究任务 | 16核以上 (服务器级 CPU) | 多 GPU 并行 (如 2x NVIDIA A100, 80GB 显存) | 128GB | 200GB 以上 SSD | 超大规模模型、研究、企业级应用 |

| 671b (6710亿) | 超大规模训练、企业级任务 | 服务器级 CPU (如 AMD EPYC / Intel Xeon) | 多 GPU 集群 (如 8x NVIDIA A100, 320GB 显存) | 256GB 或更高 | 1TB 以上 NVMe SSD | 超大规模训练、企业级 AI 平台 |

2)安装deepseek-R1

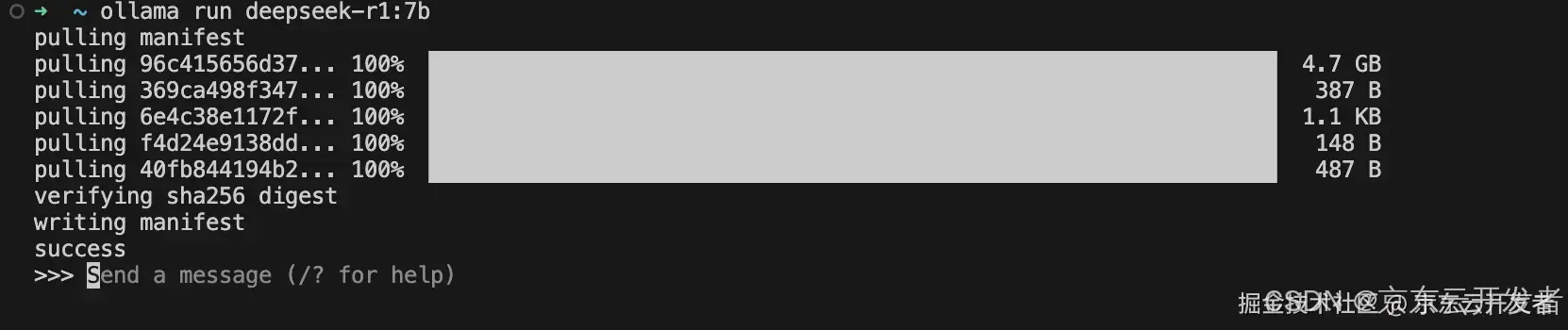

直接在你的终端执行命令行,顺畅开启后续的任务流程吧

ollama run deepseek-r1:7b耐心等待下,这里需要几分钟,等命令执行完成,如下即为成功

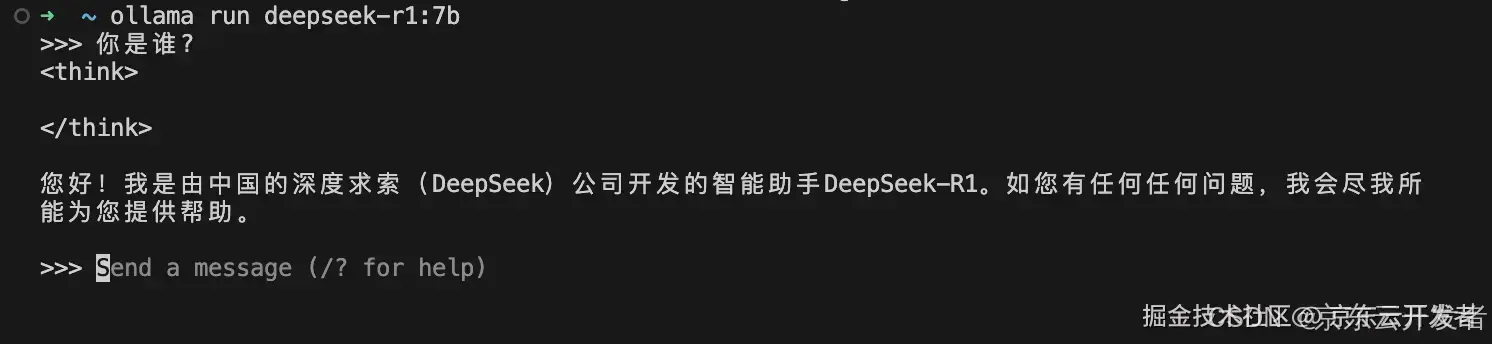

2)经过一番精心的操作与耐心的等待,终于完成了命令行版本的本地化部署,让我们简单试试它。在命令行输入”你是谁?”

如果你怀揣着对更优质界面和更安全个人知识库的期待,那么请不要错过接下来的内容。它将为你指引一条通往更高效、更安全使用体验的道路,让你的本地化部署发挥出更大的价值。

3、AnythingLLM安装

1)安装前了解

AnythingLLM是什么?

AnythingLLM 是一个易于使用的、集成的一体化AI应用,它能够进行检索增强生成(RAG)和AI代理等功能,无需代码或基础设施的担忧。

为什么选择AnythingLLM?

它是一个零设置、私有化且集成了本地LLM、检索增强生成(RAG)和AI代理的一体化应用,所有功能在一个地方实现,无需繁琐的开发者配置。同时它是基于 Javascript 开发,前端工程师对其技术栈可能更熟悉,易于上手和进行二次开发。

MacBook Pro M3 下载哪个?

MacBook Pro M3 采用的是苹果自研的基于 ARM 架构的 Apple Silicon 芯片。“Download for Apple Silicon” 版本的软件是针对这种架构进行原生开发和优化的,所以下载Silicon版本。

2)安装AnythingLLM

安装步骤

a. 访问AnythingLLM官网下载: anythingllm官网 ( https://anythingllm.com/desktop )

****

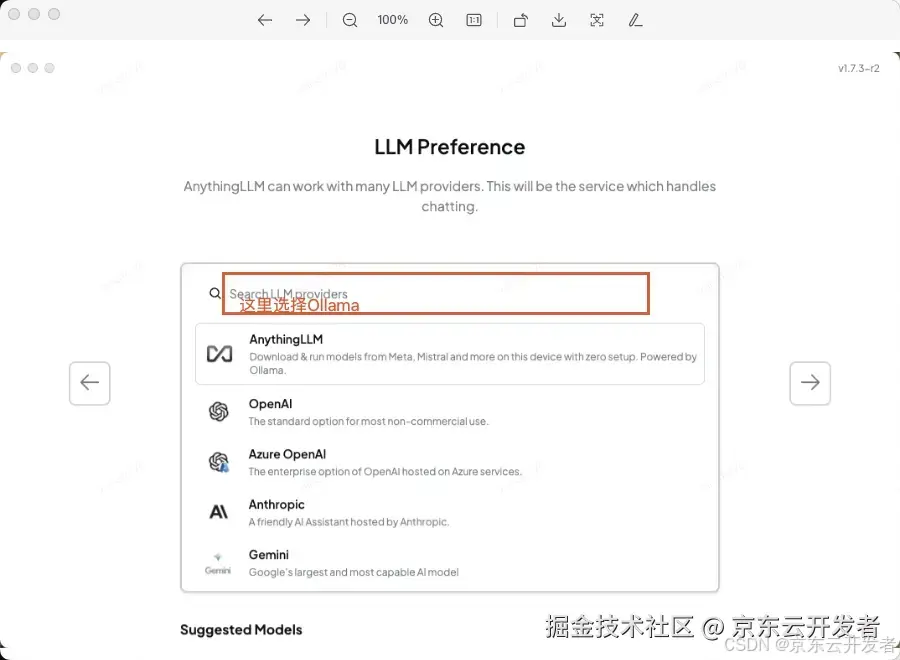

b.打开客户端,点击Get Started, 进入LLM Preference页面选择选择使用Ollama模型工具,

后面的直接点击"Skip",然后后续可以在主界面的设置里进行详细设置

设置步骤

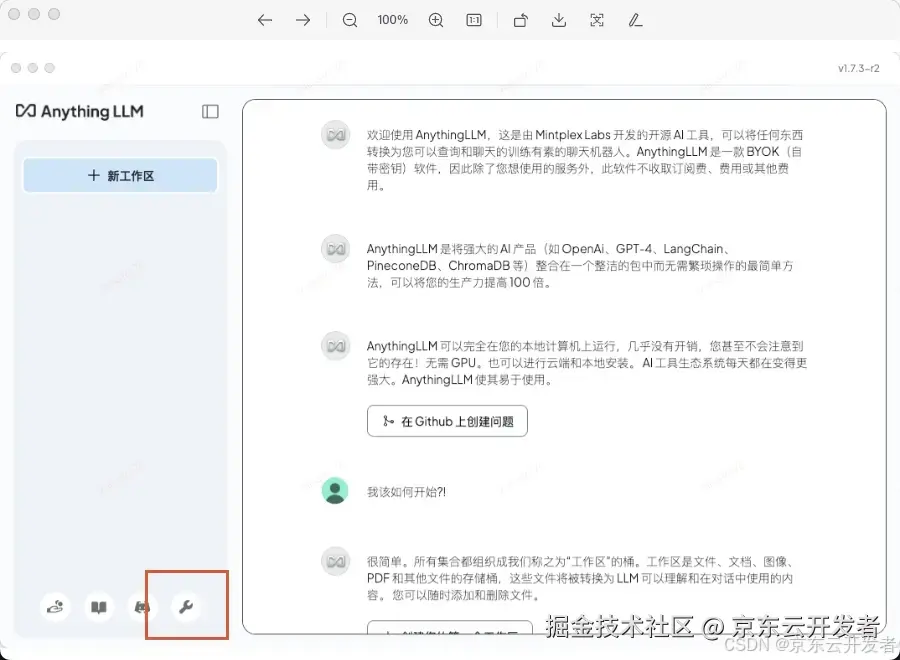

a. 这时进入主界面,点击【左下角】的设置进行详细设置

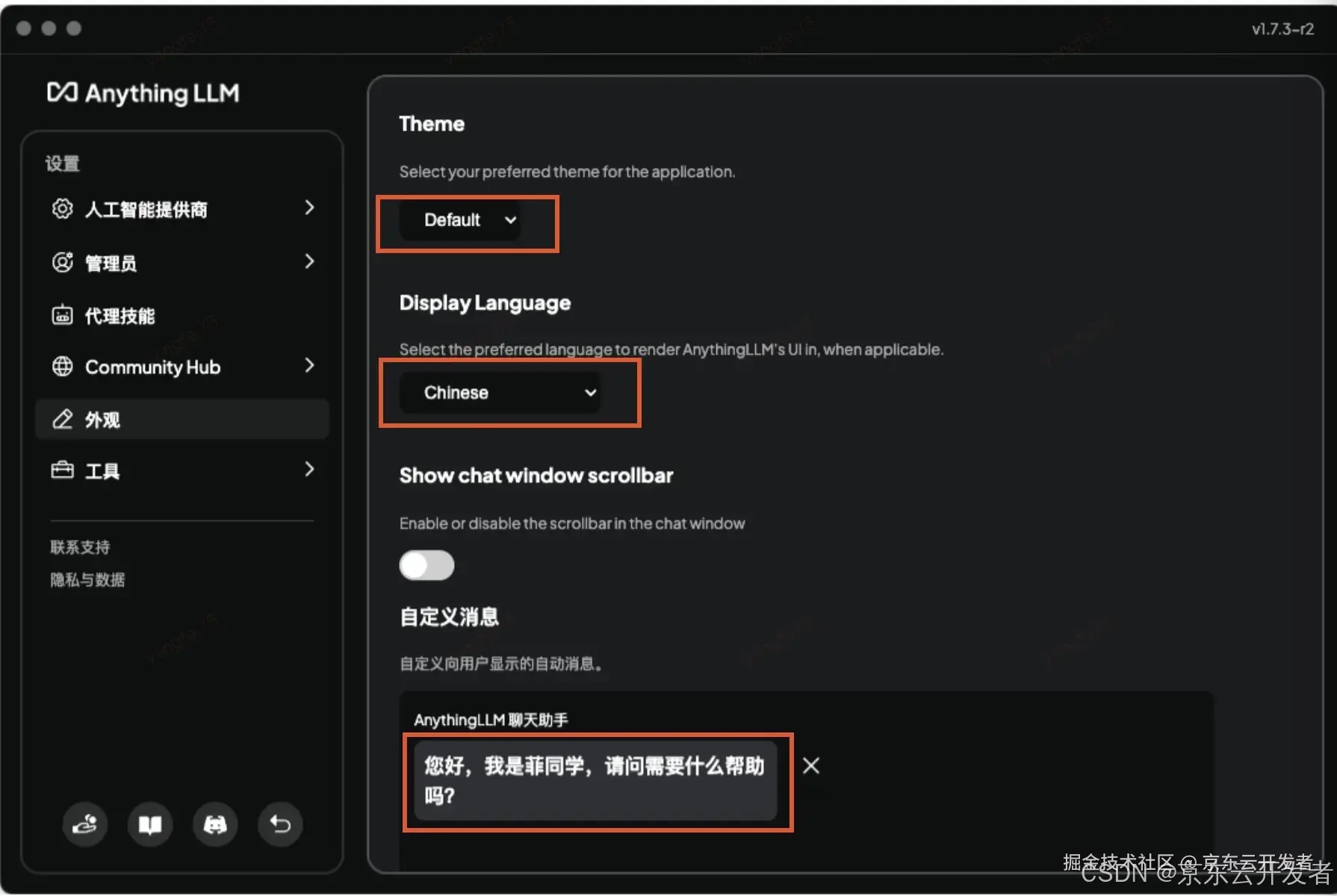

b. 设置外观如下,选择Theme主题,语言和默认聊天消息内容,我选中的是“黑色主题”、“中文”和每次启动消息“您好,我是菲同学,请问需要什么帮助吗?”。

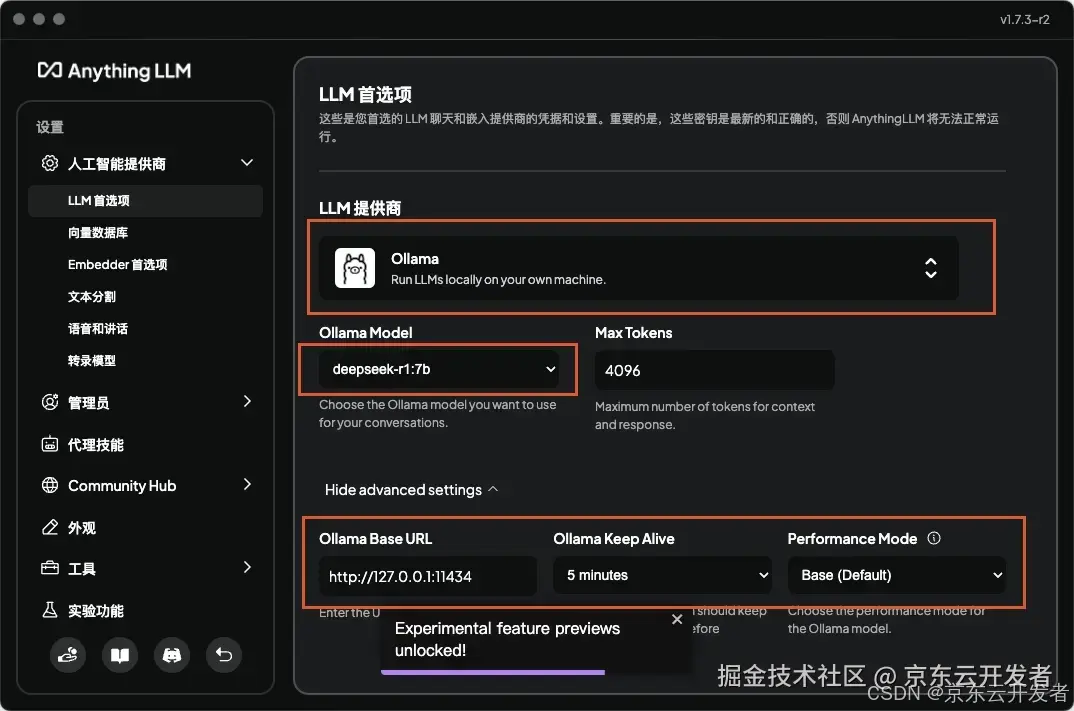

c. 配置模型

选择人工智能提供商 > LLM首选项, LLM提供商选择“ollama”, ollama Model选择安装好的deepseek-r1:7b版本,你们要依据自己安装好的模型进行选择

投喂教程

📢 官网有详细说明:参见 anythingllm官网文档

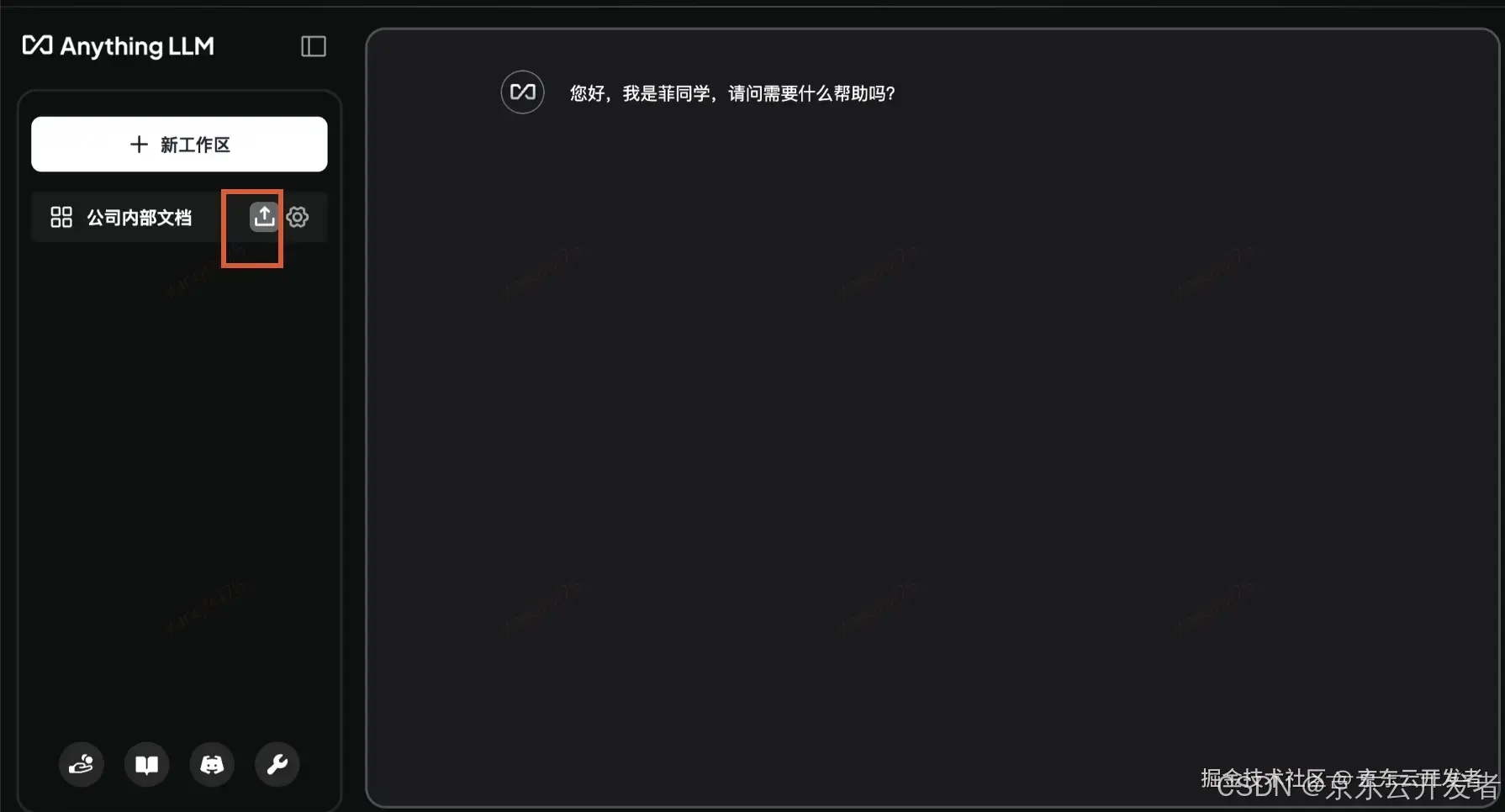

a. 本地文档投喂

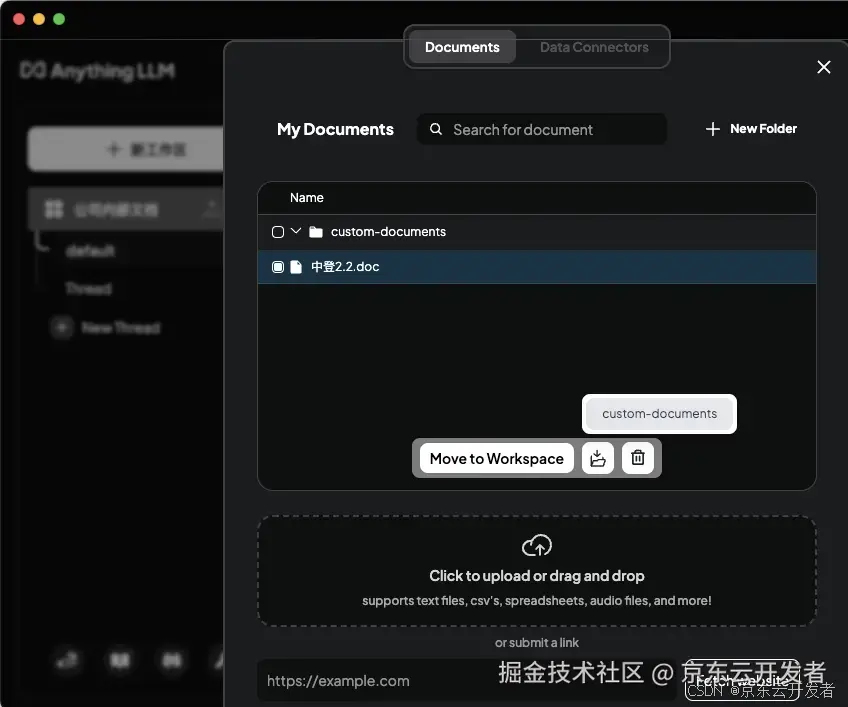

点击工作区的上传按钮,将本地的文档上传

我上传一个“中登2.2”的word文档,上传后选中文档,点击“Move to Workspace”,然后保存

这个时候你的本地投喂就完成了,让我们简单测试下成果,新建一个知识库问答,提问“中登2.2主要说了哪些内容,概括为100字以内”,效果如下

b.浏览器内容投喂

浏览器投喂功能需要同时设置浏览器和Anything LLM客户端,下面我们进行详细的讲解

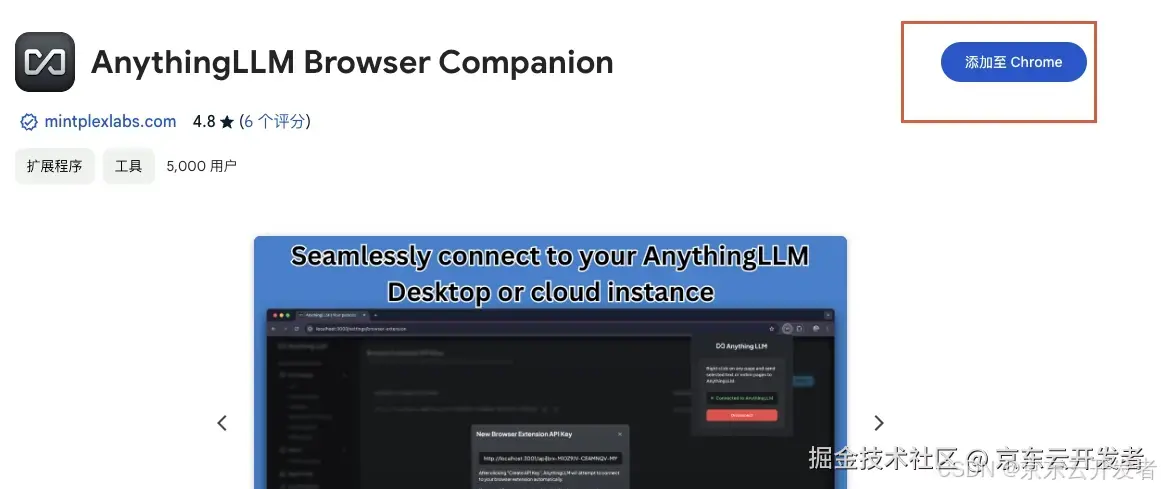

1)浏览器投喂需要先安装一个扩展程序来支持,打开浏览器设置扩展程序: anythingllm扩展程序 ,点击右上角“添加至Chrome”

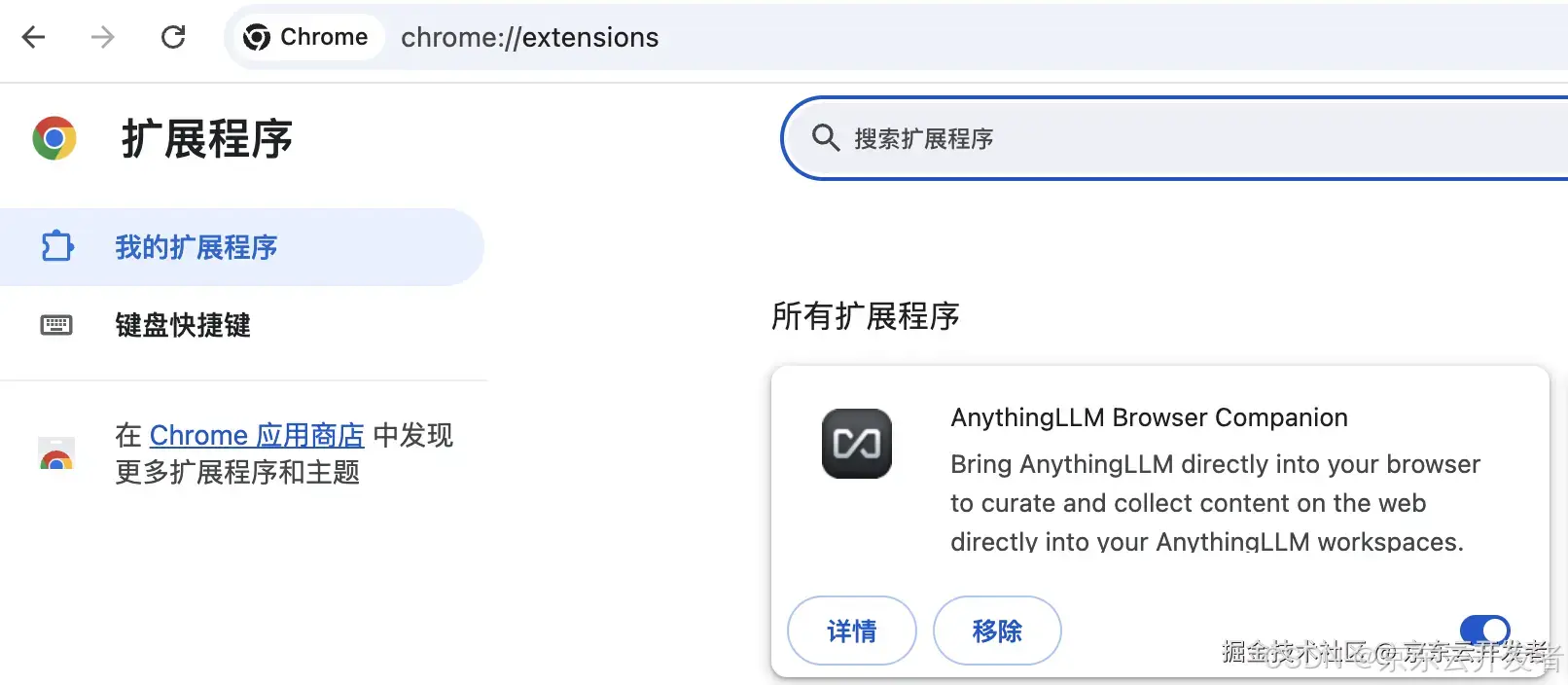

打开chrome://extensions/,这时就可以看到自己安装的扩展程序了,为了使用方便,在浏览器的右上角扩展程序显示区域也加上“AnythingLLM Browser Companion”的显示

2)Anything LLM客户端设置

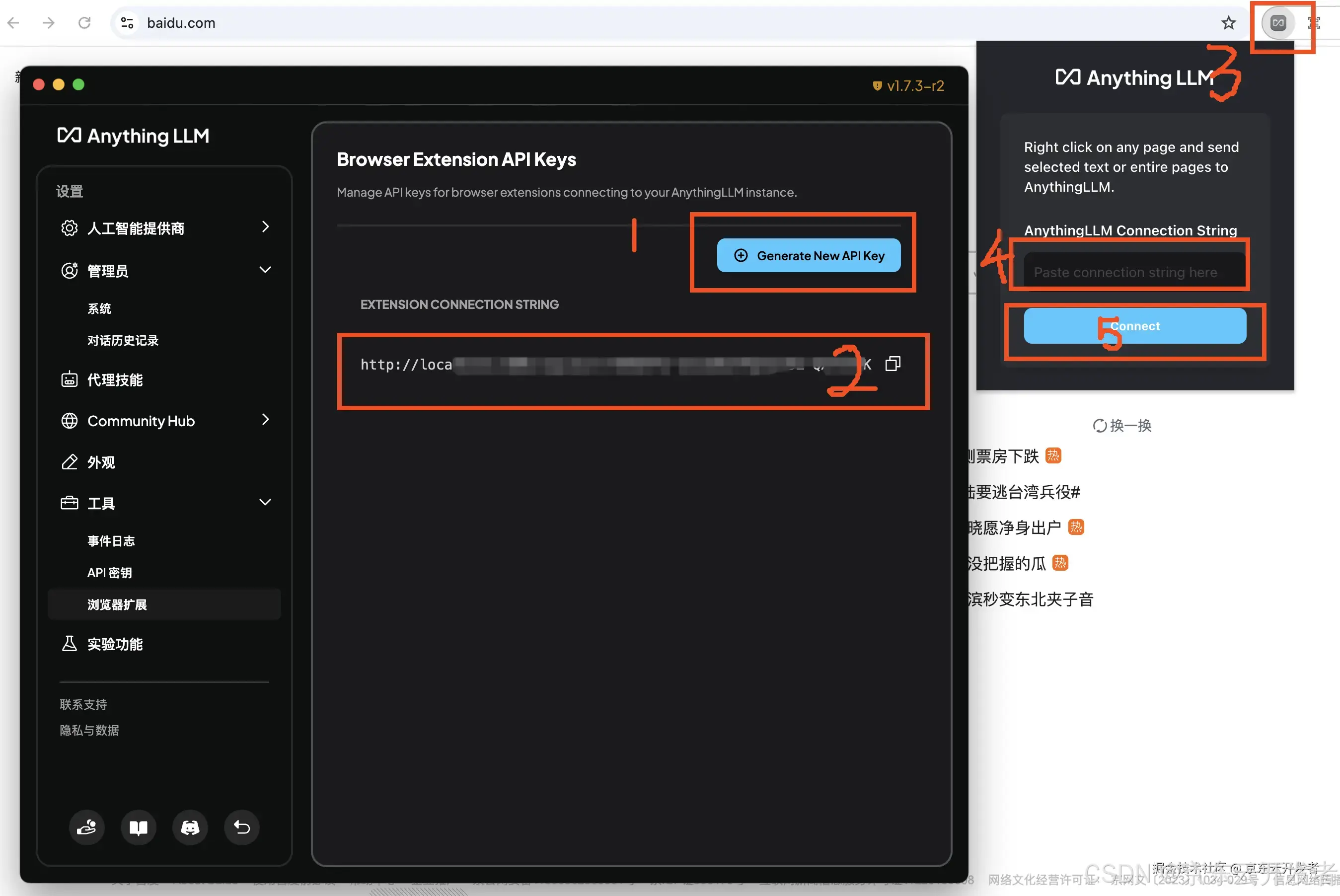

打开Anything LLM客户端,点击Anything LLM的 设置 > 工具 > 浏览器扩展,然后

选择右侧面板的“Generate New API Key”按钮,生成API Key

复制下面的“connecting string”

点击chrome浏览器右侧的Anything LLM扩展程序图标,点击展开,粘贴刚才复制的“Anything LLM Connecting String”

点击“Connect”连接

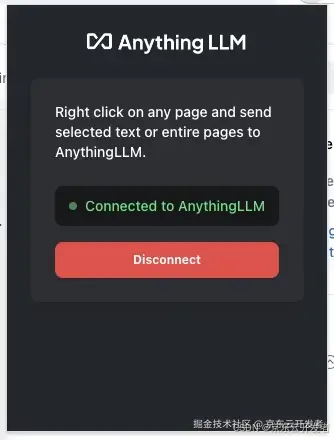

连接成功后状态如下

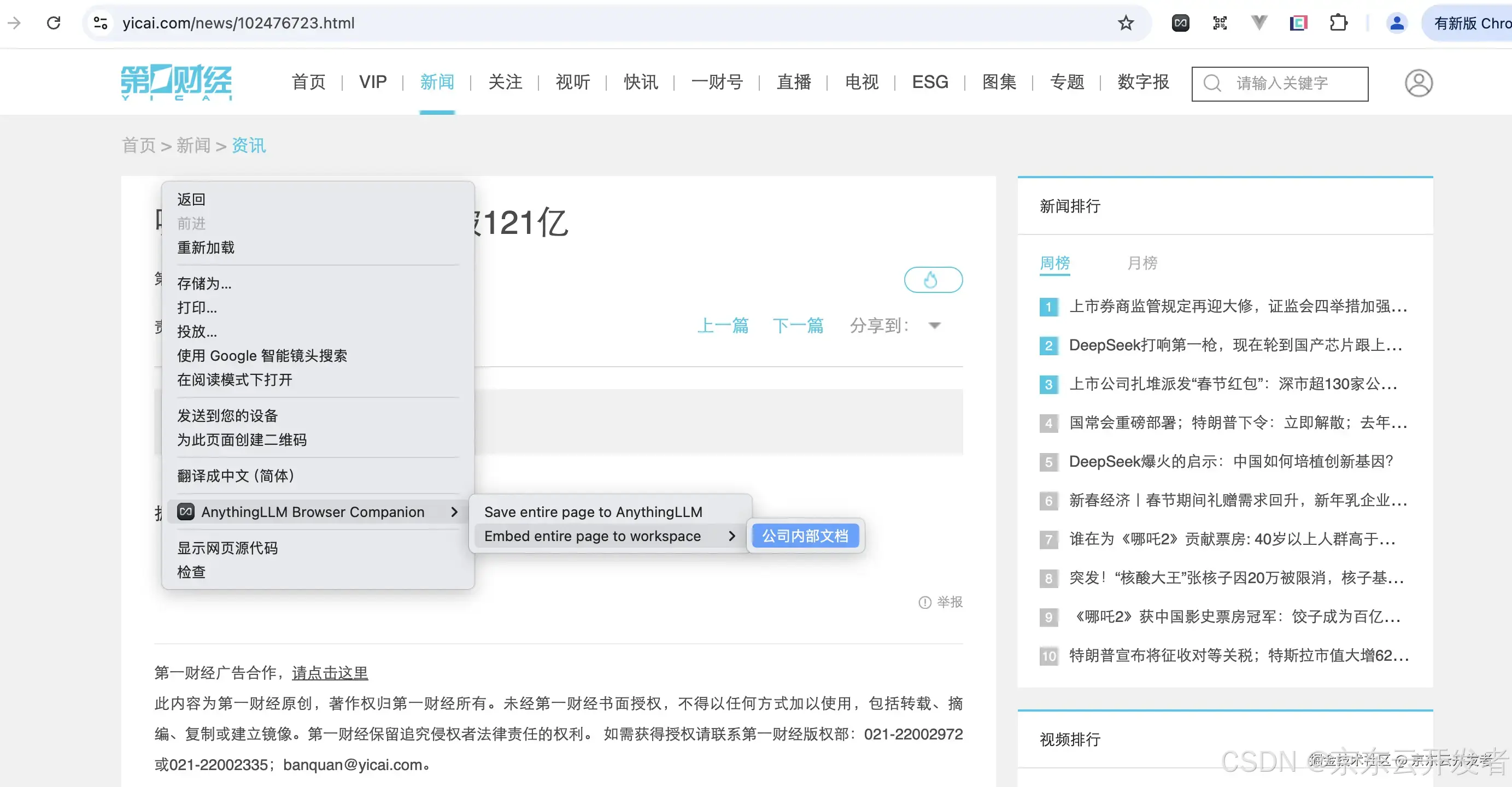

然后我们将内网的一篇文章投喂它,因牵涉公司信息安全,所以我以一个外网网站为例:选择“AnythingLLM Browser Companion” 》 “Embedentirepagetoworkspace” 》 “你自己的工作区名称,这里我起名【公司内部文档】”

检验下成果吧,新建对话“第一财经网站”,提问“根据内部文档查阅,新闻排行周榜的前三个是什么标题?”,效果如下,看结果不错哦~

好了,到这里个人知识库本地化集成终于结束了,赶快用起来吧。

二、 Ollama+Deepseek-R1+Continue本地集成VScode

1)安装前知识点

Continue 介绍

详情可参照官网: continue官网

Continue 是 Visual Studio Code 和 JetBrains 中领先的开源 AI 代码助手。

•在侧边栏中进行聊天以理解和迭代代码。

•自动补全,以便在输入时接收内联代码建议。

•编辑功能可让你无需离开当前文件即可修改代码。

•操作功能用于为常见用例建立快捷方式。

2)安装 VSCode

首先,确保你已经安装了 VS Code 编辑器。如果尚未安装,可以从 VSCode 官网(https://code.visualstudio.com/download )下载并安装。

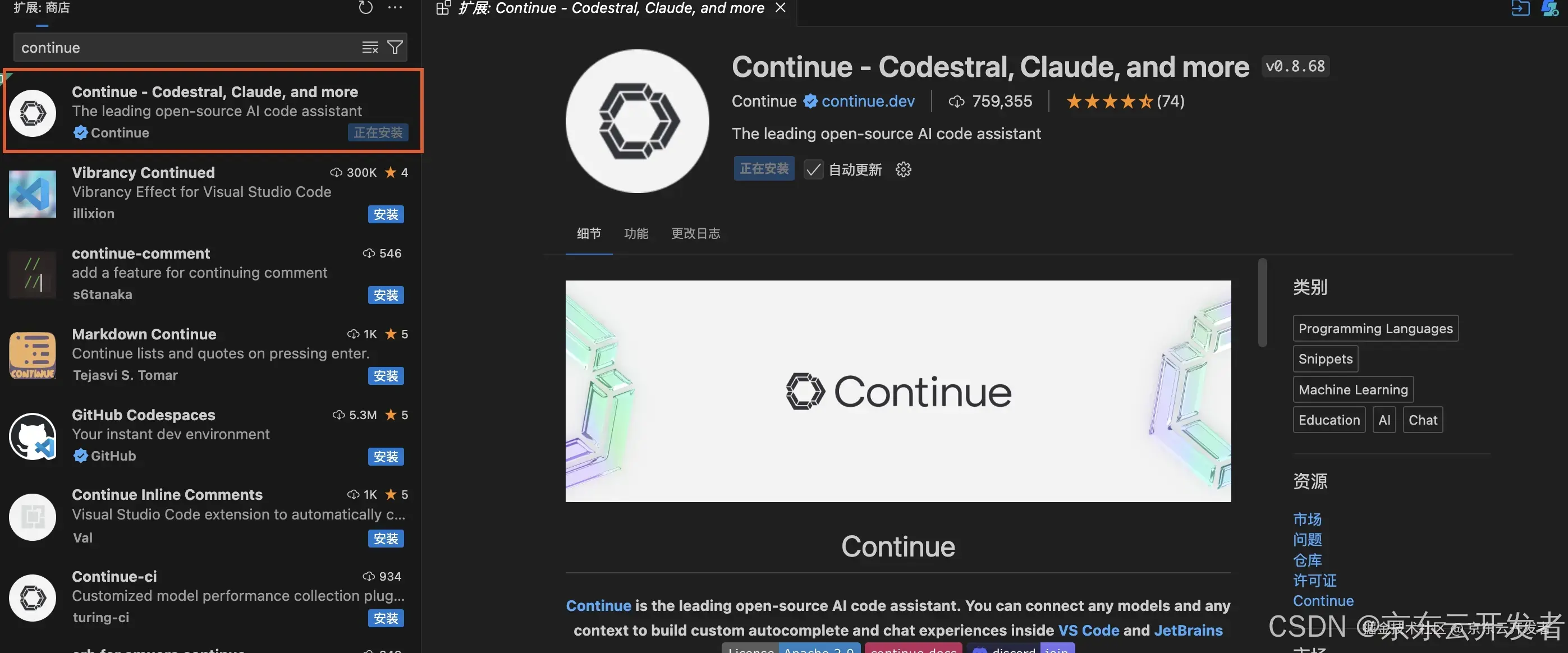

3)安装conitinue插件

a.打开 VSCode 编辑器。

b.在 VSCode 的插件中心,搜索 “Continue”。

c.找到 “Continue” 插件后,点击 “安装” 按钮进行安装。安装完成后,在 VSCode 左侧侧栏中会增加一个对应的图标,这就是 Continue 的主界面。

安装完成之后,重启下continue,vscode上就会出现continue图标,点击“continue”出现主界面

4)本地集成VScode配置

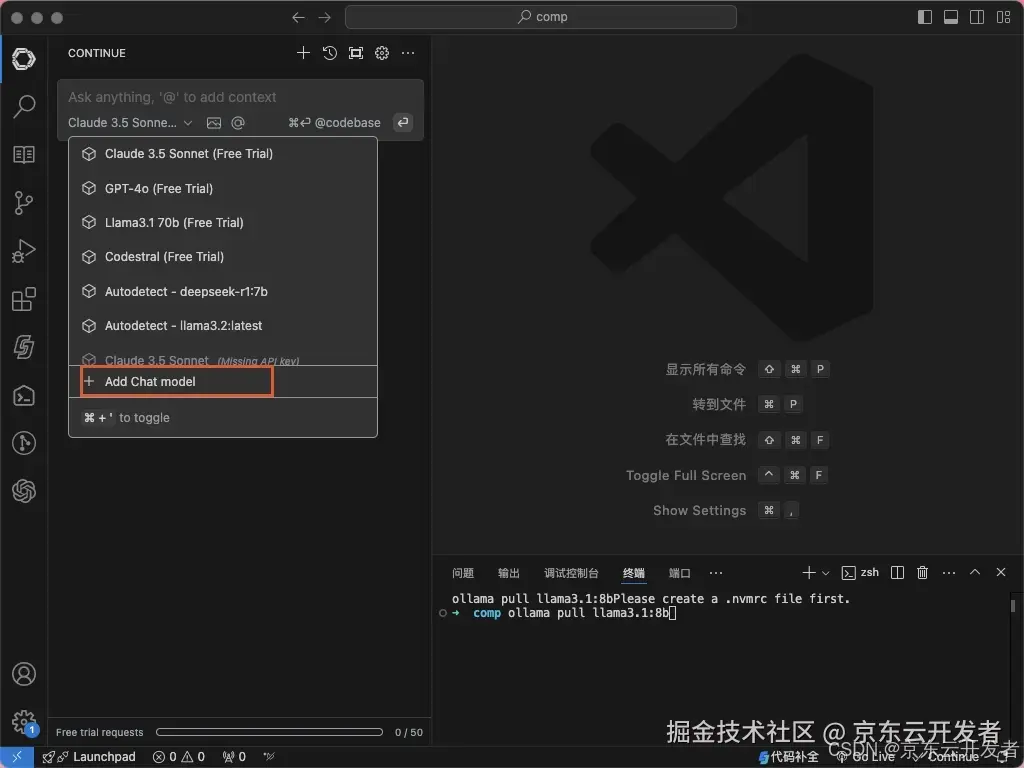

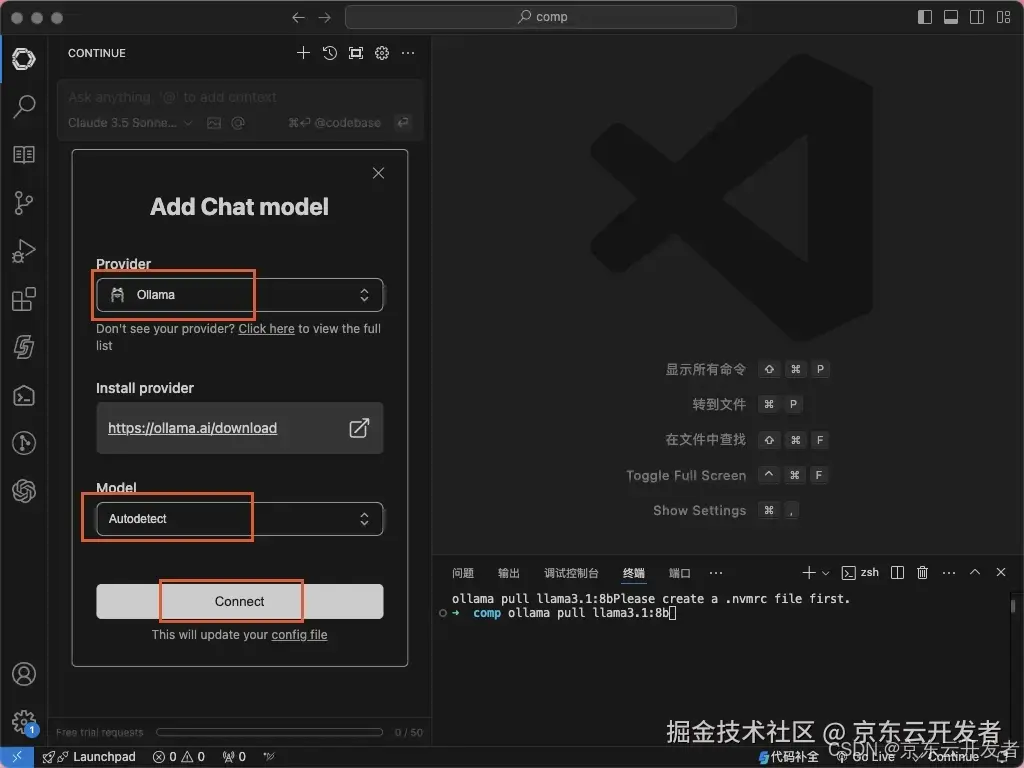

点击continue输入框的左下角,点击“+ Add Chat model”,然后进行配置

配置Provider为“Ollama”,Modal选择“Autodetect”,点击“Connect”

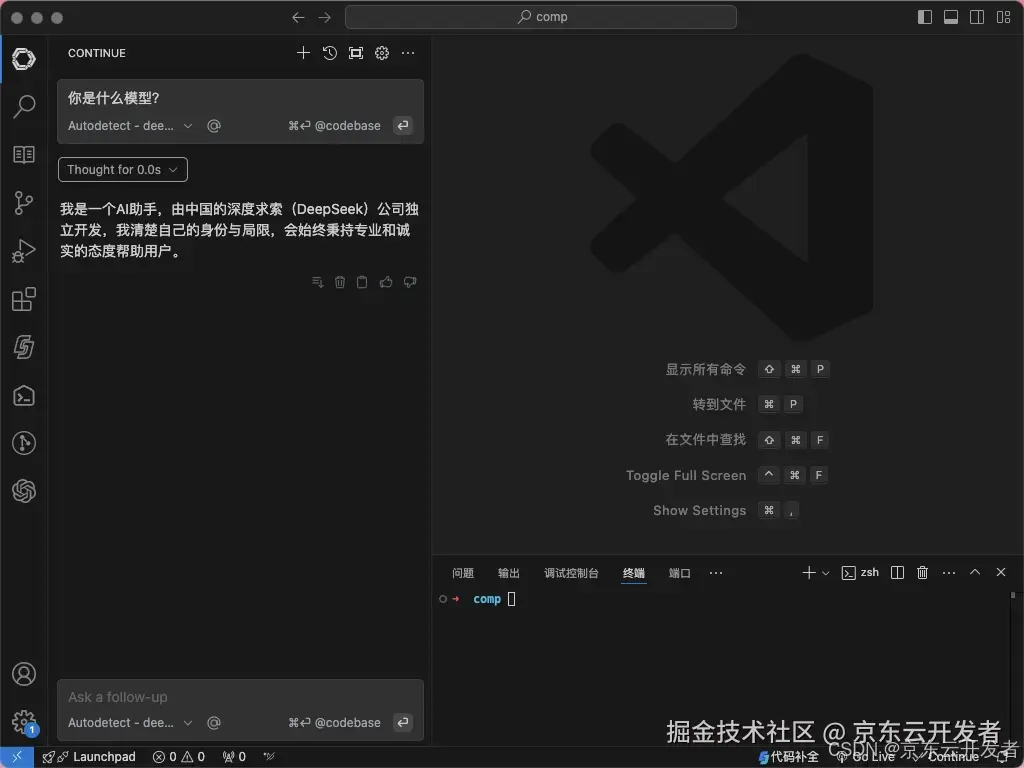

到这里就配置完成了,让我们测试下成果吧,输入问题“你是什么模型?”

通过以上步骤,你就完成了 Continue 在 VSCode 中的本地集成,能够借助其强大的功能提升编程效率,享受更加智能、便捷的开发体验。

三、总结

成功把 Ollama、Deepseek - R1 和 Continue 集成到 VScode 之后,确实避免了很多问题!先说说数据安全,以前总在网络搜索,心里总有点不踏实,现在都在本地搞定,再也不用担心信息泄露了,做涉及敏感信息的项目,安全感满满,对咱开发者来说,这可太香了。

不过,这集成也不是十全十美的。对电脑硬件要求有点高,如果电脑配置不太给力,模型响应速度就会变慢,有时候等得还挺着急,多少还是会影响点效率。但总体来说,这次集成真的让我学到了不少,绝对是一次超值得尝试的技术实践!强烈推荐大家也试试!