简介

主要内容包括

如何将文本处理为Tensorflow LSTM的输入

如何定义LSTM

用训练好的LSTM进行文本分类

代码

导入相关库

#coding=utf-8

import tensorflow as tf

from tensorflow.contrib import learn

import numpy as np

from tensorflow.python.ops.rnn import static_rnn

from tensorflow.python.ops.rnn_cell_impl import BasicLSTMCell

数据

数据

positive_texts = [

"我 今天 很 高兴",

"我 很 开心",

"他 很 高兴",

"他 很 开心"

]

negative_texts = [

"我 不 高兴",

"我 不 开心",

"他 今天 不 高兴",

"他 不 开心"

]

label_name_dict = {

0: "正面情感",

1: "负面情感"

}

配置信息

配置信息

embedding_size = 50

num_classes = 2

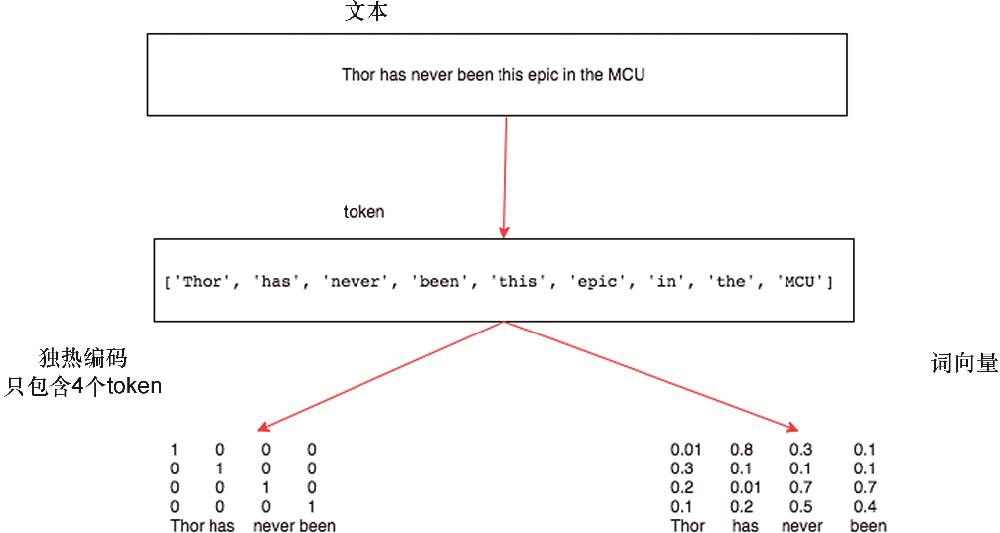

将文本和label数值化

将文本和label数值化

all_texts = positive_texts + negative_textslabels = [0] * len(positive_texts) + [1] * len(negative_texts)

max_document_length = 4

vocab_processor = learn.preprocessing.VocabularyProcessor(max_document_length)

datas = np.array(list(vocab_processor.fit_transform(all_texts)))

vocab_size = len(vocab_processor.vocabulary_)

定义placeholder(容器),存放输入输出

容器,存放输入输出

datas_placeholder = tf.placeholder(tf.int32, [None, max_document_length])

labels_placeholder = tf.placeholder(tf.int32, [None])

词向量处理

词向量表

embeddings = tf.get_variable("embeddings", [vocab_size, embedding_size], initializer=tf.truncated_normal_initializer)

将词索引号转换为词向量[None, max_document_length] => [None, max_document_length, embedding_size]

embedded = tf.nn.embedding_lookup(embeddings, datas_placeholder)

将数据处理为LSTM的输入格式

转换为LSTM的输入格式,要求是数组,数组的每个元素代表某个时间戳一个Batch的数据

rnn_input = tf.unstack(embedded, max_document_length, axis=1)

定义LSTM

定义LSTM

lstm_cell = BasicLSTMCell(20, forget_bias=1.0)

rnn_outputs, rnn_states = static_rnn(lstm_cell, rnn_input, dtype=tf.float32)

#利用LSTM最后的输出进行预测

logits = tf.layers.dense(rnn_outputs[-1], num_classes)

predicted_labels = tf.argmax(logits, axis=1)

定义损失和优化器

定义损失和优化器

losses= tf.nn.softmax_cross_entropy_with_logits(

labels=tf.one_hot(labels_placeholder, num_classes),

logits=logits

)

mean_loss = tf.reduce_mean(losses)

optimizer = tf.train.AdamOptimizer(learning_rate=1e-2).minimize(mean_loss)

执行

with tf.Session() as sess:

初始化变量

sess.run(tf.global_variables_initializer())

训练# 定义要填充的数据

feed_dict = {

datas_placeholder: datas,

labels_placeholder: labels

}

print("开始训练")

for step in range(100):

_, mean_loss_val = sess.run([optimizer, mean_loss], feed_dict=feed_dict)

if step % 10 == 0:

print("step = {}\tmean loss = {}".format(step, mean_loss_val))

预测

print("训练结束,进行预测")

predicted_labels_val = sess.run(predicted_labels, feed_dict=feed_dict)

for i, text in enumerate(all_texts):

label = predicted_labels_val[i]

label_name = label_name_dict[label]

print("{} => {}".format(text, label_name))

分享安排:

目标:

1.掌握大数据建模分析与使用方法。

2.掌握大数据平台技术架构。

3.掌握国内外主流的大数据分析与BI商业智能分析解决方案。

4.掌握大数据分析在搜索引擎、广告服务推荐、电商数据分析、金融客户分析方面的应用。

5.掌握主流的基于大数据Hadoop和Spark、R的大数据分析平台架构和实际应用。

6.掌握基于Hadoop大数据平台的数据挖掘和数据仓库分布式系统平台应用,以及商业和开源的数据分析产品加上Hadoop平台形成大数据分析平台的应用剖析。

7.掌握常见的机器学习算法。

具体内容:

一、大数据概述:1.大数据及特点分析;2.大数据关健技术;3.大数据计算模式;4.大数据应用实例

二、大数据处理架构Hadoop:1.Hadoop项目结构;2.Hadoop安装与使用;3.Hadoop集群的部署与使用;4.Hadoop 代表性组件

三、分布式文件系统HDFS :1.HDFS体系结构;2.HDFS存储;3.HDFS数据读写过程

四、分布式数据库HBase :1.HBase访问接口;2.HBase数据类型;3.HBase实现原理;4.HBase运行机制;5.HBase应用

五、MapReduce :1.MapReduce体系结构;2.MapReduce工作流程;3.资源管理调度框架YARN ;4.MapReduce应用

六、Spark :1.Spark生态与运行架构;2.Spark SQL;3.Spark部署与应用方式

七、IPython Notebook运行Python Spark程序:1.Anaconda;2.IPython Notebook使用Spark;3.使用IPython Notebook在Hadoop YARN模式运行

八、Python Spark集成开发环境 :1.Python Spark集成开发环境部署配置;2.Spark数据分析库MLlib的开发部署

九、Python Spark决策树二分类与多分类 :1.决策树原理;2.大数据问题;3.决策树二分类;4.决策树多分类

十、Python Spark支持向量机 :1.支持向量机SVM 原理与算法;2.Python Spark SVM程序设计

十一、Python Spark 贝叶斯模型 :1.朴素贝叶斯模型原理;2.Python Spark贝叶斯模型程序设计

十二、Python Spark逻辑回归 :1.逻辑回归原理;2.Python Spark逻辑回归程序设计

十三、Python Spark回归分析 :1.大数据分析;2.数据集介绍;3.Python Spark回归程序设计

十四、Spark ML Pipeline 机器学习流程分类 :1.机器学习流程组件:StringIndexer、OneHotEncoder、VectorAssembler等

2.使用Spark ML Pipeline 机器学习流程分类程序设计

十五、Python Spark 创建推荐引擎 :1.推荐算法;2.推荐引擎大数据分析使用场景;3.推荐引擎设计

十六、项目实践:1.日志分析系统与日志挖掘项目实践;2.推荐系统项目实践

关注 我 并发布评论,来获取更多有效资料吧!!!