向AI转型的程序员都关注了这个号👇👇👇

机器学习AI算法工程 公众号:datayx

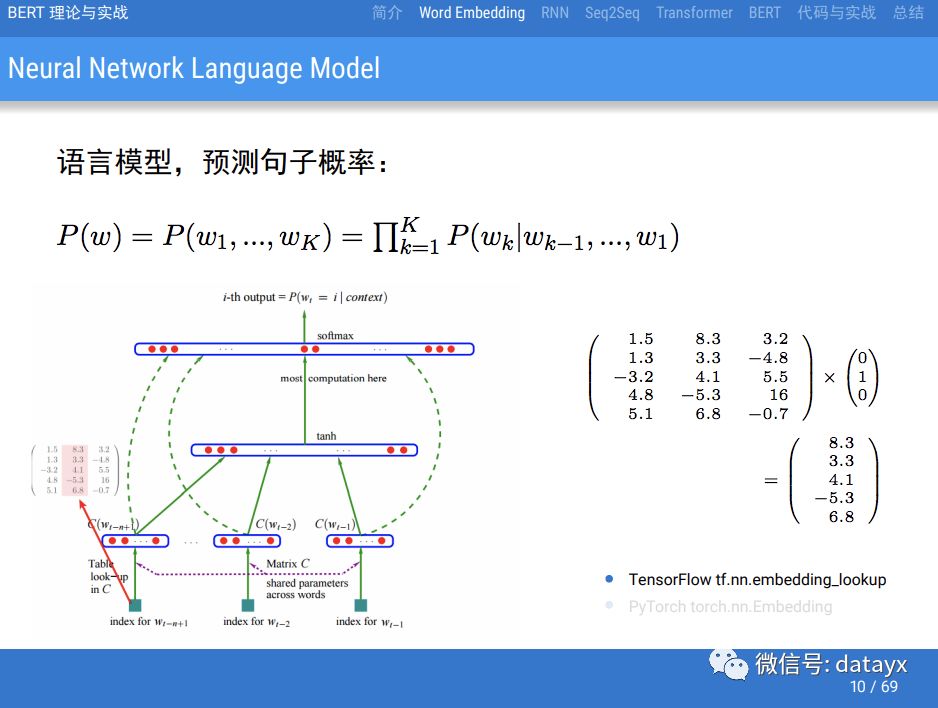

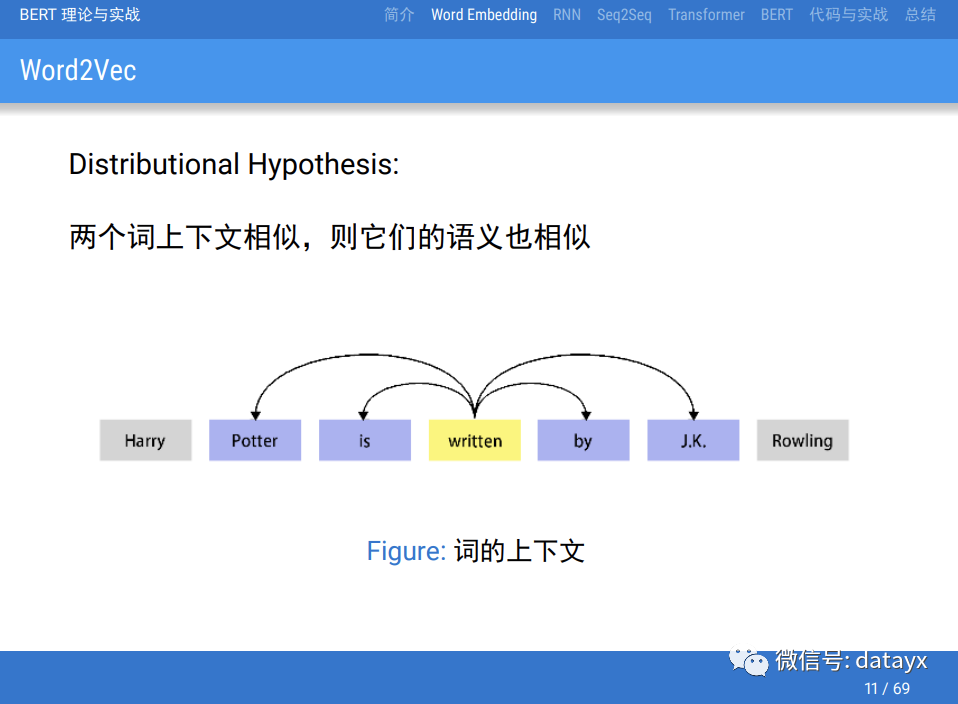

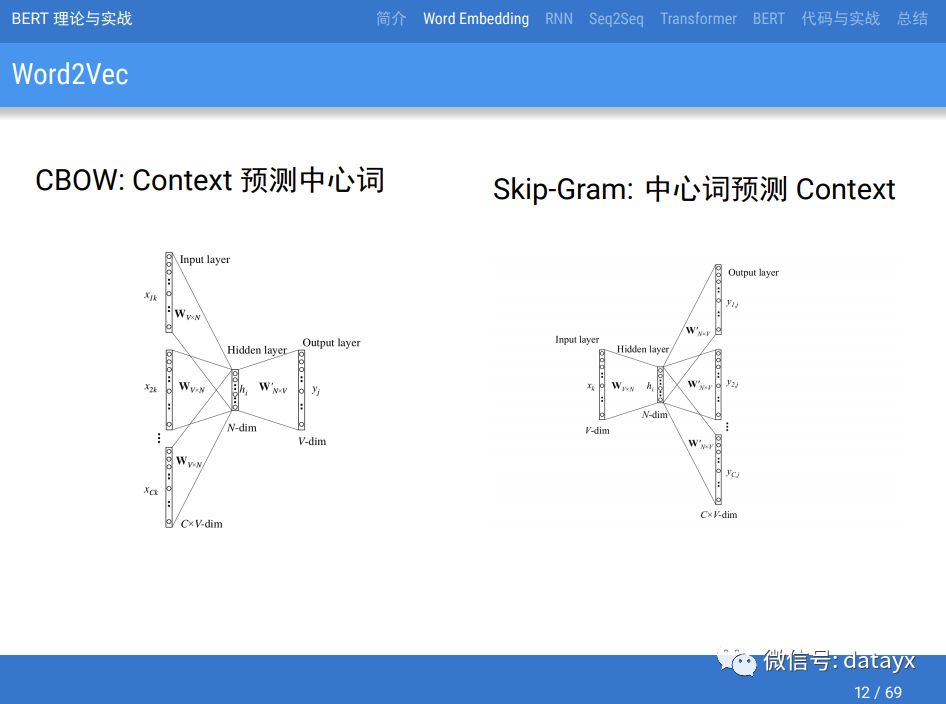

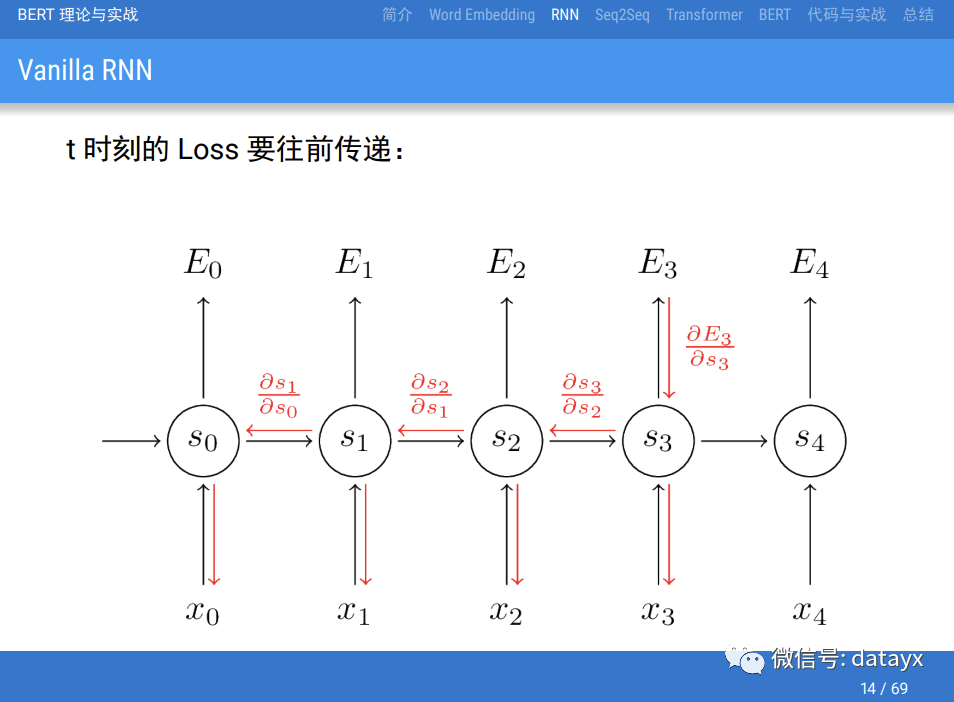

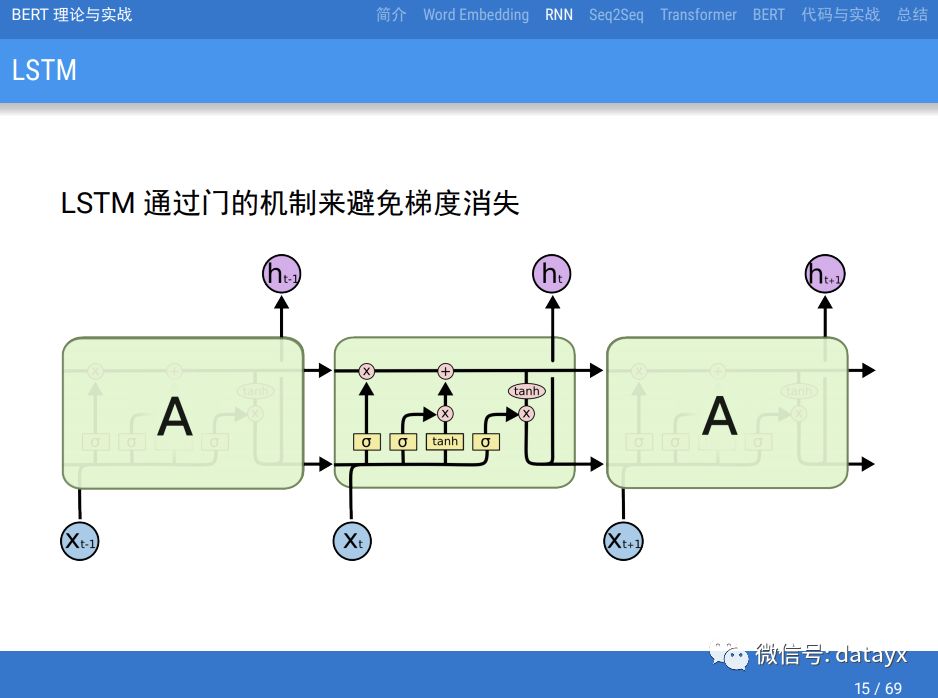

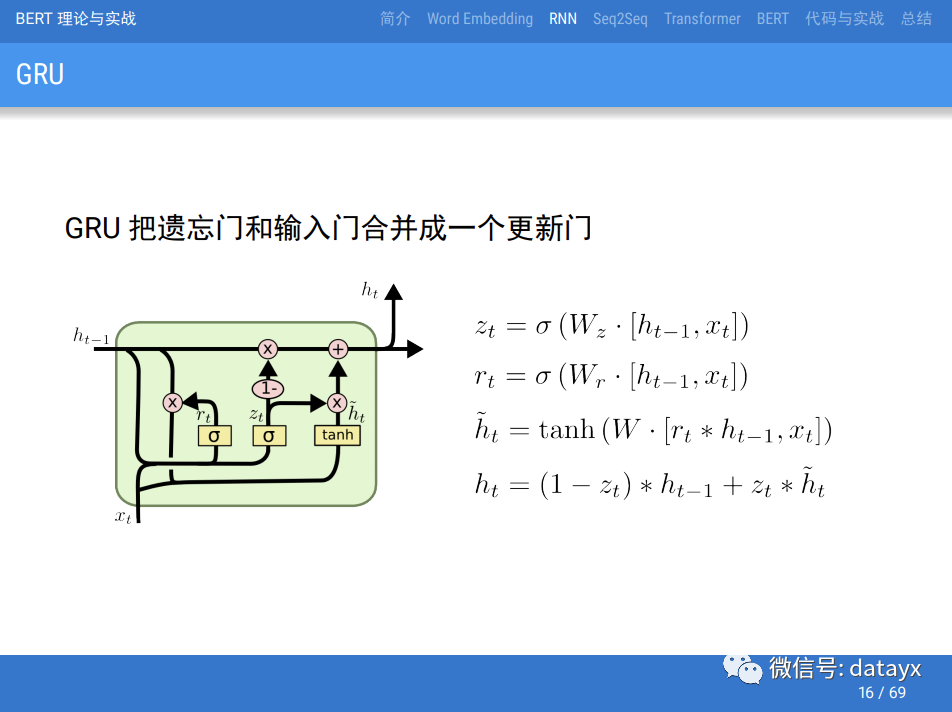

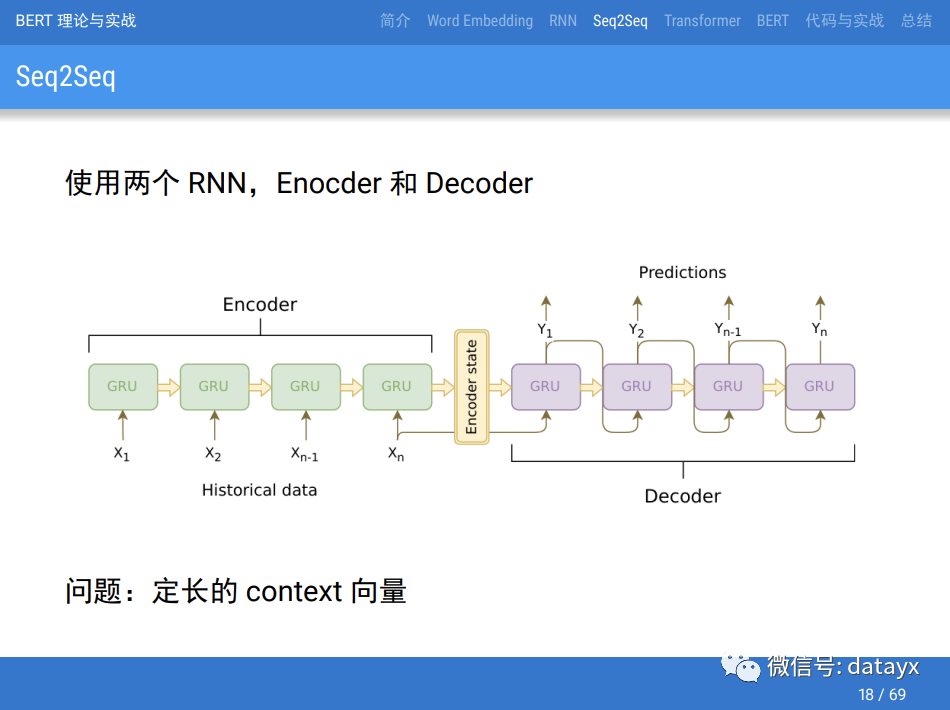

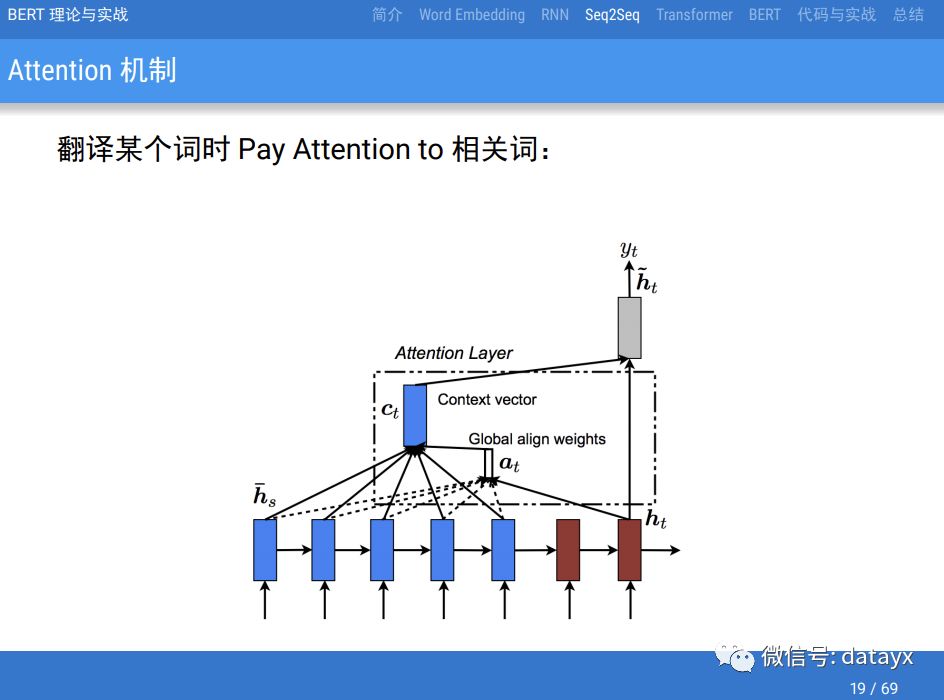

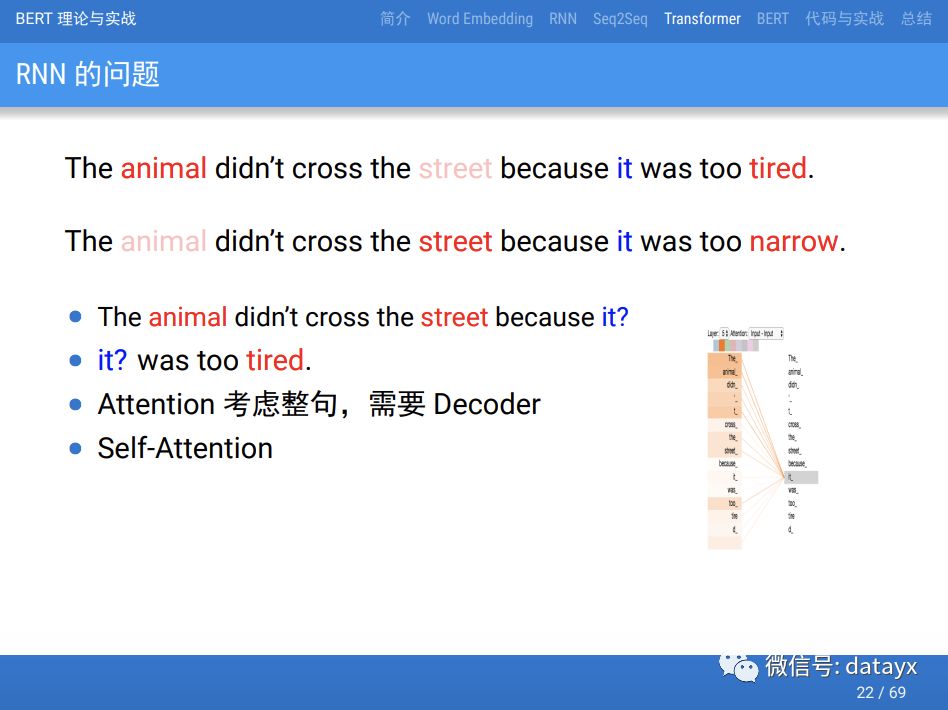

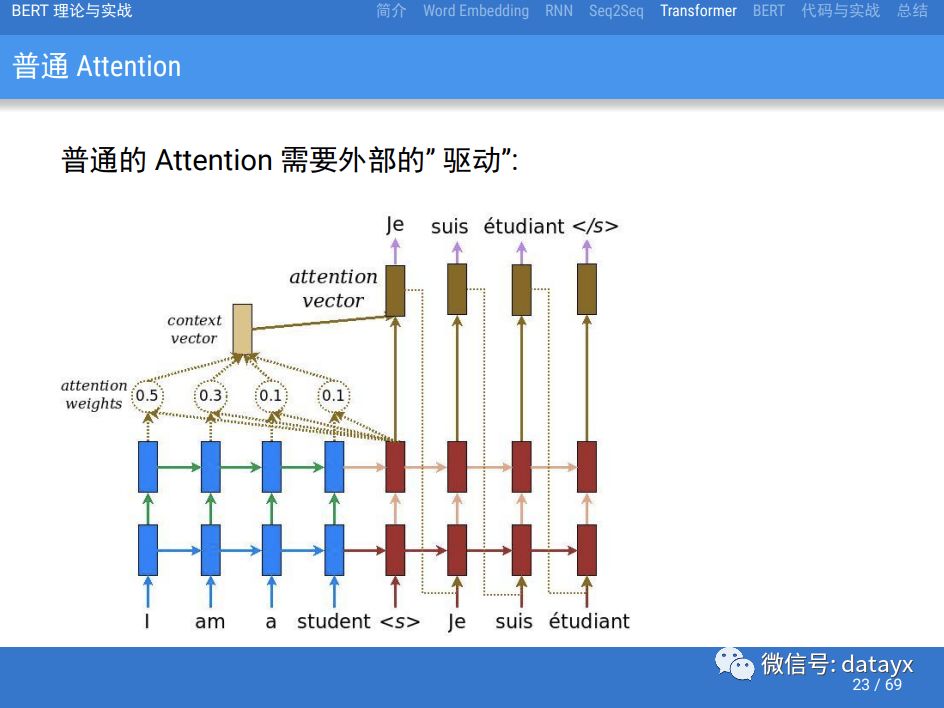

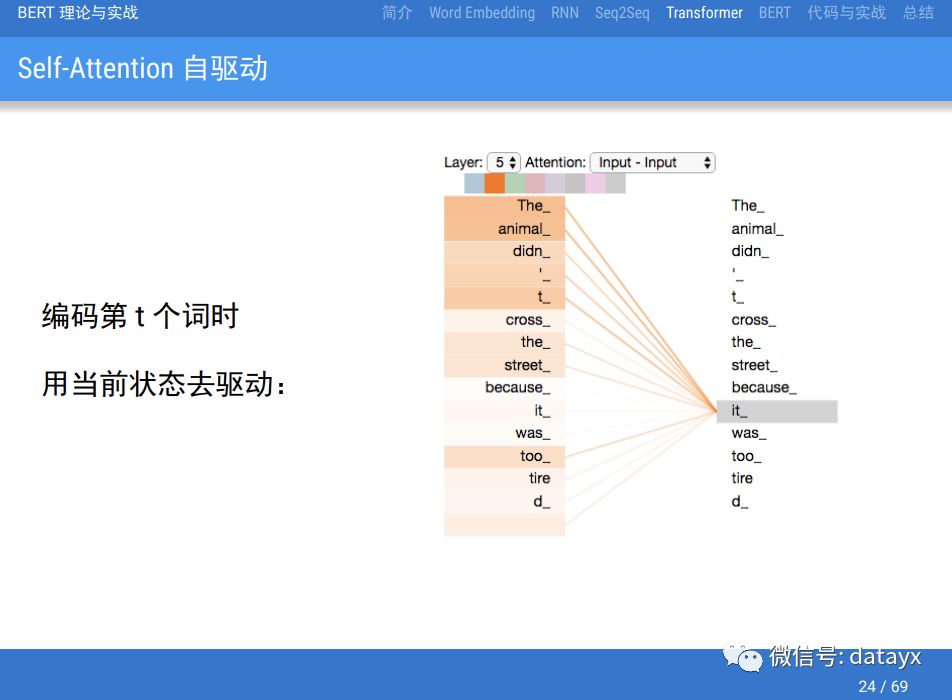

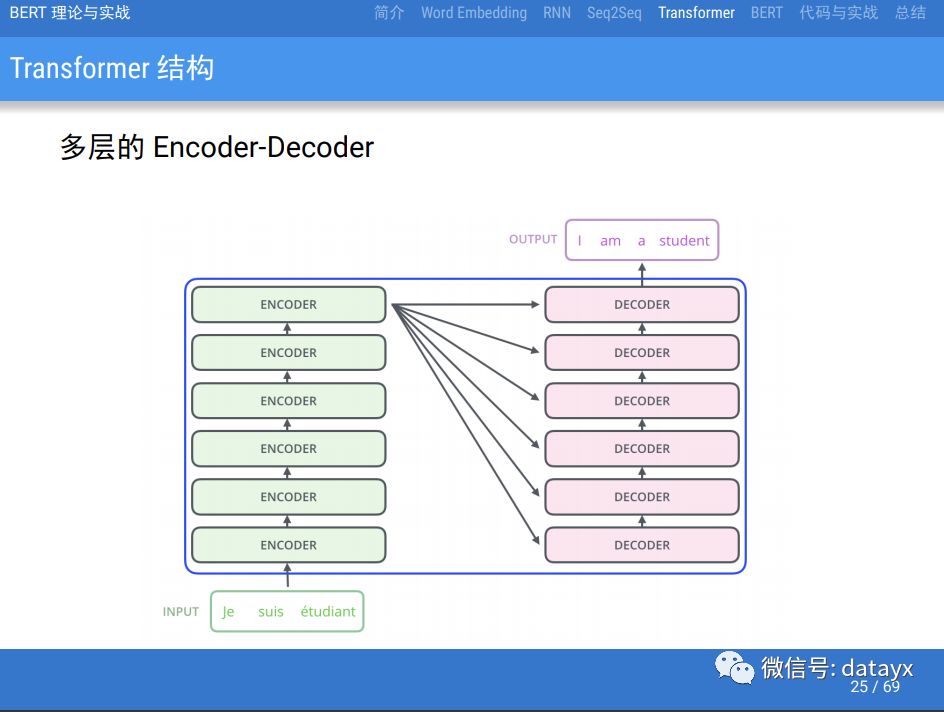

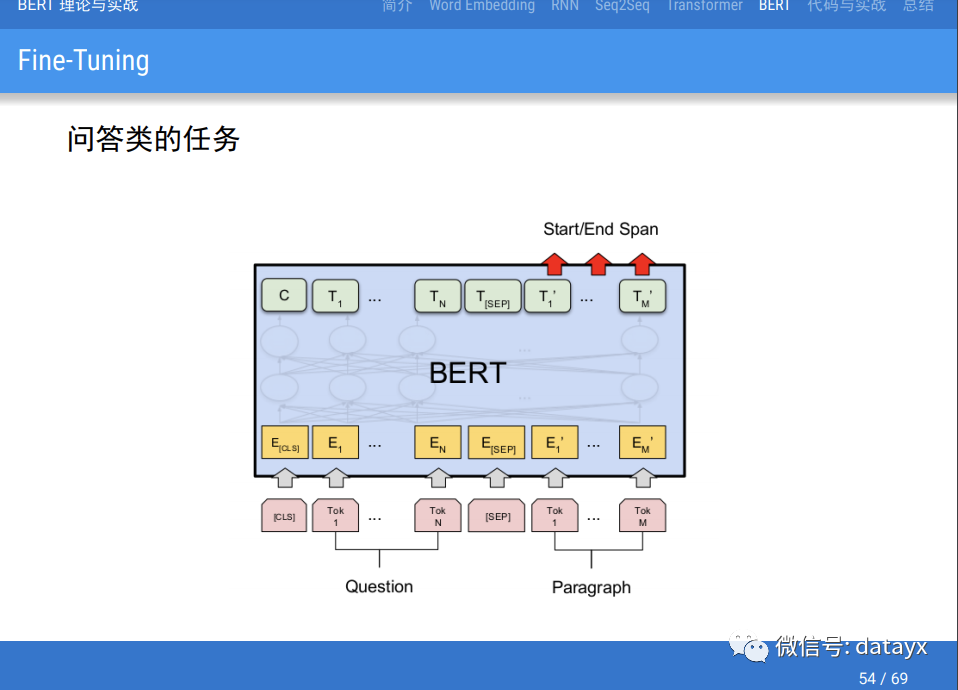

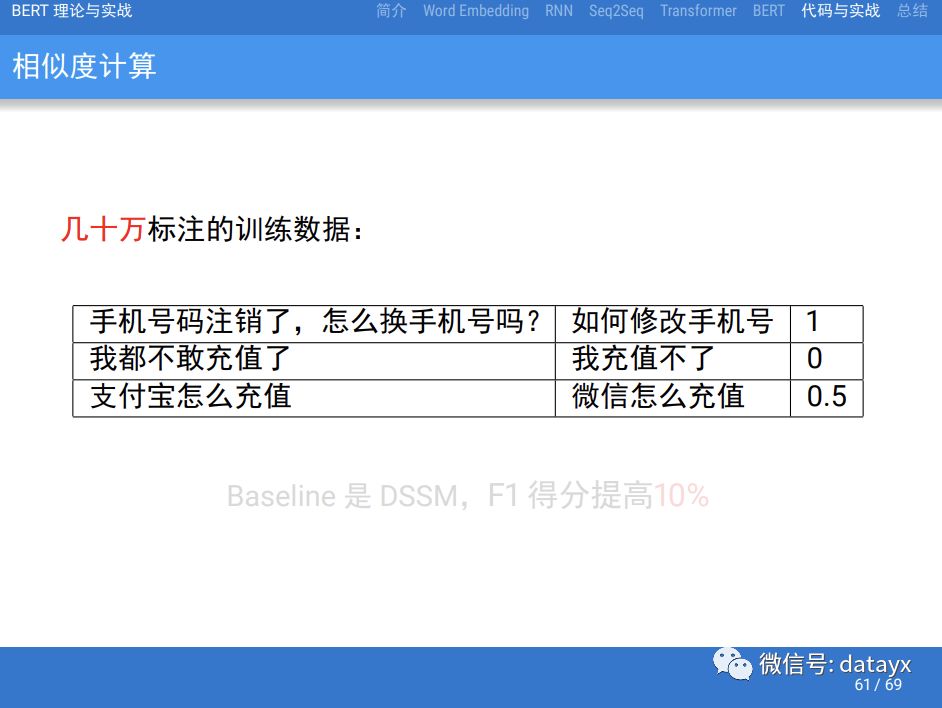

本课程会介绍最近NLP领域取得突破性进展的BERT模型。首先会介绍一些背景知识,包括Word Embedding、RNN/LSTM/GRU、Seq2Seq模型和Attention机制等。然后介绍BERT的基础Transformer模型,这个模型最初用于机器翻译,但是它提出的Self-Attention被用于替换传统的RNN/LSTM/GRU模型。再然后是介绍BERT出现之前的Universal Sentence Embedding模型,包括ELMo和OpenAI GPT。接着介绍BERT模型是什么,它解决了之前模型的哪些问题从而可以达到这么好的效果。代码分析和案例介绍,通过解决实际问题加深理解

学习本课程你将学到:

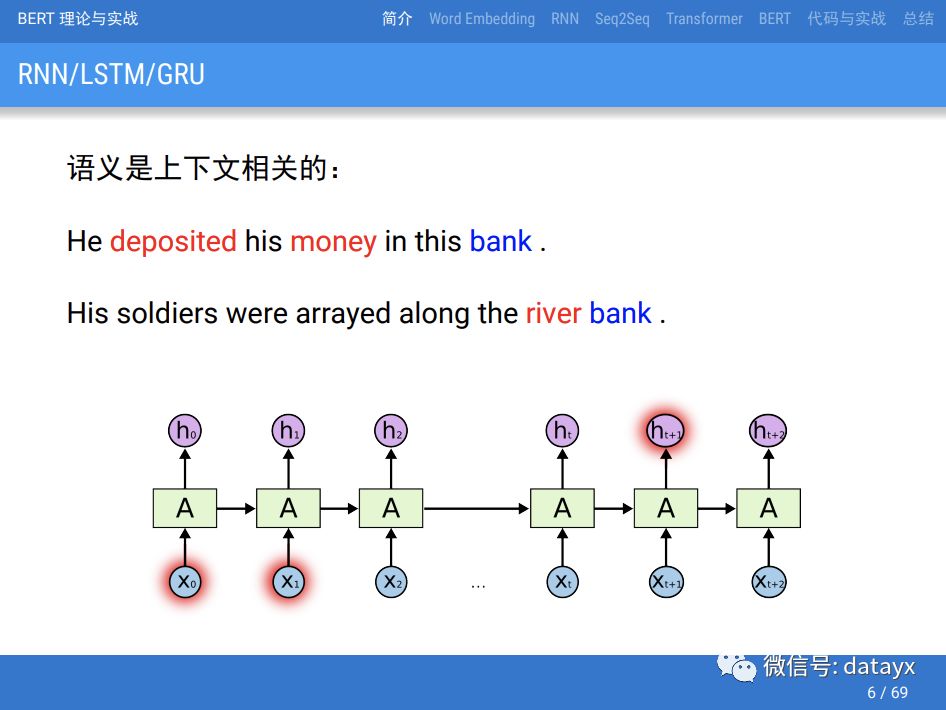

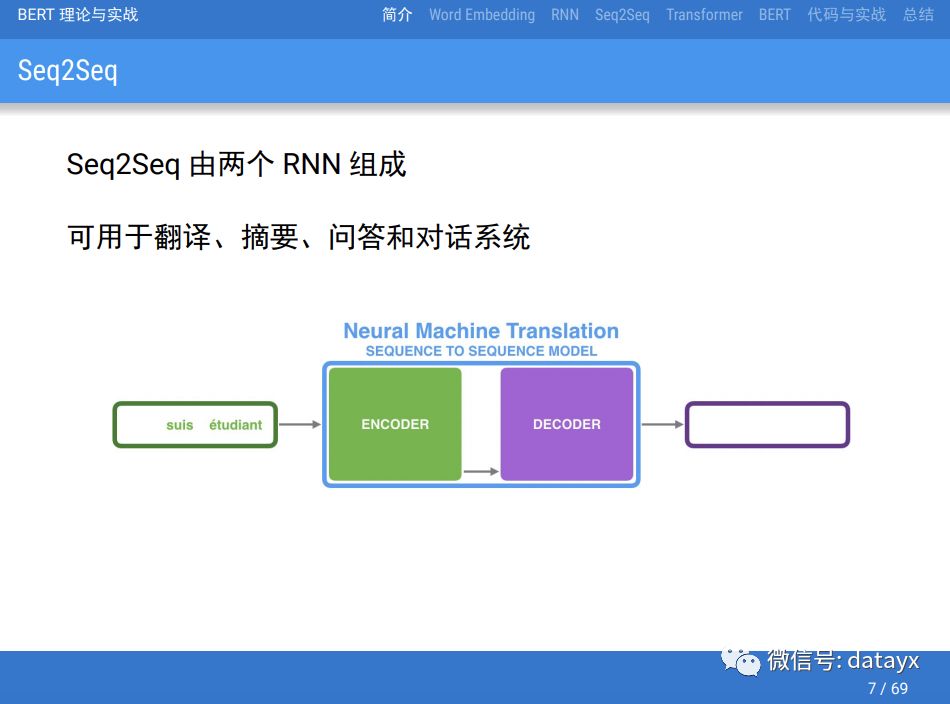

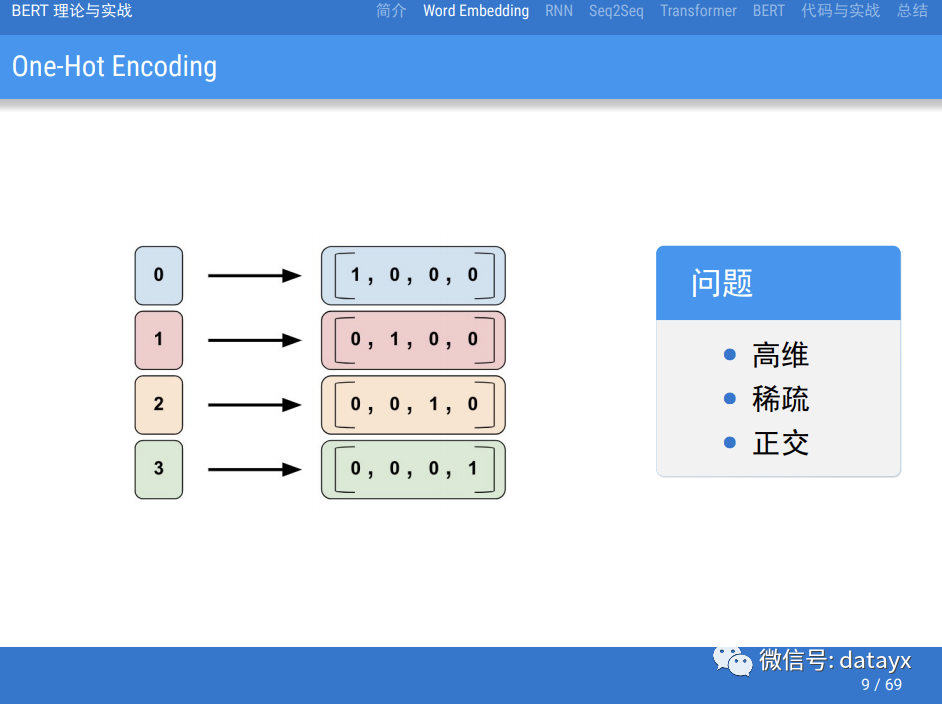

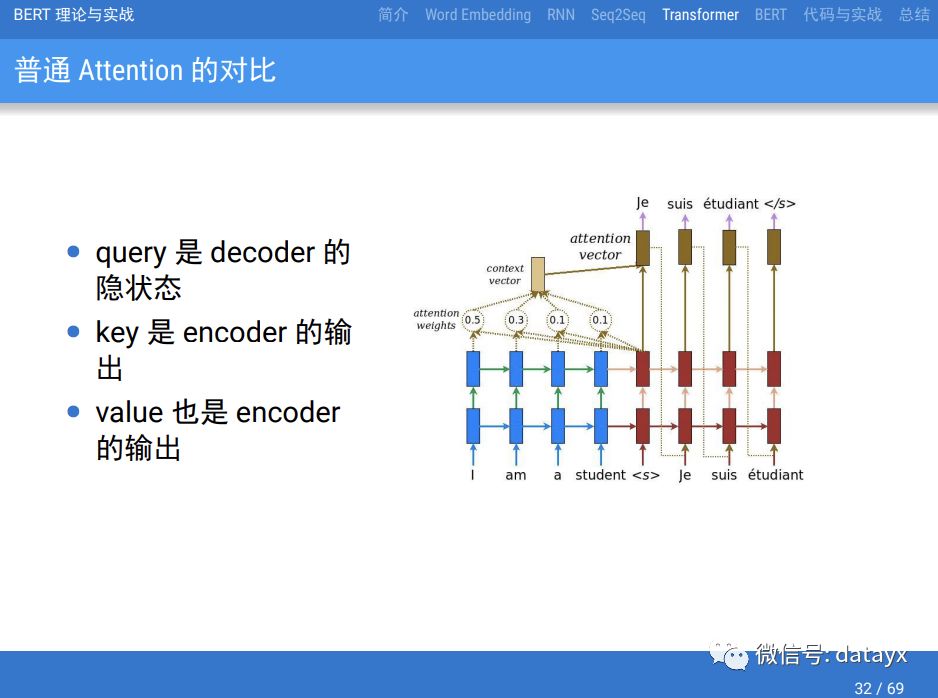

了解一些NLP背景知识,包括Word Embedding、RNN/LSTM/GRU、Seq2Seq模型和Attention机制等。

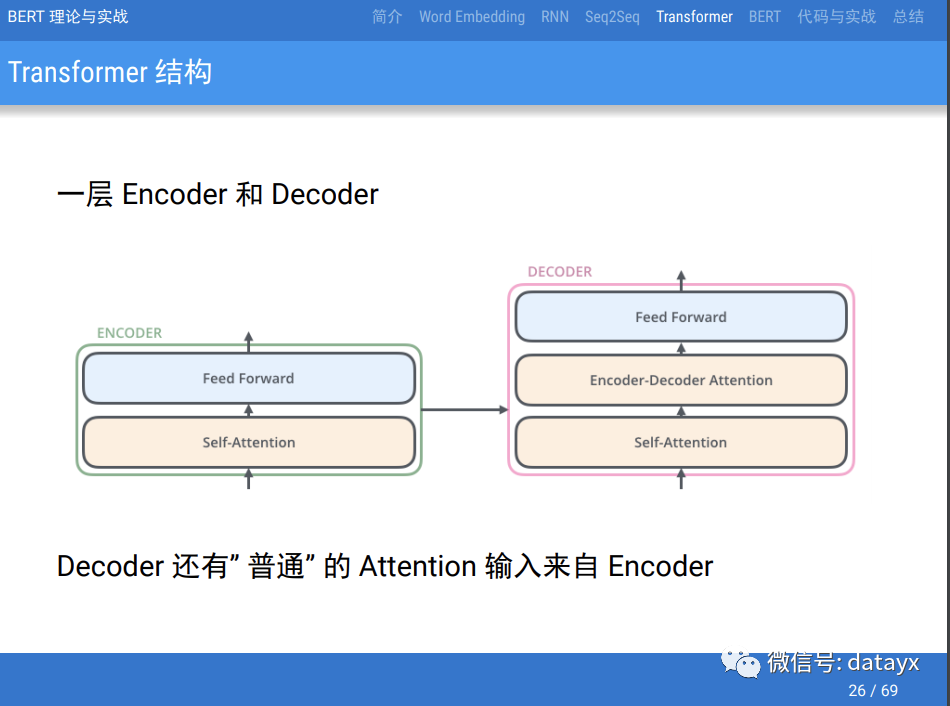

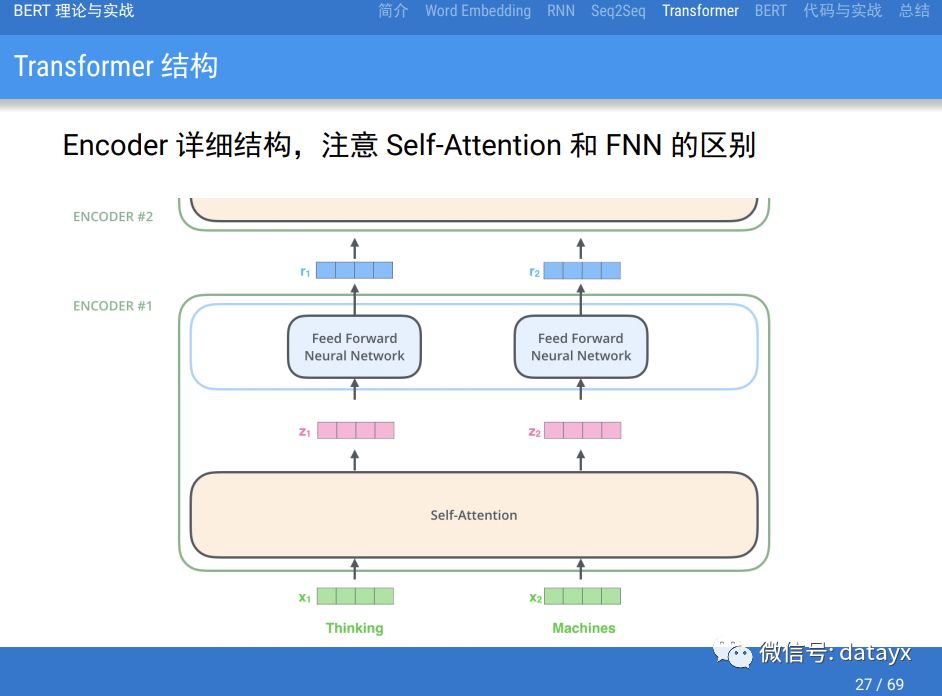

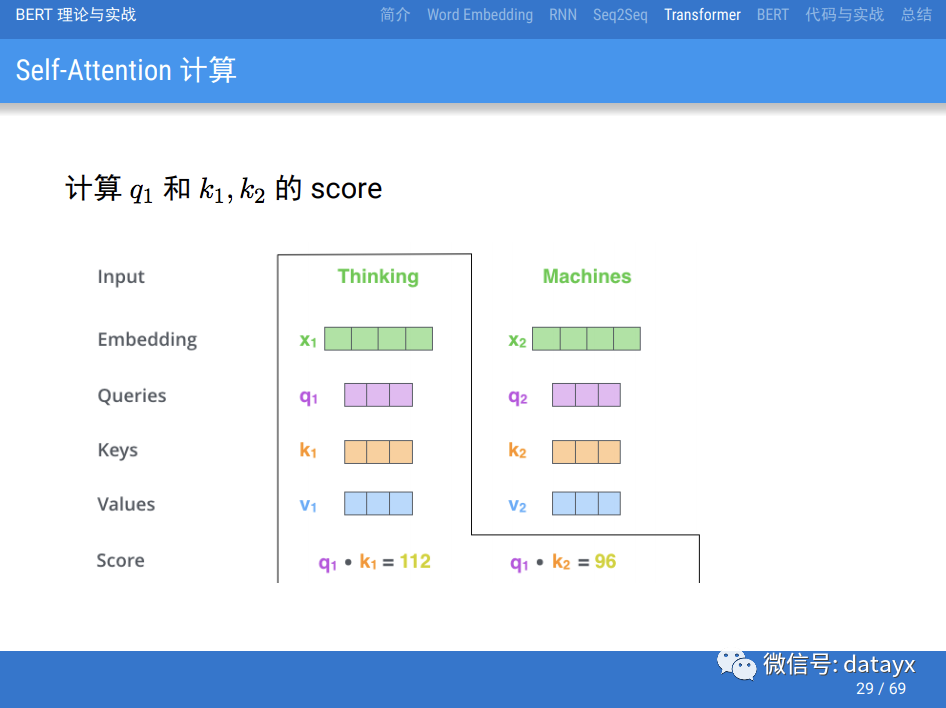

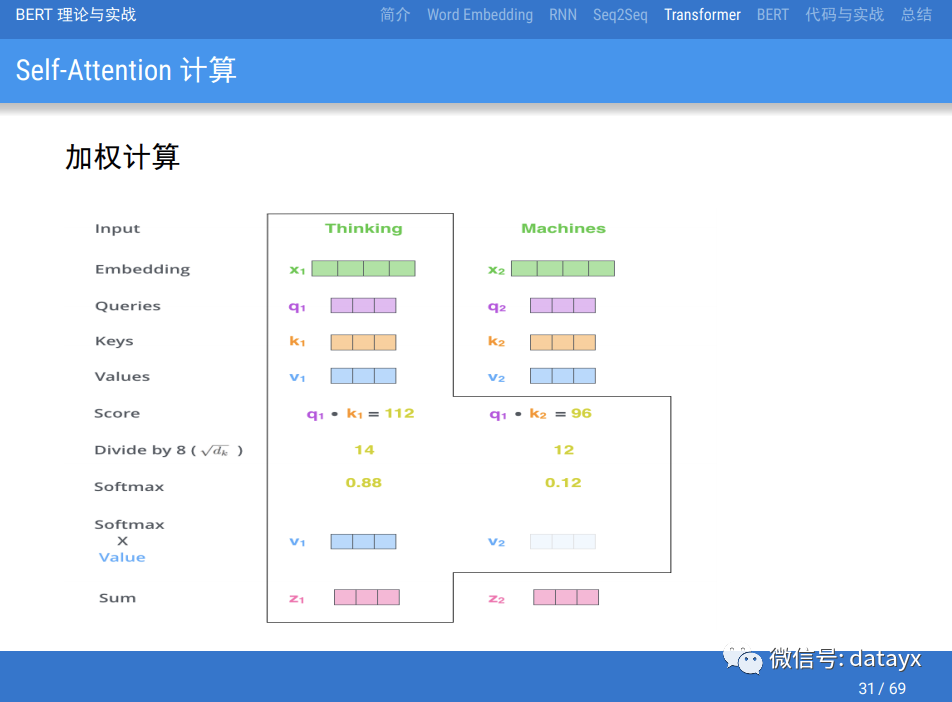

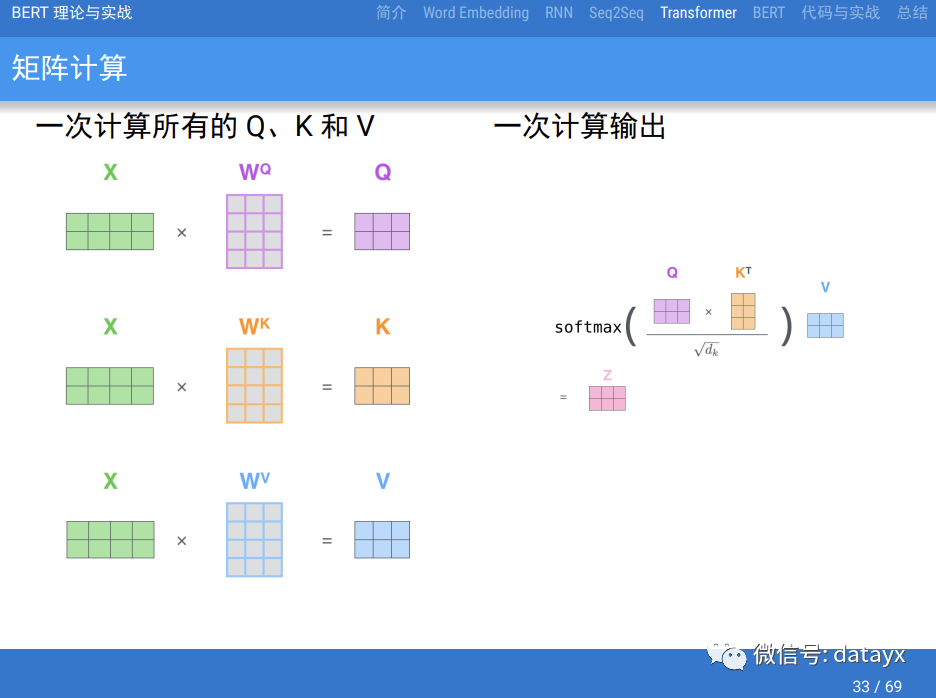

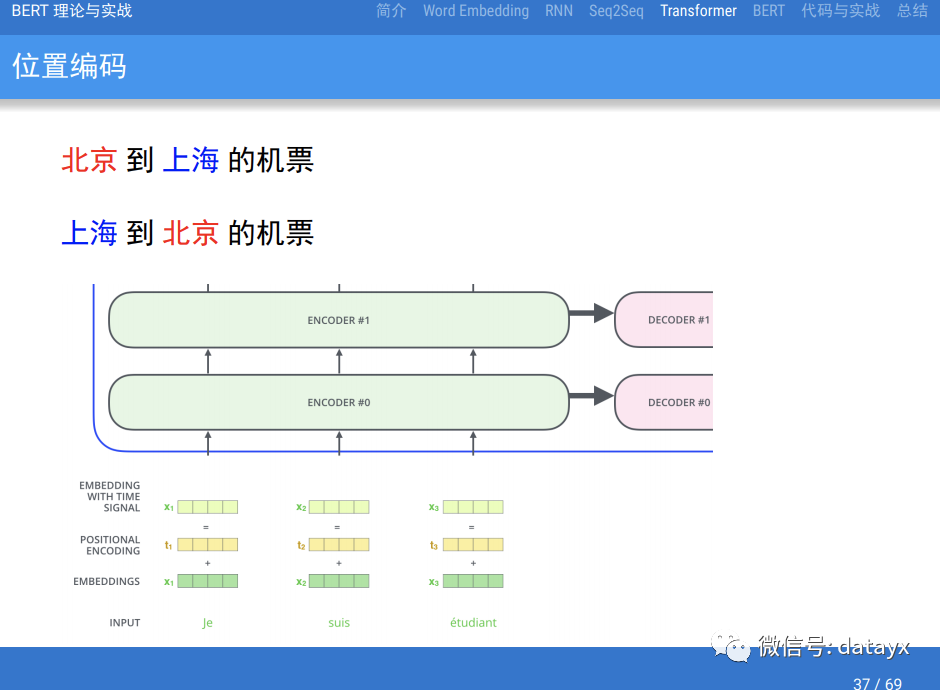

了解BERT的基础Transformer模型 。

视频、PPT地址

关注微信公众号 datayx 然后回复 bert 即可获取。

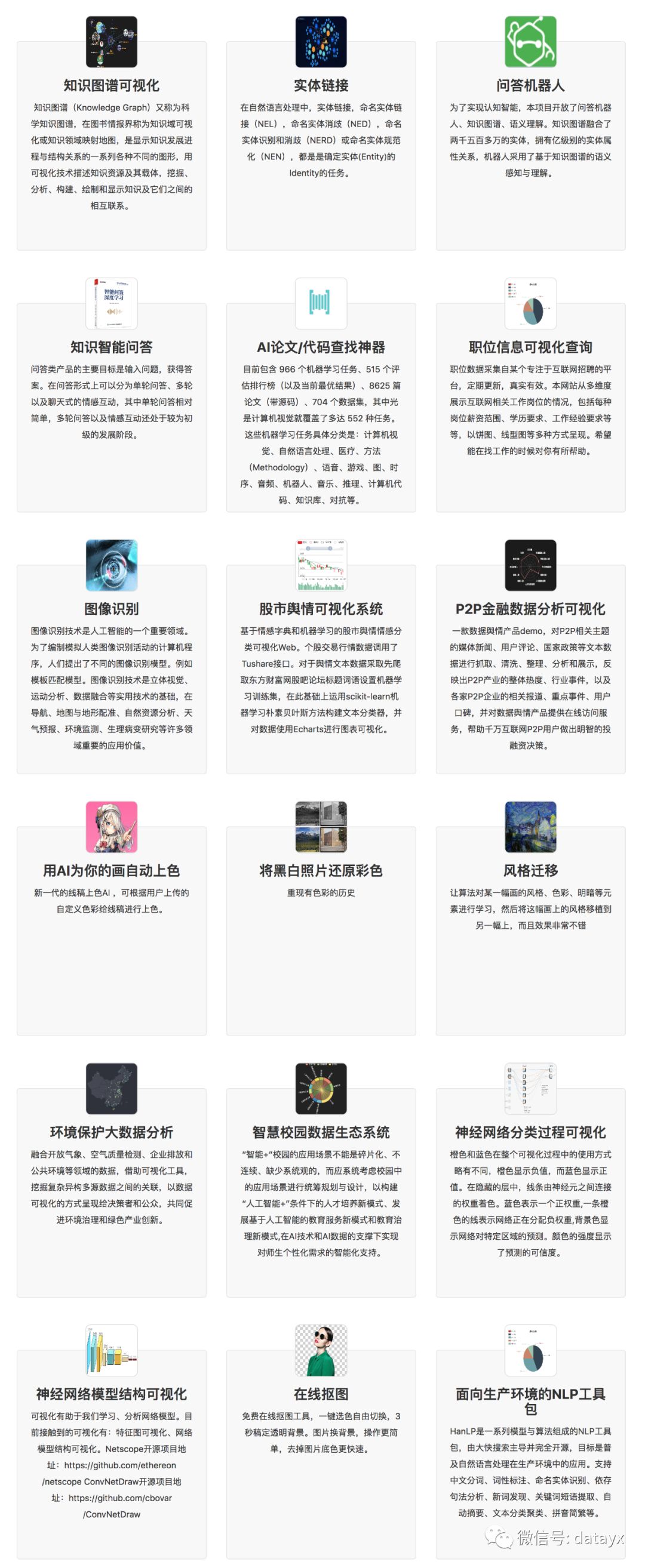

AI项目体验地址 https://loveai.tech

阅读过本文的人还看了以下:

**分享《深度学习入门:基于Python的理论与实现》高清中文版PDF+源代码

**

《21个项目玩转深度学习:基于TensorFlow的实践详解》完整版PDF+附书代码

李沐大神开源《动手学深度学习》,加州伯克利深度学习(2019春)教材

【Keras】完整实现‘交通标志’分类、‘票据’分类两个项目,让你掌握深度学习图像分类

如何利用全新的决策树集成级联结构gcForest做特征工程并打分?

Machine Learning Yearning 中文翻译稿

斯坦福CS230官方指南:CNN、RNN及使用技巧速查(打印收藏)

中科院Kaggle全球文本匹配竞赛华人第1名团队-深度学习与特征工程

不断更新资源

深度学习、机器学习、数据分析、python

搜索公众号添加: datayx

长按图片,识别二维码,点关注

**AI项目体验

**

本文分享自微信公众号 - 机器学习AI算法工程(datayx)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。