好买网 www.goodmai.com IT技术交易平台 使用VGG模型进行猫狗大战 大赛简介 Kaggle 中的猫狗大战竞赛题目。在这个比赛中,有25000张标记好的猫和狗的图片用做训练,有12500张图片用做测试。这个竞赛是2013年开展的,如果你能够达到80%的准确率,在当年是一个 state-of-the-art 的成绩。

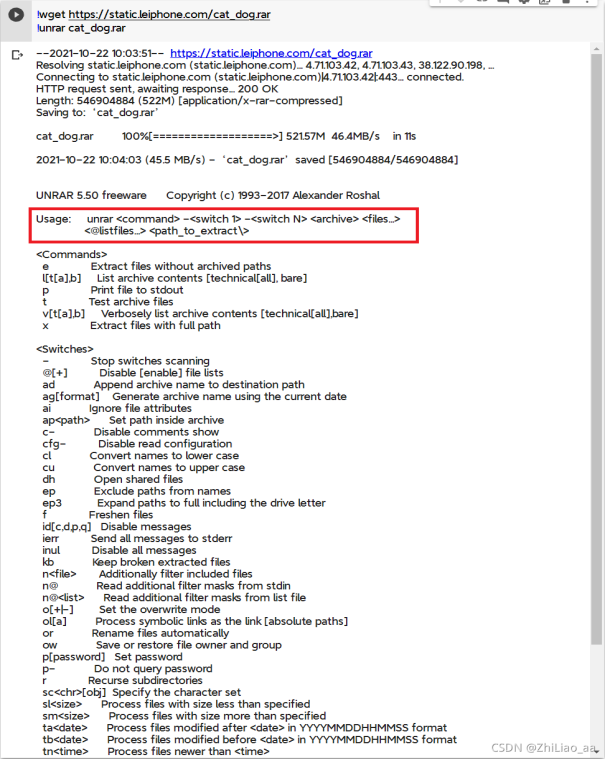

数据准备 在这里其实出了问题,由于研习社的题目给的是rar格式的压缩包,所以没办法和zip一样解压,我开始直接改成

!wget https://static.leiphone.com/cat_dog.rar

!unzip cat_dog.rar显然是不行的,报错结果如下:

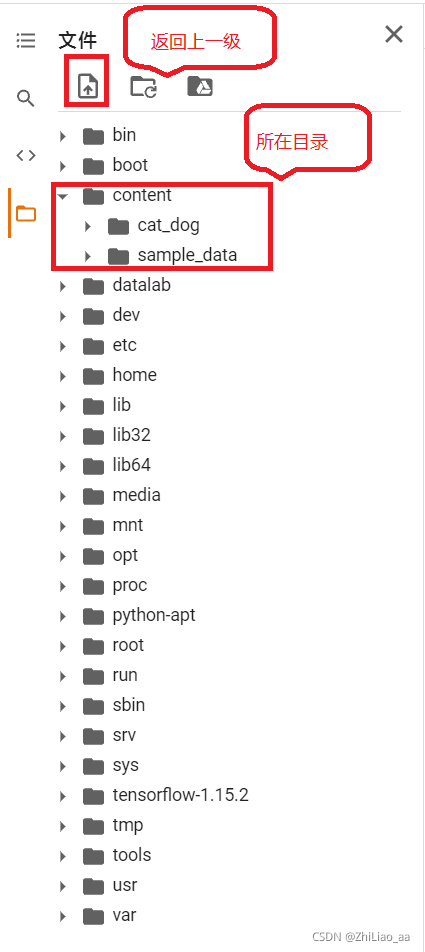

可以看到需要加入< Comands >中的x,然后需要加入目录地址/content/cat_dog.rar,为什么是这个地址,请看下面一张图:

可以看到需要加入< Comands >中的x,然后需要加入目录地址/content/cat_dog.rar,为什么是这个地址,请看下面一张图:

然后就能愉快的下载解压数据了:

然后就能愉快的下载解压数据了:

!wget https://static.leiphone.com/cat_dog.rar

!unrar x /content/cat_dog.rar

!wget http://fenggao-image.stor.sinaapp.com/dogscats.zip

!unzip dogscats.zip1. 解压完成后cat_dog数据集目录: 2. test:最后通过训练好的模型来识别的测试图片。 train:用来训练模型的图片。 val:文件夹下的图片有确定的标签,用来测试模型训练效果。 3. 代码实战

import numpy as np

import matplotlib.pyplot as plt

import os

import torch

import torch.nn as nn

import torchvision

from torchvision import models,transforms,datasets

import time

import json

# 判断是否存在GPU设备

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

print('Using gpu: %s ' % torch.cuda.is_available())数据预处理

normalize = transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

vgg_format = transforms.Compose([

transforms.CenterCrop(224),

transforms.ToTensor(),

normalize,

])

data_dir = '/content/dogscats'

dsets = {x: datasets.ImageFolder(os.path.join(data_dir, x), vgg_format)

for x in ['train', 'valid']}

dset_sizes = {x: len(dsets[x]) for x in ['train', 'valid']}

dset_classes = dsets['train'].classes# 通过下面代码可以查看 dsets 的一些属性

print(dsets['train'].classes)

print(dsets['train'].class_to_idx)

print(dsets['train'].imgs[:5])

print('dset_sizes: ', dset_sizes)

loader_train = torch.utils.data.DataLoader(

dsets['train'], batch_size=64, shuffle=True, num_workers=6)

loader_valid = torch.utils.data.DataLoader(

dsets['valid'], batch_size=5, shuffle=False, num_workers=6)

'''

valid 数据一共有2000张图,每个batch是5张,因此,下面进行遍历一共会输出到 400

同时,把第一个 batch 保存到 inputs_try, labels_try,分别查看

'''

count = 1

for data in loader_valid:

print(count, end='\n')

if count == 1:

inputs_try,labels_try = data

count +=1

print(labels_try)

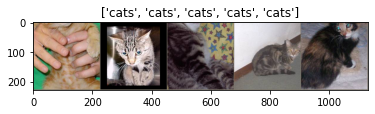

print(inputs_try.shape)打印预览数据

# 显示图片的小程序

def imshow(inp, title=None):

# Imshow for Tensor.

inp = inp.numpy().transpose((1, 2, 0))

mean = np.array([0.485, 0.456, 0.406])

std = np.array([0.229, 0.224, 0.225])

inp = np.clip(std * inp + mean, 0,1)

plt.imshow(inp)

if title is not None:

plt.title(title)

plt.pause(0.001) # pause a bit so that plots are updated

# 显示 labels_try 的5张图片,即valid里第一个batch的5张图片

out = torchvision.utils.make_grid(inputs_try)

imshow(out, title=[dset_classes[x] for x in labels_try]) 构建VGG

我们直接使用预训练好的 VGG 模型。

构建VGG

我们直接使用预训练好的 VGG 模型。

model_vgg = models.vgg16(pretrained=True)

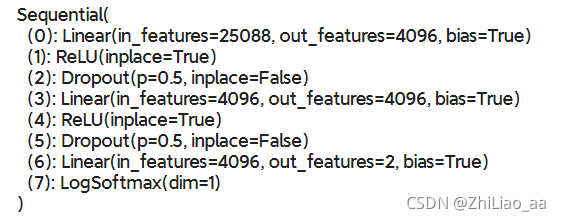

print(model_vgg)我们的目标是使用预训练好的模型,并且只对全连接层的最后一层进行改写nn.Linear(4096, 2)使得最后输出的结果只有两个,即分辨猫与狗。

为了在训练中冻结前面层的参数,需要设置 required_grad=False。这样,前面层的权重就不会自动更新了。训练的时候只会更新最后一层的参数。

model_vgg_new = model_vgg;

for param in model_vgg_new.parameters():

param.requires_grad = False #冻结参数

'''

更改最后一层输出层

'''

model_vgg_new.classifier._modules['6'] = nn.Linear(4096, 2)

model_vgg_new.classifier._modules['7'] = torch.nn.LogSoftmax(dim = 1)

model_vgg_new = model_vgg_new.to(device)

'''

输出新的vgg模型

'''

print(model_vgg_new.classifier) 使用Adam优化器对模型进行优化

使用Adam优化器对模型进行优化

'''

第一步:创建损失函数和优化器

损失函数 NLLLoss() 的 输入 是一个对数概率向量和一个目标标签.

它不会为我们计算对数概率,适合最后一层是log_softmax()的网络.

'''

criterion = nn.NLLLoss()

# 学习率

lr = 0.001# 这里使用Adam优化器

optimizer_vgg = torch.optim.Adam(model_vgg_new.classifier[6].parameters(),lr = lr)

'''

第二步:训练模型并保存

model: 训练的模型

dataloader: 训练集

size: 训练集大小

epochs: 训练次数

optimizer: 优化器

'''

def train_model(model,dataloader,size,epochs=1,optimizer=None):

model.train() #用于模型训练

for epoch in range(epochs):

epoch_acc_max = 0

running_loss = 0.0

running_corrects = 0

count = 0

for inputs,classes in dataloader:

inputs = inputs.to(device)

classes = classes.to(device)

outputs = model(inputs) #参数前向传播

loss = criterion(outputs,classes)

optimizer = optimizer

optimizer.zero_grad() #优化器梯度初始化

loss.backward() #梯度反向传播

optimizer.step()

_,preds = torch.max(outputs.data,1) #得到预测结果

# statistics

running_loss += loss.data.item()

running_corrects += torch.sum(preds == classes.data)

count += len(inputs)

print('Training: No. ', count, ' process ... total: ', size)

epoch_loss = running_loss / size

epoch_acc = running_corrects.data.item() / size

if epoch_acc > epoch_acc_max:

epoch_acc_max = epoch_acc

torch.save(model, 'model_best.pth') #保存最好模型

print('Loss: {:.4f} Acc: {:.4f}'.format(

epoch_loss, epoch_acc))

# 模型训练

train_model(model_vgg_new, loader_train,size = dset_sizes['train'],

epochs = 5, optimizer=optimizer_vgg)测试test

dsets = datasets.ImageFolder('/content/cat_dog', vgg_format)

final = {} #结果数组

loader_test = torch.utils.data.DataLoader(dsets, batch_size=1, shuffle=False, num_workers=0)

model_vgg_new = torch.load("/content/model_best.pth")

def test(model,dataloader,size):

model.eval() #参数固定

cnt = 0 #count

for inputs,_ in dataloader:

if cnt < size:

inputs = inputs.to(device)

outputs = model(inputs)

_,preds = torch.max(outputs.data,1) #预测值最大化

key = dsets.imgs[cnt][0].split("/")[-1].split('.')[0] #对目录项进行分割

final[key] = preds[0]

cnt += 1

else:

break;

test(model_vgg_new,loader_test,size=2000)

''''

写表格

''''

with open("/content/test.csv",'a+') as f:

for key in range(2000):

f.write("{},{}\n".format(key,final[str(key)]))测试结果