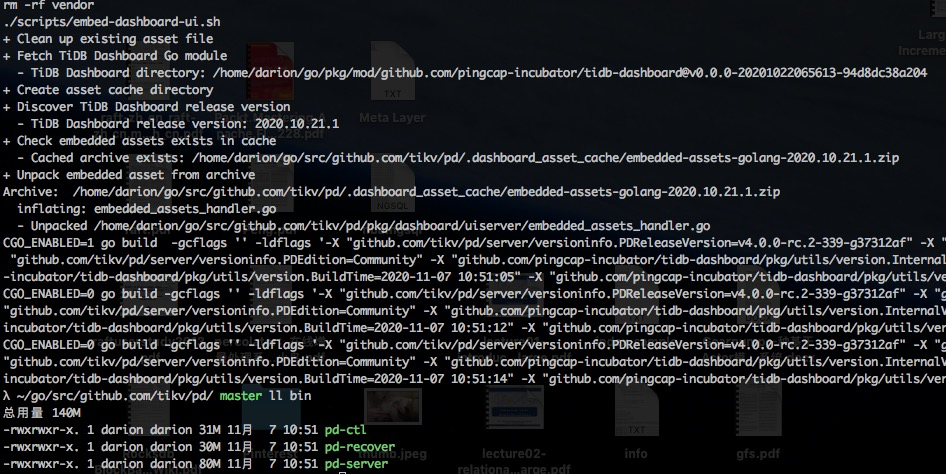

下载 tikv 与pd 源码,tikv v4.0.8版本可以编译,但是pd发布版本源码不可用,需要从master branch编译。使用make 命令进行编译。

TiDB 设计是分层的,如下图所示。

从下向上分析,最底层选用当前比较流行的键值对存储引擎 RocksDB作为本地存储引擎。

之上使用Raft算法保证多个节点之间数据一致性,保证在一台机器失效时还有其他机器的副本可以使用。

多版本并发控制(MVCC)提高分布式场景下数据库性能以及避免死锁。最后构建分布式事务,以上这些功能就构成了存储层 TiKV。

然后由 TiDB 实现 SQL 层,并解析 MySQL 网络协议。

TiDB 为每个表分配一个 TablelD,每个索引分配一个 IndexID,同样每一行也对应一个 RowID,但如果表的主键是整型,则会将主键作为 RowID。

在 TiKV中,每个 Region 包含是一系列连续的 Key,每个 Region 中保存的数据不超过一定的大小,默认为 64MB,当存储的数据超过一个 Region 的域值后,将重新产生新的 Region。因为每个 Region 中的 Key 是有序的,所以每个 Region 都可以用 StartKey 到 EndKey 的左闭右开区间来描述。数据按照 Key 拆分成很多 Region,每个 Region 的数据保存在一个节点上面。

TiDB再由 PD Server 负责将 Region 尽可能地均匀分布在集群中所有节点上,可以通过增加新的节点来实现存储容量的水平扩展,只要增加新节点,PD Server 就会自动地将其他节点上的 Region 调度过来。这种调度策略同时实现了数据的负载均衡,不会出现一个节点数据满负荷,而其他节点是空载的情况。

实现了数据的负载均衡以后,就要考虑容灾。如果每个 Region 只有单独的一份存储在一个节点上,那么,当这个节点宕机时,数据会丢失。

TiKV 以 Region 为单位实现数据复制,每个 Region 的数据在集群中以多个副本的形式存储在多个节点上。在 TiKV 中,每一个副本叫作 Replica,Replica 之间通过 Raft 来保持数据的一致。

每个 Region 中的多个 Replica 构成一个 Raft Group,每个 Raft Group 由一个 Replica 作为 Group 的 Leader,其他的 Replica 作为 Follower。