环境说明

ubuntu16.04

cuda10.0

2080Ti显卡

拉取代码和修改编译脚本

拉取代码

用户先clone代码:

git clone https://github.com/torch/distro.git ~/torch --recursive

通常下载很慢,--recursive参数下载的submodule会失败,需要多执行几次如下命令:

cd torch

git submodule update --init --recursive

安装依赖

1.torch源码中明确指定的依赖 需要sudo权限安装,如果当前账户不是sudo账户也不是root账户则需要联系你的管理员来安装:

bash install-deps;

2.torch源码没说,但实测下来需要的依赖

使用原生的lua5.2而不是luajit,需要apt装一下lua:

sudo apt install lua-5.2

配置cuda/cudnn:系统管理员先前已经安装了cuda-8.0, cuda-9.0, cuda-10.0到/usr/local/cuda-10.0等目录,在~/.bashrc中配置PATH和LD_LIBRARY_PATH即可。

配置CMake,需要高版本cmake,ubuntu16.04用apt装的cmake3.5.1版本太老,FindCUDA.cmake相关有问题。

手动安装了cmake-3.15-rc1

拷贝CMake-3.15-rc1安装路径下的Modules目录到~/torch/cmake/3.15/

拷贝

/torch/cmake/3.6/CMakeLists.txt到/torch/cmake/3.15目录配置使用CUDA10,因为用的是2080Ti,cuda9.0虽然能找到

compute_75算力但是编译失败,需要配置cuda10。编辑~/.bashrc添加:export CUDA_HOME=/usr/local/cuda-10.0 export PATH=/usr/local/cmake-3.15/bin:/usr/local/cuda-10.0/bin:$PATH export LD_LIBRARY_PATH=/usr/local/cuda-10.0/lib64 export TORCH_NVCC_FLAGS="-Xcompiler -D__CUDA_NO_HALF_OPERATORS__"

cudnn也需要一定的配置。torch7默认用cudnn5,cuda10搭配的cudnn7.5。

git clone https://github.com/soumith/cudnn.torch.git -b R7 && cd cudnn.torch && luarocks make cudnn-scm-1.rockspec

(from: https://github.com/soumith/cudnn.torch/issues/383)

然后~/.bashrc配置:

export CUDNN_PATH="/usr/local/cuda-10.0/lib64/libcudnn.so.7"

3.torch源码修改 几个坑:

- torch官方很久不更新了,ATen等C++重新实现的核心代码在PyTorch官方repo中,https://github.com/torch/torch7 则几乎不维护

- torch7不支持cuda10.0,需要自行修改cmake脚本

- torch7判断cuda>=7.0.5就使用FP16,然而我这里用的gcc-5.4发现FP16(half精度)相关的代码报错,需要手动注释掉,修改包括cmake脚本和.cuh、.c代码

具体包括:

因为torch默认不支持cuda10.0,需要修改extra/cutorch/lib/THC/cmake/select_compute_arch.cmake:

找到

list(APPEND CUDA_COMMON_GPU_ARCHITECTURES "6.0" "6.1" "6.1+PTX"

改为

list(APPEND CUDA_COMMON_GPU_ARCHITECTURES "6.0" "6.1" "6.1+PTX" "7.5")

找到

if(nvcc_res EQUAL 0)

# only keep the last line of nvcc_out

STRING(REGEX REPLACE ";" "\\\\;" nvcc_out "${nvcc_out}")

STRING(REGEX REPLACE "\n" ";" nvcc_out "${nvcc_out}")

list(GET nvcc_out -1 nvcc_out)

string(REPLACE "2.1" "2.1(2.0)" nvcc_out "${nvcc_out}")

set(CUDA_GPU_DETECT_OUTPUT ${nvcc_out} CACHE INTERNAL "Returned GPU architetures from detect_gpus tool" FORCE)

endif()

修改为:

#if(nvcc_res EQUAL 0)

# # only keep the last line of nvcc_out

# STRING(REGEX REPLACE ";" "\\\\;" nvcc_out "${nvcc_out}")

# STRING(REGEX REPLACE "\n" ";" nvcc_out "${nvcc_out}")

# list(GET nvcc_out -1 nvcc_out)

# string(REPLACE "2.1" "2.1(2.0)" nvcc_out "${nvcc_out}")

# set(CUDA_GPU_DETECT_OUTPUT ${nvcc_out} CACHE INTERNAL "Returned GPU architetures from detect_gpus tool" FORCE)

#endif()

set(__nvcc_out "7.5")

修改torch/install.sh,把里面所有3.6改成3.15。

去掉FP16功能相关的宏,因为编译会失败。方法:

ag 'CUDA_HAS_FP16'

找到

extra/cutorch/lib/THC/CMakeLists.txt

extra/cutorch/CMakeLists.txt

这两个文件,里面FLAGS去掉CUDA_HAS_FP16相关功能。

extra/cutorch/lib/THC/THCHalf.h,去掉#define CUDA_HAS_FP16 1

extra/cutorch/lib/THC/THCTensorMode.cuh,找到带

extra/cutorch/lib/THC/THCGeneral.c,文件最后面两个函数half2float和float2half,用#ifdef CUDA_HAS_FP16 #endif包裹

error: cannot overload functions distinguished by return type alone 需要添加nvcc的flags,vim ~/torch/extra/cutorch/lib/THC/CMakeLists.txt +65,添加:

-Xcompiler -D__CORRECT_ISO_CPP11_MATH_H_PROTO

error: more than one operator "==" matches these operands 原因是cuda和torch的头文件都提供了相同的重载运算符,编译器不知道用哪一个。输入下面shell命令禁止使用cuda的头文件编译torch即可: export TORCH_NVCC_FLAGS="-D__CUDA_NO_HALF_OPERATORS__" 然后重新执行torch的编译安装 (from: https://blog.csdn.net/u013066730/article/details/80936627)

编译

TORCH_LUA_VERSION=LUA52 ./install.sh 2>&1 |

编译失败,清理办法

./clean.sh

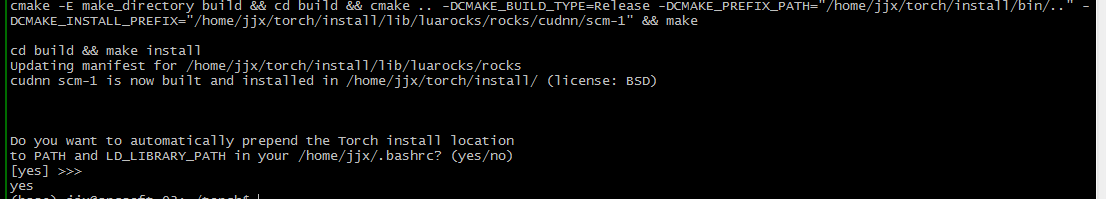

编译成功,截图: