前言

论文链接:Perceptual Losses for Real-Time Style Transfer and Super-Resolution

论文的补充资料:Supplementary Material

以下Github链接是各种深度学习框架的实现:

2, Tensorflow fast-nueral-style

5, 还有我基于Mxnet实现的一个版本: Mxnet fast-nueral-style

正文

框架介绍

论文的提出一个网络框架来解决图像变换的问题,然后论文在两个任务上做了实验,图像的风格化

和超分辨。本文只介绍风格化的思路,其实很直接就是训练一个图像变换网络,使之能够学会把输入

的图像转换为某一个风格的图像,之所以快就是因为只要 forward 一遍就能得到想要的风格化图片。

文章的框架:

整个框架其实分为两部分,前面的图像变换网络(Image Transform Network)就是我们要训练的,

后面和Neural Style 文章的方法差别不大,就是loss的定义不同,用训练好的VGG网络来提取风格图片

和内容图片的高级特征,然后计算梯度,更新前面图像变换网络的权值,LOSS 网络的权值保持不变。

训练好了以后,后面的那部分就可以不用了。其实后面的部分可以更换不同的网络,比如ResNet。

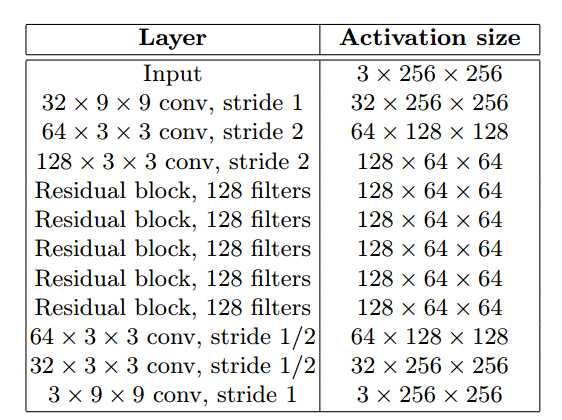

Image Transform 网络的配置在论文的补充材料中有详细的介绍:

简单来说就是,前面三层卷积,对图片作了两次下采样,然后接5个相同的残差模块,

然后接两层反卷积层,恢复到输入图片的大小,最后再接一层卷积层大小保持不变,就得到了

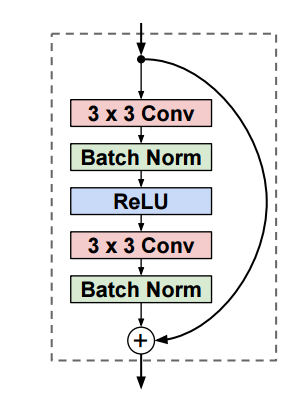

图像变换网络的输出。残差模块的定义:

和之前的參差模块的最主要的区别是最后的Relu激活给去掉了。然后transform网络最后的卷积输出

的激活函数采用tanh。网络的定义的细节或者看代码更直接易

训练过程:

loss的计算,从图中可以看到,对于风格图的loss采用VGG的,relu1_2、relu2_2、relu3_3和relu4_3

的输出,内容的loss采用relu3_3的输出。然后就是比如现在要训练某种风格,风格图片(Style Target)

固定,而内容图片在换,每次迭代,Input Image 和 Content Traget是同一张图片,首先图像变换网络

forward一遍得到 变换之后的图片,图中的  ,然后后面的部分就是三个图片 ys, yc,

,然后后面的部分就是三个图片 ys, yc,  分别过网络,

分别过网络,

然后把所有的loss加起来得到最后的loss。具体的loss定义和实现细节可以看论文,还可以结合代码来

理解,上面提供了各种实现的链接。

复现结果展示

接下来看看用Mxnet复现的结果。速度还可以,在GTX 1070 GPU上分辨率 1500 x 1000 的图片

也就0.3s 左右。效果也不错。