网络作为社会信息化的基础,已成为人们日常生活不可或缺的一部分。网络通过模拟信号将信息转为电流进行传播,在这个过程中,网卡便充当了解码器的作用,能够将电信号转换为计算机能够识别的数字信号。

网卡,即网络接口卡,也称为网络适配器,是连接计算机与网络的硬件设备,也是局域网最基本的组成部分之一。网卡作为通信的桥梁,主要有以下两个功能:

▍读入网络设备传输过来的数据包,经过拆包,将其变成计算机可识别的数据,并将数据传输到所需设备中;

▍将计算机发送的数据,打包后输送到其他网络设备中。

一个网卡有一个或多个网口,每个网口的带宽是固定的。在实际组网中,部署人员会充分考虑链路备份、负载分担等功能,以便某一个网口出现问题时,链路可以正常工作。在实际操作中,为了圆满解决上述问题,业内会使用到bond接口,也就是聚合接口。那么什么是bond口呢?

bond口就是把多个物理网络接口绑定到一起,使它们像一个网络接口,形成一个逻辑接口。而bond接口的逻辑层分为master接口和slave接口,其中master接口即bond口,slave口即加入bond的物理网络接口。正因如此,bond接口拥有“提升接口带宽、实现链路备份、实现负载分担”等优势。

由于历史原因,资源池中还存在大量bond6机器,天翼云基础架构事业部内核团队对此进行了大量优化工作。 什么是bond mode6?

bond mode6指balance-alb (适应性负载均衡),其特点是成员口对外呈现的是独立接口,在交换机侧不需要进行特殊处理。

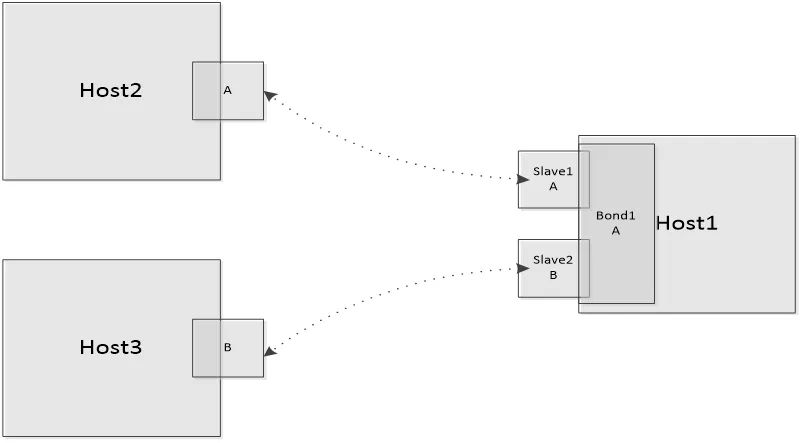

如下图所示,在Host1上有一个bond接口,其中slave1、slave2为其成员口,其mac地址分别为A和B,左侧为其他两台机器,Host2、Host3,中间的虚线表示中间链路。对于bond6来说,在Host2上保存的针对于bond1ip地址的mac地址为A,在Host3上保存的针对于bond1 ip地址的mac地址为B。

bond6负载分担机制

bond6的主要功能点可以分为发送和接收两个部分,tlb是发送方向负载分担,rlb是接收方向负载分担。

tlb机制的实现是基于发送方向的负载分担,也就是针对不同的报文,如何选择发送接口的问题。对于一条数据流的初始选择是由成员口的负载决定的,一般选择负载较小的成员口作为发送口,并与目的ip的hash值绑定。在正常使用时,直接根据ip地址的hash值进行取值,获取成员口。同时,该绑定关系在一定周期内会进行刷新,默认10s进行对应关系的清除,并重新进行选择绑定。tlb不区分IPv4和IPv6,都是基于以上方式实现。

对于rlb,也就是接受方向的负载分担,是根据报文发送的原理,基于邻居表项的实现机制,利用arp来实现。也就是说,在进行arp交互时,当arp reply报文走到slave接口时,会将当前slave接口的mac地址填充到arp报文中,作为源mac发送到对端,以此达到控制对端邻居表项的目的。

当前机制存在的问题及天翼云的改进

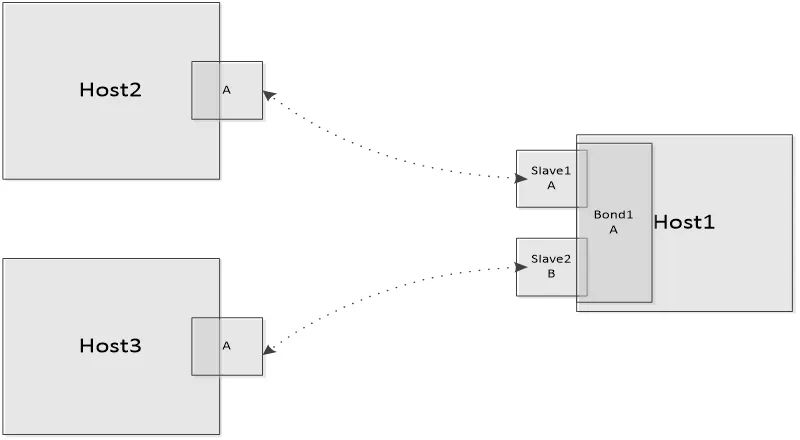

当前的rlb只针对IPv4有效,但随着IPv6的应用,rlb同样也需要支持IPv6。当前的效果如下图所示,在Host2和Host3上面,针对bond1的IPv6地址,保存的mac地址都为slave1的mac A,所以针对IPv6接收方向的带宽只是其中一个成员口的带宽,浪费了带宽资源。

为实现IPv6rlb,天翼云对当前机制进行了创新,在ns、na报文进行交互时,会根据成员口接口带宽进行接收接口的选择,对于同样带宽的成员口会进行轮询。接口选择完成后,与目的ip的hash值进行绑定,并将目的mac、目的ip、成员口信息保存到client_info中,同时也将成员口的mac地址填充到lladdr。与IPv4相似,IPv6rlb也需要有刷新机制,使用na报文时,根据相应的client_info信息,在对应成员口上面发送na报文,从而使对端client更新邻居信息。IPv6的刷新时机如下所示:接收到na报文时、成员口状态变化时、成员口加入、退出,以及mac地址变化时都需要进行刷新。

IPv6rlb最终实现的结果与当前IPv4的结果类似,在不同的client上面,针对于bond1的IPv6地址,保存不同的mac地址,这样在不同的client发送流量到bond1时,会走不同的成员口。该功能实现后,针对IPv6流量,可以增加接收方向的带宽。

天翼云对于IPv6增加接收方向的接口带宽,比如对于两个10G成员口的bond接口,进行优化后效果显著。对于IPv6报文,接收方向的带宽为10G,优化后则能够达到20G。而在此机制创新之前,如果想要达到IPv6接收方向20G的带宽,需要使用两个20G的网口作为bond的slave接口,无疑增加了成本。得益于天翼云的机制创新,企业能够实现对网卡、网络以及算力资源的高效利用,在进一步优化网络性能的同时,节省带宽资源,实现降本增效,制胜IPv6时代。