OpenTSDB

OpenTSDB是基于Hbase的时序数据库,它是一个时间序列专用数据库,只能存储时序数据。官方定位是一个分布式、可伸缩的监控系统。譬如收集大规模集群(包括网络设备、操作系统、应用程序)的监控数据并进行存储,查询。

功能

- 提供对时序数据的实时聚合,所有数据都以原始格式存放在Hbase中,查询时实时计算,截至到目前最新的Release版本2.3.1不支持预聚合。

- 灵活地支持各种聚合粒度,比如按秒、1min、10min等粒度进行聚合。

- 支持绝大数常的聚合方式,如求和、最大值、最小值、均值、分位数等常见聚合方式,但是不支持自定义聚合方式,也无法扩展。聚合方式参考。

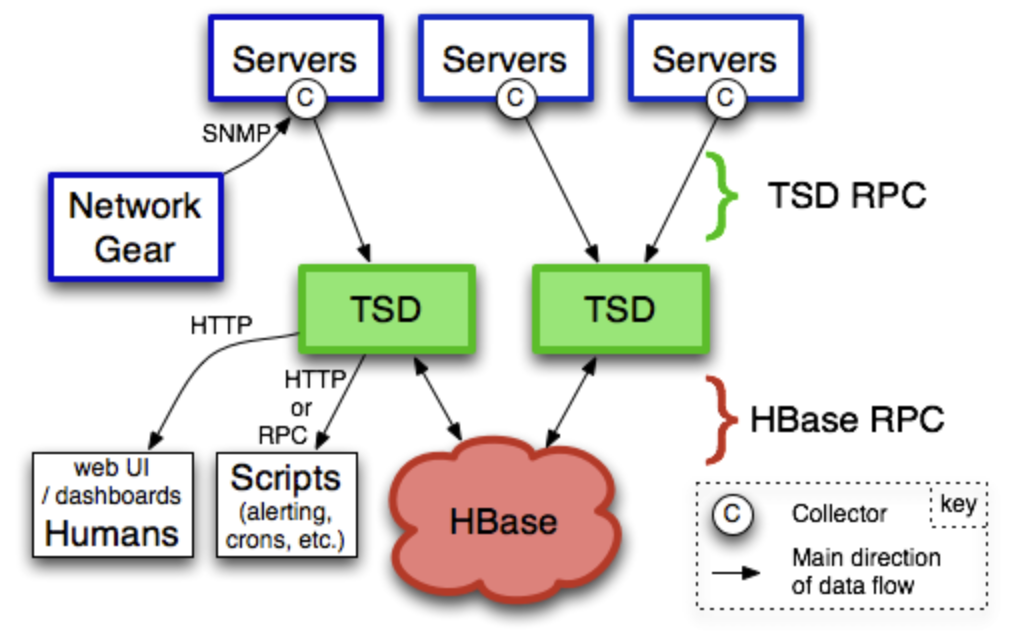

整体架构

OpenTSD由一系列Time Series Daemon (TSD)节点组成,可以包含一个或多少TSD。 每个TSD都是一个独立无状态的节点,没有master,没有分片等。节点间彼此之间不会进行任何通信,也不知道彼此的存在。

TSD节点并不具备数据存储的能力,而是把数据存储放在Hbase中。它只负责数据的写入和查询等,存储在Hbase中数据是经过高度优化、精细设计的。

存储优化

Data Point

OpenTSDB存储每一条数据称为一个数据点(Data Point),每个数据点由metric、timestamp、value、tag组成,每一部分都必不可少。

- metric: 指标,比如在系统监控中cpu mem的利用率、系统Load、IO等都是指标。

- timestamp: 时间戳,支持秒、毫秒级精度。

- tag: 标签,表示在哪个维度。 比如在cpu在某个机器上的数据,就可以把机器ip作为tag打进去。在OpenTSDB里tag是个k-v,比如 ip=192.168.0.1 就可以做为一个tag。注意OpenTSDB最多只能打8个tag,可配置。

- value: 时序数据的值。

Hbase Row Key

OpenTSDB精心设计Hbase的Row Key,其格式如下:

<metric_uid><timestamp>[<tagk1_uid><tagv1_uid>…<tagkN_uid><tagvN_uid>]

OpenTSDB在Hbase表tsdb-uid表中分别维护metric、tagk、tagv到UID的双向映射关系。在生成rowkey时为了节约rowkey的空间,减少查询时rowkey的匹配时间,使用UID代替原始的值。默认情况下,metric、tagk、tagv均使用3 bytes(2^24=16777216个,大多数情况下够用)来生成UID,每出现一个新的值,都会UID都会自增。当UID被用尽之后,数据就无法写入而报错。

压缩

OpenTSDB总是会根据rowkey进行scan,并且对具有相同的rowkey的KeyValue进行合并一个rowkey存储。由于TSD节点是独立无状态的,多个TSD同时工作时,只需要一个TSD节点开启压缩功能,其它需要关闭,避免对Hbase多余的scan。 参考https://m.aliyun.com/yunqi/articles/54785

缺点

- 不适合灵活的多维度分析,由于OpenTSDB底层使用Hbase依赖于rowkey设计,灵活性比较差。

- 目前不支持rollup预聚合,单点聚合在数据量级达到千万级时,响应比较慢。

- 不支持分布式聚合,聚合性能受限于单点计算能力。

- tags的个数受限,太多会影响rowkey的性能。

- metric、tagk、tagv只支持部分常见字符:

a-z A-Z 0-9 - _ . /,不能包含任意字符,也不存在转义之说,否则就会报错。