正文字数:1708 阅读时长:2分钟

仅仅通过在照片上训练模型,机器学习(ML)的最新技术就已经在许多计算机视觉任务中取得了卓越的准确性。在这些成功的基础上,进一步提高对3D对象的理解,这将极大地促进更广泛的应用,例如增强现实,机器人技术,自主性和图像检索。

作者 / Adel Ahmadyan Liangkai Zhang

原文链接 / http://ai.googleblog.com/2020/11/announcing-objectron-dataset.html

今年早些时候,我们发布了MediaPipe Objectron,这是一套针对移动设备设计的实时3D对象检测模型,这些模型在经过完全注释(annotated)的真实3D数据集上进行了训练,可以预测对象的3D边界框。

然而,由于与2D任务(例如ImageNet,COCO和Open Images)相比,因为缺少大型真实数据集,所以了解3D对象仍然是一项具有挑战性的任务。为了使研究社区能够不断提高三维实体的理解,迫切需要发布以对象为中心的视频数据集,该数据集可以捕获对象的更多3D结构,同时匹配用于许多视觉任务的数据格式(例如视频或摄像机流),以帮助训练和确定机器学习模型的基准。

今天,我们很高兴发布Objectron数据集,这是一个短的,以对象为中心的视频剪辑的集合,可以从不同的角度捕获更大的一组公共对象。每个视频剪辑都随附有AR会话元数据,其中包括相机姿势和稀疏点云。除此之外,数据还包含每个对象手工标注的3D边框,用来描述对象的位置,方向和尺寸。数据集包括15K带注释的视频剪辑,并补充了从不同地理区域的样本中收集的超过4M带注释的图像(覆盖五大洲的10个国家/地区)。

Objectron数据集中的示例视频

三维实体检测解决方案

除了和数据集一起之外,我们还将共享一个针对四类对象的三维实体检测解决方案-鞋子,椅子,杯子和照相机。这些模型在MediaPipe中发布,MediaPipe是Google的跨平台可定制ML解决方案的开源框架,适用于实时和流媒体,该解决方案还支持设备上的实时手部,虹膜和身体姿势跟踪等ML解决方案。

在移动设备上运行的3D对象检测解决方案的示例结果

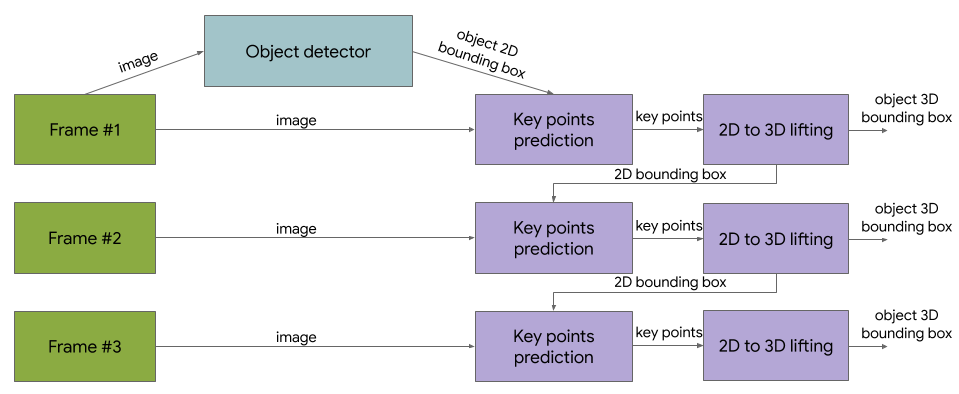

与以前发布的单阶段Objectron模型相反,这些最新版本使用两级架构。第一阶段采用TensorFlow对象检测模型来查找实体的2D裁剪。然后,第二阶段使用图像裁剪来估计3D边框,同时为下一帧计算实体的2D裁剪,因此实体检测器不需要运行每个帧。第二阶段3D边框预测器在Adreno 650移动GPU上以83 FPS运行。

参考3D对象检测解决方案图

3D对象检测的评估指标

借助ground truth annotations,我们使用3Dintersection over union(IoU)相似度统计信息(一种用于计算机视觉任务的常用度量标准)来评估三维实体检测模型的性能,该度量标准衡量边框与地面真相的接近程度。

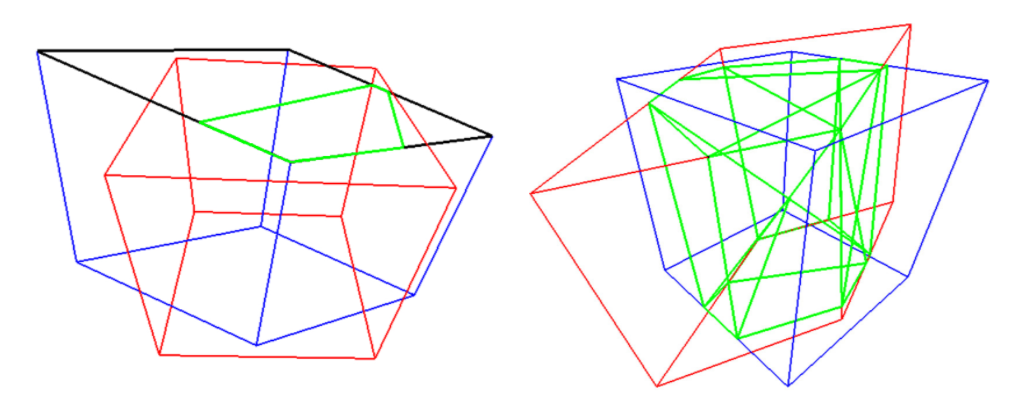

我们提出了一种算法,可为通用三维面向盒计算准确的3D IoU值。首先,我们使用Sutherland-Hodgman多边形裁剪算法计算两个盒子的面之间的交点。这类似于用于计算机图形学的视锥剔除技术。相交的体积由所有修剪的多边形的凸包计算。最后,根据两个框的交点的体积和并集的体积计算IoU。我们将在发表数据集的同时发布评估指标的源代码。

使用多边形裁剪算法计算并集的三维交点(左):通过对方框裁剪多边形计算每个面的交点。右:通过计算所有交点的凸包计算交点的体积(绿色)。

数据集格式

数据集的技术细节,包括用法和教程,可在数据集网站上找到。数据集包括自行车,书籍,瓶子,照相机,谷物盒,椅子,杯子,笔记本电脑和鞋子,并存储在Google Cloud存储上的objectron存储桶中,具有以下资源:

视频片段

注释标签(实体的3D边框)

AR元数据(例如照相机姿势,点云和平面)

已处理的数据集:带注释帧的改编版本,图像的格式为tf.example,视频的格式为SequenceExample。

支持脚本以基于上述指标运行评估

支持脚本以将数据加载到Tensorflow,PyTorch和Jax中并可视化数据集,包括“ Hello World”示例

有了数据集,我们还将开放数据管道,以在流行的Tensorflow,PyTorch和Jax框架中解析数据集。还提供了示例colab笔记本。

通过发布此Objectron数据集,我们希望使研究界能够突破三维实体几何理解的极限。我们还希望促进新的研究和应用。例如视图合成,改进的三维表达和无监督学习。加入我们的邮件列表并访问我们的github页面,请随时关注未来的活动和发展。

致谢

这篇文章中描述的研究是由Adel Ahmadyan, Liangkai Zhang, Jianing Wei, Artsiom Ablavatski, Mogan Shieh, Ryan Hickman, Buck Bourdon, Alexander Kanaukou, Chuo-Ling Chang, Matthias Grundmann, and Tom Funkhouser完成的。我们感谢Aliaksandr Shyrokau,Sviatlana Mialik,Anna Eliseeva和注释团队的高质量注释。我们还要感谢Jonathan Huang和Vivek Rathod对TensorFlow对象检测API的指导。

LiveVideoStackCon 2021 ShangHai

这个世界没有准备好这一说

机会和技术不会主动敲开你的门

LiveVideoStackCon 2021 上海站

北京时间:2021年4月16日-4月17日

点击 【阅读原文】 了解大会详情

本文分享自微信公众号 - LiveVideoStack(livevideostack)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。