kafka教程,完全参照w3school:

https://www.w3cschool.cn/apache_kafka/apache_kafka-dac11yot.html

以下是入门学习过程中摘录的一些操作

cd /usr/software/kafka

启动ZooKeeper

bin/zookeeper-server-start.sh config/zookeeper.properties

要启动Kafka Broker

bin/kafka-server-start.sh config/server.properties

创建Kafka主题

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic Hello-Kafka

主题列表

bin/kafka-topics.sh --list --zookeeper localhost:2181

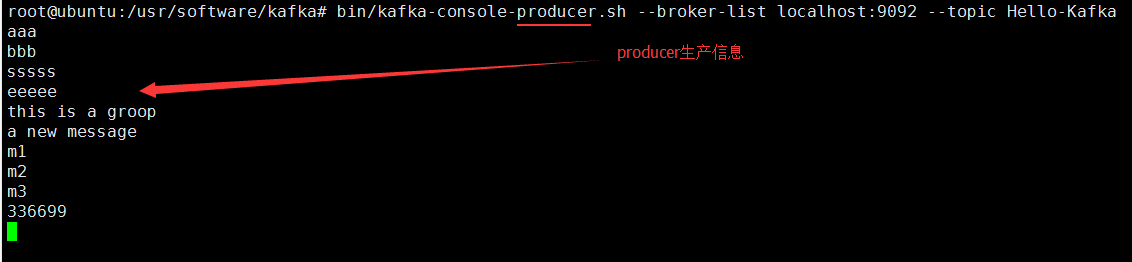

启动生产者以发送消息

bin/kafka-console-producer.sh --broker-list localhost:9092 --topic Hello-Kafka

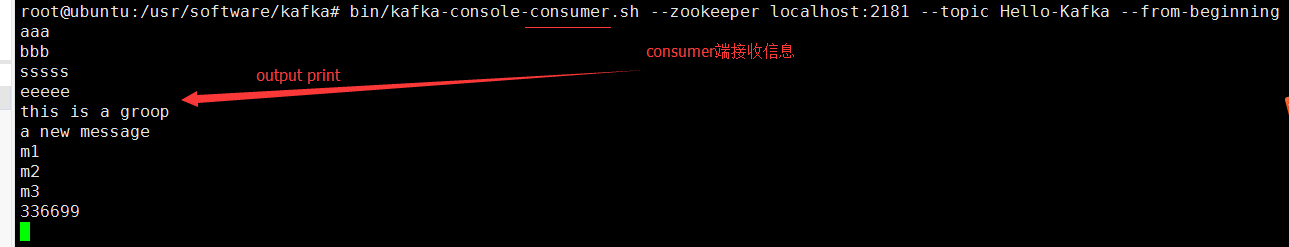

启动消费者

bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic Hello-Kafka --from-beginning

备注:producer启动好了之后,可以在producer console下输入任意信息(发布消息)

然后消息会发送到broker,然后就可以在consumer 端接收数据,包括离线数据

问题:

如果改动了 vi config/server.properties 配置ip

listeners=PLAINTEXT://192.168.204.135:9092

#listeners=PLAINTEXT://:9092

producer上需要带ip才能在consumer看到那个

producer>> bin/kafka-console-producer.sh --broker-list 192.168.204.135:9092 --topic Hello-Kafka

附录:

java代码发送消息到consumer看

<dependency> <groupId>org.apache.kafka</groupId> <artifactId>kafka_2.10</artifactId> <version>0.8.2.1</version></dependency>注意:以下这个例子和刚刚这个依赖对应版本使用,某些版本才包含 kafka.producer.KeyedMessage;这些类,高点的版本api变了,如pom改版本为<artifactId>kafka_2.12</artifactId> <version>2.0.0</version>,则下面java测试就引入不到一些类了

package cn.kafka;

import kafka.javaapi.producer.Producer;

import kafka.producer.KeyedMessage;

import kafka.producer.ProducerConfig;

import java.util.Date;

import java.util.Properties;

public class SimpleKafkaProducer {

private static String PRODUCER_URL="192.168.204.136:9092";//我的zookeeper 地址

private static String TOPIC="Hello-Kafka";//我的topic name

public static void main(String[] args) {

publishMessage(TOPIC, 1);

System.err.println("end");

}

/**

* 根据topic和消息条数发送消息

* @param topic

* @param count

*/

private static void publishMessage(String topic, int count) {

Properties props = new Properties();

props.put("metadata.broker.list", PRODUCER_URL);//指定producer连接的broker列表

/**

* 指定message的序列化方法,用户可以通过实现kafka.serializer.Encoder接口自定义该类

* 默认情况下message的key和value都用相同的序列化,但是可以使用"key.serializer.class"指定key的序列化

*/

props.put("serializer.class", "kafka.serializer.StringEncoder");

/**

* 这个参数用于通知broker接收到message后是否向producer发送确认信号

* 0 - 生产者producer不等待来自broker同步完成确认,继续发送下一条(批)消息

* 1 - producer在leader已成功收到的数据并得到确认后发送下一条message

* -1 - leader和following都完成确认,再继续

*/

props.put("request.required.acks", "1");

ProducerConfig config = new ProducerConfig(props);

Producer<String, String> producer = new Producer<String, String>(config);

for (int i = 0; i < count; i ++) {

String runtime = new Date().toString();

String msg = i+",Message published time - " + runtime;

System.err.println("msg = " + msg);

/**

* 第一个泛型指定用于分区的key的类型,第二个泛型指message的类型

* topic只能为String类型

*/

KeyedMessage<String, String> data = new KeyedMessage<String, String>(topic, msg);

producer.send(data);

}

producer.close();

}

}

发完可以到consumer端查看结果