参考文档

https://www.cnblogs.com/linjiqin/p/11950758.html

https://blog.csdn.net/dayonglove2018/article/details/106925513

https://blog.csdn.net/valada/article/details/80892612

https://www.jianshu.com/p/18d03c6b2931

https://blog.csdn.net/m0\_37867405/article/details/80944125

https://blog.csdn.net/godloveayuan/article/details/107361601

https://www.cnblogs.com/listenfwind/p/12465409.html

https://www.jianshu.com/p/23c678e39162

概念

简介

Kafka有四个核心的API:

The Producer API 允许一个应用程序发布一串流式的数据到一个或者多个Kafka topic.

The Consumer API 允许一个应用程序订阅一个或多个 topic,并且对发布给他们的流式数据进行处理.

The Streams API 允许一个应用程序作为一个流处理器,消费一个或者多个topic产生的输入流,然后生产一个输出流到一个或多个topic中去,在输入输出流中进行有效的转换.

The Connector API 允许构建并运行可重用的生产者或者消费者,将Kafka topics连接到已存在的应用程序或者数据系统.比如,连接到一个关系型数据库,捕捉表(table)的所有变更内容.

zookeeper

kafka的发送与接收

发送:kafka的发送程序(代码)会指定broker服务地址,那么消息的发送会直接发送到broker提供的地址中.

如果地址是列表(指定了多个broker地址),那么则随机选择一个可用的发送.接收到消息的kafka机器会向zookeeper查询拥有该topic下partition决定权(leader)的机器,然后由该leader选择机器存储数据,最终存储数据.

接收:kafka的接收会指定zookeeper地址,那么接收到消费任务的zookeeper将任务报告给该topic下partition的leader,由该leader指定follower完成数据的获取并返回.

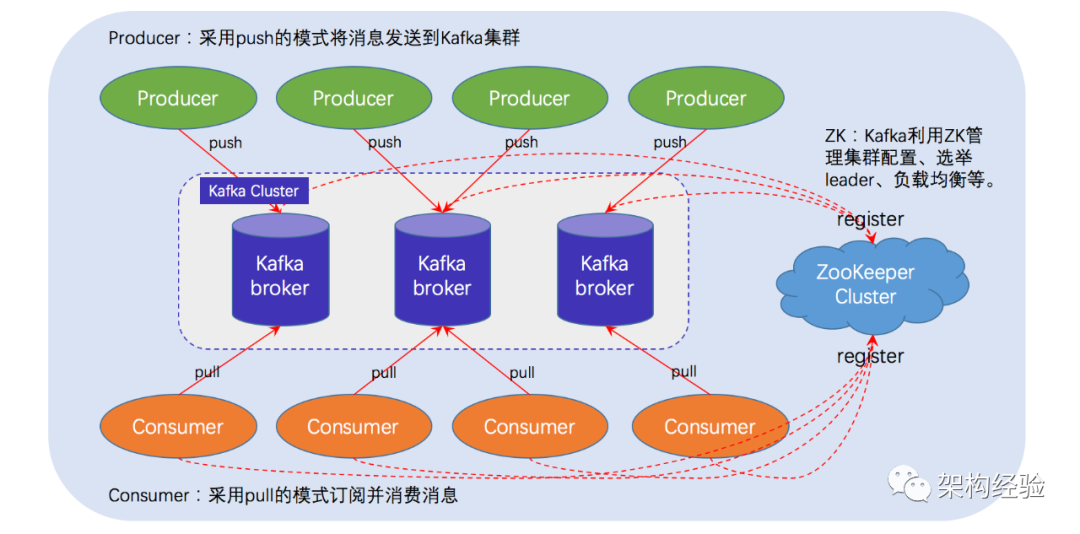

一个典型的 Kafka 体系架构包括若干 Producer(消息生产者),若干 broker(作为 Kafka 节点的服务器),若干 Consumer(Group),以及一个 ZooKeeper 集群.Kafka通过 ZooKeeper 管理集群配置.选举 Leader 以及在 consumer group 发生变化时进行 Rebalance(即消费者负载均衡,在下一课介绍).Producer 使用 push(推)模式将消息发布到 broker,Consumer 使用 pull(拉)模式从 broker 订阅并消费消息.

Kafka安全认证SASL/PLAIN,并和springBoot整合

修改kafka启动配置文件server.properties

cd /usr/local/etc/kafka

# 设置broker的唯一标识(集群唯一随便设置).

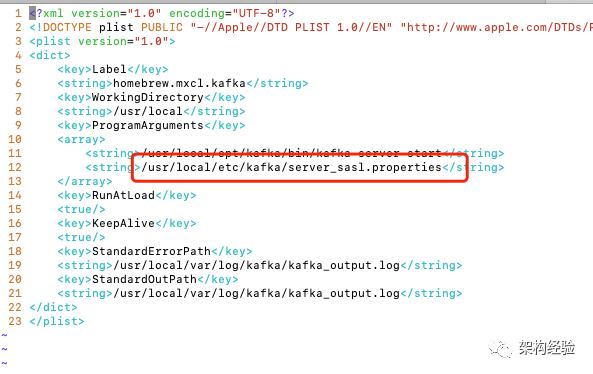

cd /usr/local/opt/修改启动文件

config添加kafka_server_jaas.conf 文件

vi kafka_server_jaas.conf

username/password是给kafka brokers之间作为client初始请求连接访问使用的,会被作为server的broker验证.

user_kafkaadmin这个就是1中提到的连接访问请求验证信息,所以这条是必须的.

user_kafkaclient1/user_kafkaclient2定义了kafka的client,其值就是密码.

Client是把kafka作为client端,访问zookeeper(作为server端)的时候用的.对应的必须在zookeeper里面做相应的配置.

kafka-server-start.sh添加

cd /usr/local/opt/kafka/libexec/bin

添加zookeeper_jaas.conf

cd /usr/local/etc/kafka

user_zooclient这个用户就是前面kafka_server_jaas.conf里面的Client信息;

这样就对上了:这两个用户名和密码必须一致,作为kafka client和zookeeper server之间认证使用.

zookeeper-server-start.sh添加

cd /usr/local/opt/kafka/libexec/bin

修改brew services 启动文件

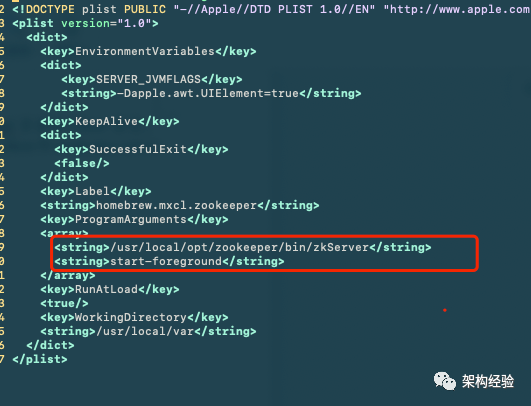

cd /usr/local/opt/zookeeper

<string>/usr/local/opt/kafka/bin/zookeeper-server-start</string>

直接启动,观察是否有错误

分别启动各个kafka,指定自定义的配置文件,先不要后端启动,观察,日志有没有出错

cd /usr/local/opt/kafka/libexec/

安装中遇见的问题

- 出现The valid options based on currently configured listeners are PLAINTEXT

查看变红处listeners=SASL_PLAINTEXT://localhost:9092

配置错误

KafkaServer{

逗号的问题

springboot整合

生产者yml中配置

kafka:

消费者yaml配置

kafka:

更新

kafka更新主要配置的更改

zookeeper可以直接更新而无需其他操作

主题与分区

主题.分区与副本

主题(Topic):

Kafka中的消息以主题为单位进行归类,生产者负责将消息发送到特定的主题,而消费者负责订阅主题进行消费;

分区(Partition):

主题可以分为多个分区,一个分区只属于单个主题;

同一主题下的不同分区包含的消息不同(即,发送给主题的消息具体是发送到某一个分区);

消息被追加到分区日志文件的时候,会分配一个特定的偏移量(offset),offset是消息在分区中的唯一标识,Kafka通过它来保证消息在分区的顺序性; offset不跨分区,也就是说Kafka保证的是分区有序而不是主题有序;

副本(Replia):

Kafka为分区引入了多副本机制,通过增加副本数量可以提升容灾能力.

同一个分区的不同副本之间保存的是相同的消息;副本之间是一主多从的关系,其中leader副本负责处理读写请求;follower副本只负责与leader副本的消息同步;

副本处于不同的broker中,当leader副本出现故障时,从follower副本重新选举新的leader副本对外提供服务.

Kafka通过多副本机制实现了故障的自动转移;

多分区与多副本机制

主题和分区是逻辑结构,一个副本对应一个存储消息的日志文件;

分区的多个副本分布在不同的broker上,所以主题和分区都是横跨broker的;

一个主题下对应多个分区,通过增加分区数量可以实现水平扩展,提高性能;

一个分区下有多个副本,通过多副本机制提升容灾能力;

主题正则表达式

topicPattern 为正则表达式主题配置

例子:@KafkaListener(topicPattern = "handle_diag_udsReadDid_.*")

消费者群组

为什么kafka的消费者要有分组的概念

通常一个分区由一个消费者消费,或者说由一个组中的一个消费.

有一种情况,分区数多,且只有一个消费者时,分组的话,消息会被组中唯一一个消费者线性消费,不会发生争抢.因为消息能被组中一个消费者线性消费.

不分组的话会消息都会被消费者拉过去.

删除topic

真删除

server.properties配置delete.topic.enable=true

本文作者:Mr丶Ant (目前单身)

源码样式不太友好,影响阅读体验,建议访问原文地址或者点击 [阅读原文]

https://www.jiagou.com/post/61-make-cross-rpm

本文分享自微信公众号 - 架构经验(gh_1e5343e31369)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。