前言

从刚开始接触Mxnet这个框架到现在已经大概四个月了。Mxnet最吸引我的地方就是它提供了

很多语言的接口,其中有Scala(my favorite),这是我从Caffe转过来的原因之一。

Mxnet是我第一个参与的开源项目,可以说这四个月来我学到了很多东西。

本文的其中目的在于介绍一下如何用 Mxnet Scala 包来开发自己的 deep learning 的应用,有

哪些坑需要注意的,最后就是安利一下Mxnet 这个框架了。

然后,还有就是Mxnet Scala Package已经开始 Spark了,有兴趣可以尝试一下。

正文

Eclipse配置Mxnet scala的开发环境

这里我是直接用ScalaIDE来开发。下面介绍如何配置开发环境,过程很简单,就是有些小细

节需要注意。

编译Mxnet Scala 包

首先要做的就是要编译出Mxnet的jar包了,环境配置具体可以看官方网站上的流程,这里就

不重复了,https://mxnet.readthedocs.io/en/latest/how_to/build.html,在 Ubuntu的配置按照流

程来的话一般没什么问题,CentOs的话就有点麻烦,但还是可以的。

我的环境是 atlas + cuda 7.5 + cudnn v4 + opencv 3.0。atlas + cuda 8.0 + opencv 3.0。然后修改一下make/config.mk,make -j4 就行了,编译完Mxnet之后就开始编译Scala 包了。

首先要安装 JDK8,http://tecadmin.net/install-oracle-java-8-jdk-8-ubuntu-via-ppa/ 。

然后下载maven,https://maven.apache.org/download.cgi,目前版本是 3.3.9。

下载解压完成之后,在.bashrc文件中加入以下两句,然后 source ~/.bashrc:

export M2_HOME=~/apache-maven-3.3.9

export PATH=$M2_HOME/bin:$PATH

假设maven目录在home目录下。然后只要能够找到mvn这个可执行文件就行了。

然后在 Mxnet 目录下执行,make scalapkg即可,然后可以泡杯茶等了,第一次编译scala包

的话,会下载很多的jar文件,都放在 ~/.m2/repository/目录下。之后再编译的话就很快了。编

译完成之后,在 scala-package/assembly 目录下,如果你是在config.mk中设置了GPU支持的

话,那么编译好的jar包就在 linux-x86_64-gpu/target目录下。

配置ScalaIDE

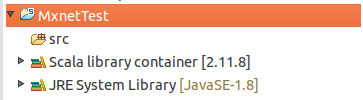

这里我们先新建一个Scala Project,MxnetTest 。

然后删除Scala library,接着导入 Mxnet scala jar 包。直接 Add External JARs,

导入 assembly目录下的

mxnet-full_2.10-linux-x86_64-gpu-0.1.2-SNAPSHOT.jar

mxnet-full_2.11-linux-x86_64-gpu-0.1.2-SNAPSHOT.jar

跑个Scala的例子 --- NeuralStyle

首先把scala-package/examples/src/main/scala/ml/dmlc/mxnet/examples/neuralstyle

下的两个Scala文件复制到 工程src目录下,然后稍微修改一下,把文件的第一行package

去掉。然后就是导入所有依赖包,直接暴力把 scala-package/examples/target/classes/lib

目录下的所有Jar包导入即可。

还有把 scala-package/examples/src/main/resources/log4j.properties文件拷贝到工程

bin目录下。

然后编译一下应该就可以准备运行了。如果想看看命令行怎么运行的话可以看看

scala-package/examples/scripts 目录下的 run_neuralstyle.sh 脚本。

运行所需的图片和模型可以 example/neural-style/download.sh 这个脚本来下载。

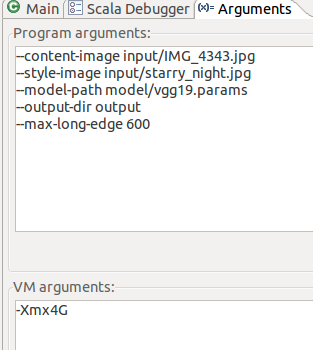

右键NeuralStyle -> Run As -> Run Configurations,在Arguments 那一栏做如下设置:

然后 run 即可。跑到后面大概要占 2G左右的显存。如果显存不够的话,可以把

--max-long-edge 这个参数设置为小一些。

大概运行600次迭代之后就能得到最终的结果了,和Python的例子给出的结果有点差距,效

果还能看,之前其实也是根据Python的例子改写成 Scala版本的,当时大概用了一周时间吧,

写好代码之后还要调下参数等等。

用Mxnet实现矩阵分解(Matrix Factorization With Mxnet)

用Mxnet Scala 包实现一下矩阵分解,就是推荐系统常用到的矩阵分解,主要是参考这位大

神的博客,http://www.jianshu.com/p/ebf7bf53ed3e,

还有http://katbailey.github.io/post/matrix-factorization-with-tensorflow/。

用到的数据集的下载地址:http://grouplens.org/datasets/movielens/100k/。

由于目前的官方的Mxnet Scala 包还没有支持 sumAxis这个操作,因为实现这个矩阵分解的

功能需要用到这个operator,所以可以修改自己的Mxnet Scala源码,向Symbol.scala 中 object

Symbol 这个伴生对象加入

以下函数:

/**

* Take sum of the src in the given axis

*

* Parameters

* ----------

* data : Symbol. Input data to sum.

* axis : int, default=-1, means to reduce all the dimensions.

*/

def sumAxis(name: String = null, attr: Map[String, String] = null): SymbolCreateNamedFunc = {

createFromNamedSymbolsNoCheck("sum_axis", name, attr)

}

然后重新编译一下Scala 包即可。

下面是完整的实现代码:

https://github.com/Ldpe2G/DeepLearning/tree/master/Mxnet-Scala/MatrixFactorization

这里实现上和上面那篇博客有些不一样的地方,最终的结果,以RMSE这个指标来衡量的话,

可以达到 0.95x左右,比博客提到的0.8x差一点。这里如果不想改代码直接跑的话,可以把下

载的ml-100k.zip这个数据集放到project目录下的datas目录里解压。

其实通过跟着实现一遍代码,我学会了如何利用深度学习框架来做矩阵分解了,感觉真的很

神奇。

最后希望这篇博客能够对想了解 Mxnet Scala Package 开发的读者提供一些帮助。