喜欢我们,点击上方AINLPer,关注一下,极品干货即刻送达!

自我隔离的第六天,今天阳光特别好,但是不能出门,不过托别人的福,今天整了个汉堡(好久没有吃肉了),美滋滋~~

引言

该篇文章是今年AAAI2020顶会上的一篇文章,其主要研究背景是文本简化,文本如何简化才能得到比较好的结果,是什么因素在影响着文本简化效果呢,针对这些问题,论文作者从各个方面进行了分析,例如文档的长度、标题、带有关联词的句子等。本篇文章对研究文本简化有些指导意义,在工程上面的可取的应该是RST。

正文开始

1

First Blood

TILE: Discourse Level Factors for Sentence Deletionin Text Simplification.

Contributor: 俄亥俄州立大学

Paper: arxiv.org/abs/1911.1038

Code: None

文章摘要

文本简化需要对相关的句子予以删除,在此背景下,文档简化需求中普遍存在但仍处于研究阶段。 针对此问题,本文使用一个新的人工标注的句子对齐语料库来检查与句子删除相关的各种文档以及话语因素。在此过程中发现专业编辑人员使用不同的策略来满足中小学的可读性标准。为了预测某个句子在简化过程中是否会被删除,我们利用自动对齐的数据来训练一个分类模型。根据我们的手动注释数据进行评估,我们的最佳模型在小学和中学阶段的F1得分分别达到65.2和59.7。研究发现,话语水平因素有助于预测 简化句子的难度。

文章背景介绍

文档简化的目的是为了让更多的观众了解文本内容中真正意图,在其简化过程中其实涉及多种操作,主要包括:词法、句法转换、摘要以及难读内容的删除和解释。最近这几年关于文档简化的研究也在呈爆发式增长,但是大部分的研究模式主要还是集中在句子级别上,即如何能够让句子更加简化。然而却忽略了文档级别上简化,因为这样可以删除句子,这样可以让文档更加简化。 本文的工作旨在促进更好地理解文档级简化中的句子删除。 因为句子的删除除了句子中的内容外,还部分地由上下文,话语级信息驱动。

文章主要内容

数据准备及思路

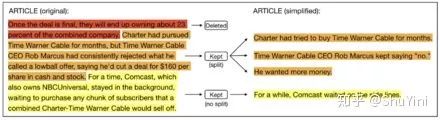

使用936个新闻文章的Newsela文本简化语料库。每个文章集由原始文章的4或5个简化版本组成,范围从3至12级(对应于8至18岁)。我们将文章分为三个阅读级别:原始(1-2年级),初中(6-8年级)和小学(3-5年级)。我们从每个阅读级别使用一种版本的文章,并研究两种文档级别的转换:原始→中间和原始→基本。 我们进行分析,学会预测当将文本简化为所需的阅读水平时,专业编辑人员是否会丢弃一个句子。为了获得标记数据进行分析和评估,我们手动对齐了50个文章集的句子。生成的数据集是用于简化句子对齐的最大手动注释数据集之一。下图1显示了原始文章中的3句段落,与小学版本一致。

原始文章中不能与较低阅读水平的任何句子相匹配的句子被认为已删除。为了训练用于句子删除预测的模型,我们依靠来自语料库其余部分的自动对齐句子的嘈杂监督。

话语等级因素分析(摘要修辞结构RST)

本文提出了一系列的分析来研究在简化过程中可能影响句子删除的话语层次因素,包括文档特征、修辞结构和话语关系。

文档特征

文档的长度。 实验对比发现文档越长,句子被删除的比例就越高。

文档的主题。 主题的删除率各不相同。科学类文章的删除率在初中和小学阶段都明显较低。关于金钱和法律的文章的删除率明显高于其他文章。

摘要修辞结构理论(RST)

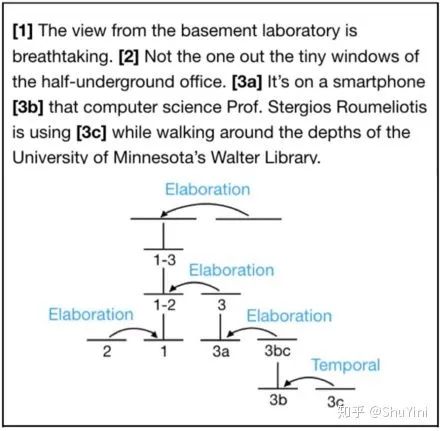

摘要修辞结构理论(RST)从基本的语篇单元(基本的独立子句)出发,描述了语篇树中篇章跨度之间的关系,RST被认为在相关的应用中是有用的。具体RST树的例子如下图所示:

其中,箭头代表核(箭头)和卫星(箭头尾)。在原始阶段,保留并重述[1],删除[2],保留第三个句子,但将其拆分为两个[3a]和[3b]作为一个句子,[3c]作为另一个句子。在这里,我们将重点放在每个句子如何位于原始文档的第一棵树中,因此我们将每个句子视为一个话语单元(不一定是基本的话语单元)。

话语树的深度。 被删除的句子在话语树中所处的位置明显低于被保留的句子。由于显著性句子更倾向于位于语篇树的根附近,这表明显著性在决定一个句子是否应该被删除时起着一定的作用。

核。 实验发现,虽然在小学阶段,附属句往往被删除,但是差异很小。

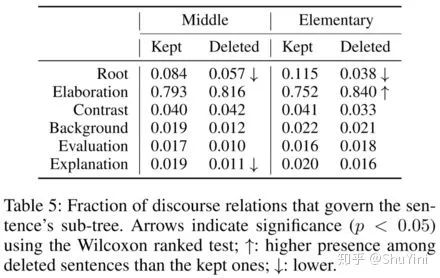

话语相关

内部句子相关性。 观察到精化关系是数据集中最频繁的关系;简化另一个句子的句子在简化过程中更可能被删除(对基本水平而言具有统计学意义)。与任何关系(根)无关的重要句子在两个级别上被删除的可能性均大大降低。此外,用作现有句子解释的句子在简化过程中被删除的可能性较小(对于中学水平而言,这一点很明显)。如下表所示。

话语链接词。 连接词的位置(句子的开头和结尾)是判断它们之间的关系是句内关系还是句间关系的重要指标,一般编辑都不乐于把带有连接词的句子删除掉。

实验结果

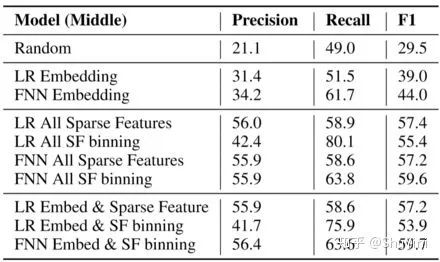

我们运行两个任务的实验,首先建立一个分类模型,以了解在简化到中级和原始级别时是否可以预测是否应删除句子。其次,我们进行特征消融,以确定在嘈杂的监督下实践文件和话语信号是否有帮助。 对于原文中的一个句子,我们(i)预测它是否会在简化到初中水平时被删除,从自动对齐训练到噪声监督;(ii)初级阶段的预测也相同。我们使用15篇手动对齐的文章作为验证集,其他35篇文章作为测试集。

实验方法:我们使用逻辑回归(LR)和前馈神经网络(FNN)作为分类器,并尝试从多个可能互补的方面进行特征测试。 为了捕获句子级语义,我们考虑GloVe词嵌入的平均值。稀疏特征(SF)包括句子在整篇文章以及其所在段落中的相对位置。此外,我们还包括以下句子的可读性评分。利用我们的语料库分析(第3节),我们结合了文档级别的功能,包括文档中句子的总数和单词数以及文档的主题。我们的话语功能包括当前句子的深度,核的指示符特征以及文档的支配关系RST树中的当前句子,是否存在我们分析的四个关系之一的显式连接词以及该连接词的位置。我们还使用句子的位置,因为文章后面出现的句子更有可能被删除。为了提高预测性能,我们采用了一种平滑分类方法,并通过应用k个高斯径向基函数将每个稀疏特征(二进制或数字的稀疏特征)投影到k维矢量表示中。

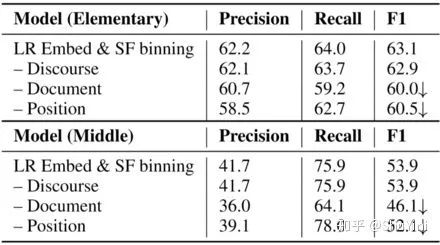

小学阶段简化句子删除预测的效果。

表8

中学阶段简化句子删除预测的效果。

表9

特征消融分析通过每次删除一个特征类别来预测句子的删除。

表10

结论: 1、中学级别的比较难预测;

2 、FFNN+Gaussian层的模型运行结果比较好。

2

往期回顾

学术圈

收藏!「自然语言处理(NLP)」AINLPer 大 盘 点 !!

收藏!「自然语言处理(NLP)」全球学术界”巨佬“信息大盘点(一)!

论文阅读

ICLR 2020必看!「自然语言处理(NLP)」金融情感分析FinBERT模型(含源码)!!

「自然语言处理(NLP)」【爱丁堡大学】基于实体模型的数据文本生成!!

长按识别下方二维码,关注我们吧(づ ̄3 ̄)❤~

资料整理实属不易,点个【在看】再走吧~~

本文分享自微信公众号 - AINLPer(gh_895a8687a10f)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。