MindStudio Profiler简介

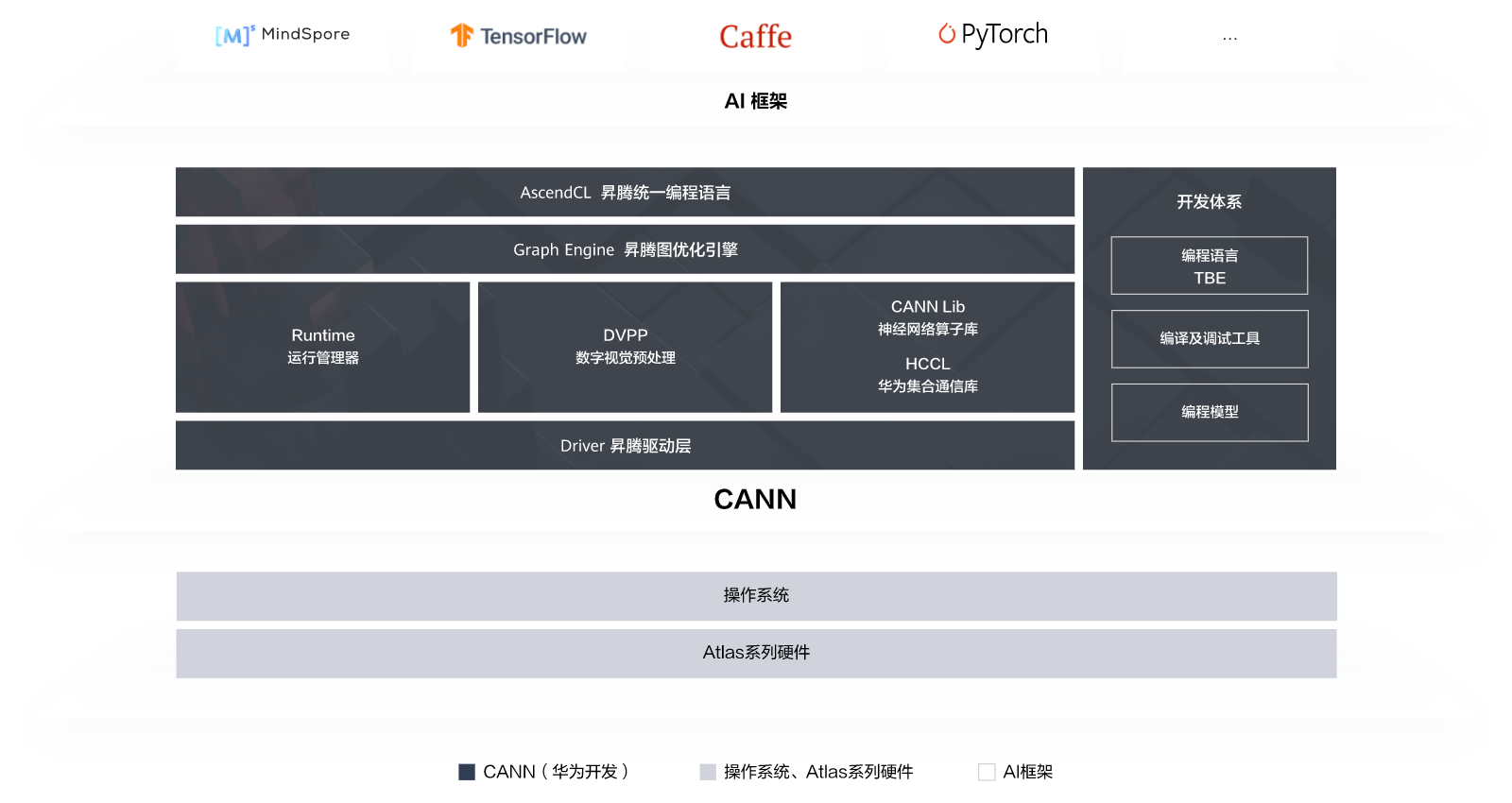

Ascend AI处理器是一款面向AI业务应用的高性能集成芯片,包含AI CPU、A Core、AI Vector Core等计算单元来提升AI任务的运算性能。基于Ascend AI处理器,Mindstudio在算子开发、模型训练及推理应用等不同环节,提供了端到端的Profiler工具。该工具可以帮助用户看到模型从应用层到芯片层的接口和算子耗时,从而准确定位系统的软、硬件性能瓶颈,提高性能分析的效率。

调优主要分为三步:

性能数据采集、解析、分析

性能问题定位,发现性能瓶颈点

采取性能优化措施

性能分析简要介绍

通过命令行采集性能数据

数据采集方式

.msprof.bin

数据采集方式——离线推理

- acl.json配置文件方式

打开工程文件,查看调用的aclInit0函数,获取acl.json文件路径

修改acl.json文件,添加Profiling相关配置

- AI任务相关性能数据采集方式 - API接口

API接口类型

aclprofinit: 设置落盘路径

aclprofCreateConfig: 设置采集参数

aclprofStart: 开始采集

aclmdlExecute: 执行模型

aclprofStop: 结束采集

aclprofDestroyConfig: 释放配置资源

aclprofFinalize:释放profiling组件资源

API接口规范

ACL API(C接口)

pyACL API (Python接口)

- 数据采集方式——在线推理与训练

MindSpore

TensorFlow

环境变量配置:

export PROFILING MODE=true

export PROFILING OPTIONS='"output":"/tmp","training trace":"on""task trace":"on","aicpu":"on,"aic metrics:"PipeUtilization")训练脚本配置 Estimator模式下,通过NPURunConfig中的profiling_config开启Profiling数据采集。

sess.run模式下,通过session配置项profiling_mode.profiling_options开启Profiling数据采集。

Pytorch 框架侧数据的采集方法

with torch.autograd.profiler.profile(use_npu= True) as prof:

for epoch in range(10):

y_pred = model(x data)

loss = loss_func(y_pred, y_data)

loss.backward()

profexport_chrome_trace( 'profiler.json')

Pytorch CANN侧数据的采集方法

config=torch_npu.npu.profileConfig(

ACL_PROF_ACL_API=True,

ACL_PROF_TASK_TIME=False,

ACL_PROF_AICPU=False,

AC_PROF_AICORE_METRICS=False,

aiCoreMetricsType=0)with torch.npu.profile (profiler_result_path, config=config) as prof:

for epoch in range(10):

y_pred = model(x data)

loss = loss_func(y_pred, y_data)

loss.backward()

同时采集PyTorch框架侧和CANN数据

msprof.bin

with torch.npu.profile (profiler result path, use e2e profiler=True) as prof:

for epoch in range(10):

y_pred = model(x data)

loss = loss func(y_pred, y_data)

loss.backward()

对比不同迭代的耗时

with torch.npu.profile (profiler_result_path) as prof:

for epoch in range(10):

torch_npu.npu.iteration_start()

Y_pred = model(x data)

loss = loss_func (y_pred, y_data)

loss.backward()

torch_npu.npu.iteration end()

msprof --export=on --output= fprof path] --iteration-id=3

仅采集需要的迭代

def execute model():

y_pred = model(x data)

loss = loss_func(y_pred, y_data)

loss.backward()

for epoch in range(10):

if epoch != 2:

execute model()

else:

with torch.npu.profile (profiler_result_path) as prof:

execute model()for epoch in range(10):

if epoch == 2:

torch_npu.npu.prof_init(profiler_result_path)

torch_npu.npu.prof_start()

execute model()

if epoch == 2:

torch_npu.npu.prof_stop()

torch_npu.npu.prof_finalize()

- Profiling数据说明

(1) Step trace timeline数据: step trace数据查看选代耗时情况,识别较长选代进行分析。

msporf --export=on --output=prof_path

(2) 对应迭代的msprof timeline数据: 通过打开导出的msprof数据查看送代内耗时情况,存在较长耗时算子时,可以进一步找算子详细信息辅助定位;存在通信耗时或调度间隙较长时,分析调用过程中接口耗时。

(3)HCCL timeline数据:通过多卡进行训练时,卡间通信算子也可能导致性能瓶颈。

(4)打开组件接口耗时统计表:可以查看迭代内AscendCL API 和 Runtime APl的接口耗时情况,辅助分析接口调用对性能的影响。

(5)打开对应的算子统计表:可以查看送代内每个AI CORE和AI CPU算子的耗时及详细信息,进一步定位分析算子的metrics指标数据,分析算子数据搬运、执行流水的占比情况,识别算子瓶颈点。

- 优化案例——算子融合

通过MindStudio IDE分析性能

IDE模式

集群调优