10月20日北京,一年一度的LiveVideoStackCon 2017音视频技术大会在北京丽亭华苑酒店举行,会议甄选多媒体开发领域最新技术实践与应用案例,大会设立9大专题、1场技术培训,超过50场技术分享,近400位来自教育、视频会议、社交、游戏、电商、安防、金融、物联网等行业的工程师、技术负责人以及高端行业用户、产品与项目负责人、分析师、投资人、媒体人齐聚一堂。

首先,沪江合伙人、沪江旗下CCtalk公司CEO陆坚代表LiveVideoStackCon的社区力量做致辞,他表示,音视频技术的应用前景广阔,对技术的挑战依然巨大,技术社区能给技术人提供学习、互助的平台,共同推动技术的发展。

在上午的主题演讲环节,谷歌(Google)软件工程师Zoe Liu分享了开放流媒体压缩标准AV1的一些最新进展,Akamai媒体工程部总架构师William Robert Law分享了全球OTT内容分发技术的演进近况,华为多媒体实验室首席科学家、实验室副主任王田则分享了沉浸式媒体标准化方面的一些近况。以下将一些演讲重点内容进行摘录,与各位读者分享。

主题演讲1:AOM - Open Source Video Codec

Zoe Liu,谷歌(Google)软件工程师,主要致力于视频编码与视频通信的算法设计与实现。曾在美国贝尔实验室(Bell Labs)、诺基亚研究中心(Nokia Research Center)、惠普实验室(HP Labs)等处从事理论算法研究,后转入工业界,参与了如下视频通话产品的设计与推出:苹果(Apple)的FaceTime,谈客 (TangoMe)Video Calls,以及谷歌眼镜(Google Glass)专属Hangouts Video Calls。目前在谷歌从事下一代开源无版权费(Open Source, Royalty Free)的AV1视频编码的标准制作。

Zoe当前所在的Chrome Media是Google Chrome下的一个团队。Google整体来说一直在推进开源、无版权费的诸多项目,而Chrome Media团队目前主要的工作包括如下方面:

视频流压缩标准 VP8、VP9、AV1

图像压缩标准 WebP

音频编码 Opus

3D图形编码软件 Draco

本次演讲主要集中在对AV1的介绍方面。AV1的前身很大程度上来自VP9,VP9是Google在2013年推出的视频流压缩标准,同年首先在YouTube平台上采用之后,得到了非常好的性能提升。根据YouTube的数据,VP9相比H.264无论是码率性能还是缓冲效率上都要更好,而根据VP9的另一个大用户Netflix的数据,VP9相比H.265是不相上下的。其实H.264也是基于开源的宗旨来做的,但是没有做成免版税。站在Google的立场,它一直希望互联网基础技术都能够是开源、免版税的,所以才会有Chrome Media这个团队专门做媒体领域的开源、免版税技术。

随着VP9的普及,越来越多的公司也想要参与这样一个开源、免版税的视频流压缩标准的制定工作,在这个过程中,就形成了Alliance of Open Media(开放媒体联盟,AOM)这样一个组织,这个AOM成立之后进行的第一代编码标准就是AV1。2015年AOM成立时有七名成员,到今天2017年已经发展到31名成员,包含互联网视频内容平台、硬件厂商等多个层面的参与者。AV1的研发希望对各种应用场景、硬件和带宽环境都尽可能进行优化,尤其是近几年增加了很多用户直接用手机拍摄视频的场景,希望能对这种内容创作也提供更好的优化。另一方面,解码端的复杂度仍然要尽可能降到最低。

AV1的开发流程大体如下:

首先是算法组这边研发提交新的算法工具,并且要在自己的编码器、解码器里面做实现,来证明新的工具在性能方面的表现,比如压缩比比之前提高多少。因为新工具的加入基本上都会增加项目的复杂度,而项目整体又要控制复杂度不能太高,所以新工具是否能够被AOM接受,也得进行复杂度的评估。

另一方面,因为AV1要做到适合硬件实现,所以算法组跟硬件组会有频繁的交流。在Google内部,两个组之间可能一两周就会沟通一次,另外在AOM联盟当中的硬件公司也有很大的话语权,他们会对新算法的硬件实现给出困难评级。

这方面迭代之后,就会交到AOM联盟的审核组,联盟成员投票决定是否采纳。这期间还会在Mozilla提供的测试平台上进行各方面的数据采集,比如在不同的码率、带宽环境、不同的视频原材料下,性能究竟提高多少。根据目前的测试数据,AV1已经在各方面性能比VP9有所提升。

根据一个月前的最新数据,AV1现在正式的工具已经上线了40多个,另有20个左右的工具正在审核。希望了解详情的同学可以从以下仓库中查看AOM项目的现状:

git clone aomedia.googlesource.com/aom

按照之前制定的时间表,今年年底应该会确定下所有的核心工具与码流格式。码流格式定稿之后,预计8~10个月内会有硬件实现,24个月之内就会有终端产品。网络平台方面,预计YouTube很快就会使用AV1,同时Netflix也承诺会是AV1的早期使用者。

具体技术层面,AV1与VP9有很多相似之处,所以如果对VP9已经很了解,那么对AV1也会相对比较容易上手。Zoe在主题演讲上简单介绍了一些AV1的编码工具,包括预测工具、变换工具、视频恢复工具(in-loop filtering,AV1在这方面做了很多工作)等,在10月21日的【编解码实践应用】专题,她还会有一个专门的演讲介绍这些工具。

最后,Zoe希望大家能够支持AOM联盟的工作,加入联盟的开源平台,一同打造开源、免版税的视频编解码技术。

主题演讲2:全球OTT内容分发技术的演进

William Robert Law,Akamai媒体工程部门首席架构师,在流媒体领域有18年从业经验,在Akamai有10年工作经历,其在多年前所编写的一些连接框架现在仍在Akamai系统中运行着。目前,Law关注MPEG DASH与HTTP流媒体、技术评估、4K内容分发、VR内容分发、CMAF、WebRTC、cloud transcoding以及multi-bitrate switching。Law同时承担DASH产业论坛副总裁、CTA WAVE项目副主席的职务。在加入Akamai之前,Law曾在Adobe、Internap等公司供职。

Law首先介绍到,Akamai当前在全球有2400多个节点(数据中心)。在中国大陆地区虽然没有自己的节点,但是也有为数不少的合作伙伴数据中心分布在各个城市,目前Akamai在中国的主要业务是帮助中国企业将内容分发到海外。

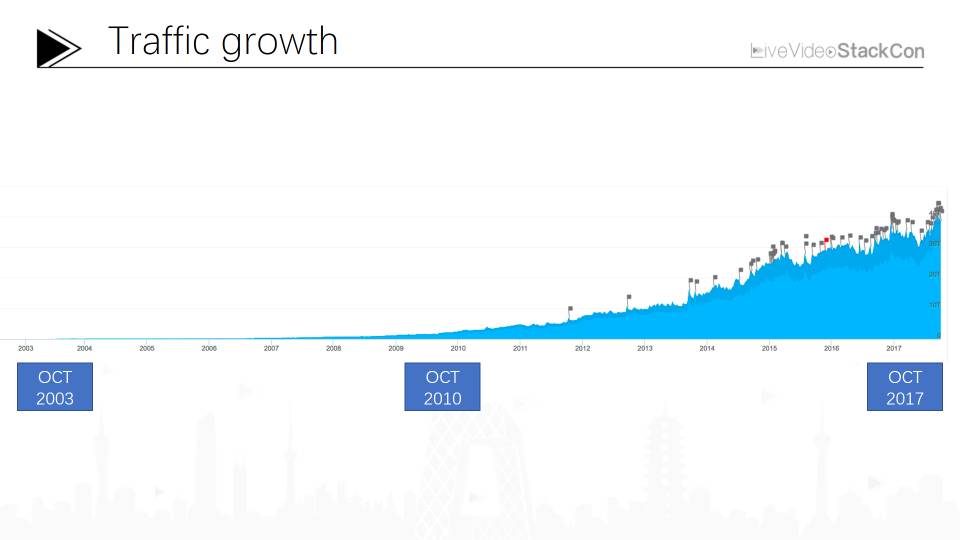

之后,Law分享了几组数据。在2007年,Akamai的流量高峰一度达到715 Gbps,在当时看来是非常高的一个数字;然而十年之后,今天的流量高峰达到了61 Tbps,相当于8500%的增长。根据Akamai的数据分析,流量的增长率在2011年到2012年期间有一个显著的提升,而提升的重点原因就在于网络视频的崛起。

单一视频流的流量峰值也增长明显。2014年世界杯期间,单一视频流量高峰达到7.2Tbps;2016年的一次发布会期间,单一视频流量高峰达到11.1Tbps;到了2017年,则增长到17Tbps。

在中国,用户带宽的发展也是相当迅速的。目前,中国的平均带宽已经超过了8Mbps,这是一个足以承载1080p视频流的带宽,而且这只是平均值,在中国发达地区的带宽应该要高于此平均值,不过目前全球范围来看,能够全面支撑4K在线视频(相当于15Mbps)的地区还不太多。

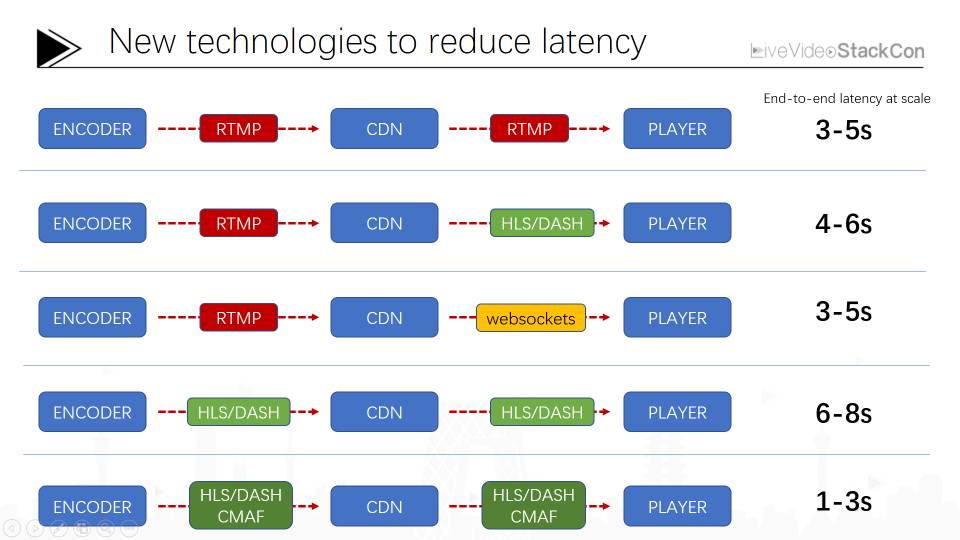

延时也是在线视频关注的一个大问题。实时视频流分发技术目前有几个比较流行的技术栈,如RTMP、HLS/DASH、websocket、以及Akamai现在在推的CMAF等,各自有各自的优缺点。Law在下午的【新一代CDN】专题有一场演讲专门介绍这些技术栈。

为什么Akamai要推动CMAF呢?因为Akamai做为CDN服务商,一直有一个比较困扰的问题,就是同一个视频内容,因为不同客户端需要不同的格式(如HLS、DASH、Smooth、HDS等),就导致每一种格式都在CDN节点上挤占cache空间。CMAF全称Common Media Application Format,由微软和苹果已经Akamai、Cisco、Comcast等公司共同发起,从2016年2月开始起草,到2017年8月已经进入终稿状态。CMAF不是一种新的视频格式,而是一种容器,对AVC(H.264)、HEVC(H.265)、VP9都支持,HLS和DASH manifests都可以对其内容进行调用,这样不仅可以节省一半的存储空间,还可以节省一半的编码成本。另外,CMAF还有一个chunks的设计,比如一个fragment一般可能有4秒长度,那么一个chunk可能只有100ms长度,这样就大大降低了客户端感知的延时。

另外,Law还提到了智能电视操作系统的一些市场格局、AV1推广的一些近况,以及VR视频流的发展近况。

主题演讲3:沉浸式媒体标准化

王田,毕业于清华大学电子工程系,获得博士学位。2000年加入微软工作10年,负责WMA Voice v9,MSRTA音频Codec研发,及微软LCS音频系统架构工作。2010年加入华为媒体技术实验室,任首席科学家、实验室副主任,从事音视频编解码、媒体通信系统及AR/VR等领域的研究工作。

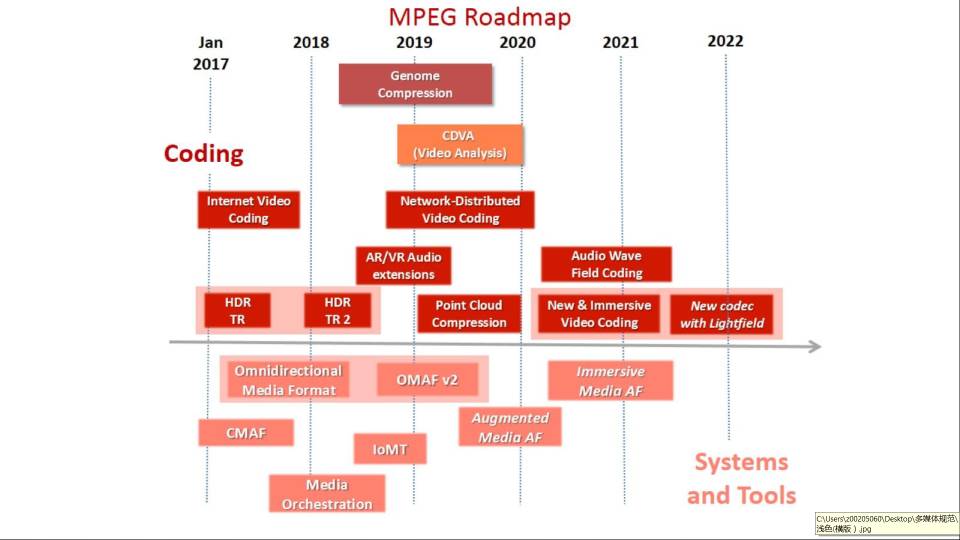

王田博目前在MPEG组织进行很多沉浸式媒体相关的工作。MPEG标准组成立于30年前,那些对互联网媒体有重大影响的MP3、MPEG2、AVC(H.264)、HEVC(H.265)、DASH等标准都是来自这个组织。最早期,这些标准的诞生促成了多媒体内容从模拟到数字化的进程;而到了后来——大概包含了过去二十年这样一个时间段,各个标准的发展方向主要是从高清到更高清,从更高清到超高清。

所谓的沉浸式媒体,就是通过音视频技术让用户产生身临其境的感觉,而这种体验的实现,需要比现在的4K还要更高清的传输;当然在带宽不够支撑这么多流量的前提下,也有很多衍生的技术来支持不完全的沉浸式体验。

完全的沉浸式体验,按照MPEG标准组织的定义,是叫做“6 DoF“——六个维度的自由度,即观察者在这个场景中可以以任何角度360度无死角的观察这个场景。低一个层次则叫做三个维度的自由度,即给定一个固定的观察点,观察者可以360度无死角的观察这个场景。在MPEG标准中,有关沉浸式媒体的标准叫做MPEG-I,内含七个组成部分,其中对于“沉浸式视频”、“点云压缩”,王田博士进行了较多的介绍。

沉浸式视频是MPEG-I的第三部分,其编解码标准FVC(H.266)的研究从2013年就开始启动,不过标准正式启动应该说是从今年才开始,标准工作组的成员当中,也不乏上面两位讲师提到的AOM组织的成员。此外,王田博士还提到现在已经有一些基于机器学习的视频编码工作正在进行,不过现在看来还比较不成熟,他预计在FVC的研发期间还起不到很大的作用。

点云压缩(Point Cloud Compression)与3D建模相关,目前的参与人数还不是很多。该技术未来可能主要应用于三种场景:一、大场景的静态重建;二、体育直播等动态场景;三、自动驾驶等需要一边扫描一边建模的场景。

LiveVideoStackCon 2017在第二天精彩继续:

《网易工业级WebRTC应用实践深度解析》网易云通信与视频CTO 赵加雨

《H.265在金山云的演进之路》金山云算法总监 朱政

《深度学习在视频分析中的架构、算法与应用》360人工智能研究院、视频大数据组技术负责人 陈强

《Emerging AV1 Video Codec - Novel Inter and Intra Prediction Tools Under Consideration》 谷歌软件工程师 Zoe Liu

《视频直播及在线课堂的沿革》沪江合伙人、沪江旗下CCtalk公司CEO 陆坚

《全景VR体育比赛转播的HEVC编码技术》暴风影音首席架构师 鲍金龙

......

了解更多大会信息,请关注LiveVideoStack微信公众号,大会相关资料会陆续在公众号发布。

本文分享自微信公众号 - LiveVideoStack(livevideostack)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。