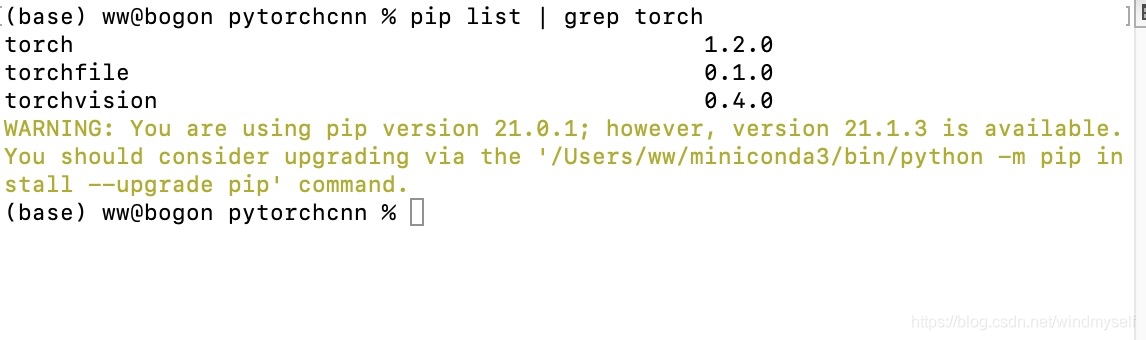

- 环境:python3、torch1.2.0(torch1.5.0也可以)、torchvision0.4.0

- 代码:(注:DOWNLOAD_MNIST = False第一次应该设为True,原因在代码注释里)

import torch

from torch.autograd import Variable

import torch.utils.data as Data

import torchvision # 数据库模块

import torch.nn as nn

import matplotlib.pyplot as plt

LR = 0.001 # 学习率

BATCH_SIZE = 50 # 表示每次选取50个样本作训练

EPOCH = 1 # epoch表示整个数据集重复训练次数

DOWNLOAD_MNIST = False # 是否下载MNIST,第一次需要设置为True,下载完数据集,以后不需要下载,设置为False就可以了。

train_data = torchvision.datasets.MNIST(root='./mnist',

train=True, # 表示这是训练集

transform=torchvision.transforms.ToTensor(), # 原始数据是array数组,转换为tensor,同时进行归一化

download=DOWNLOAD_MNIST)

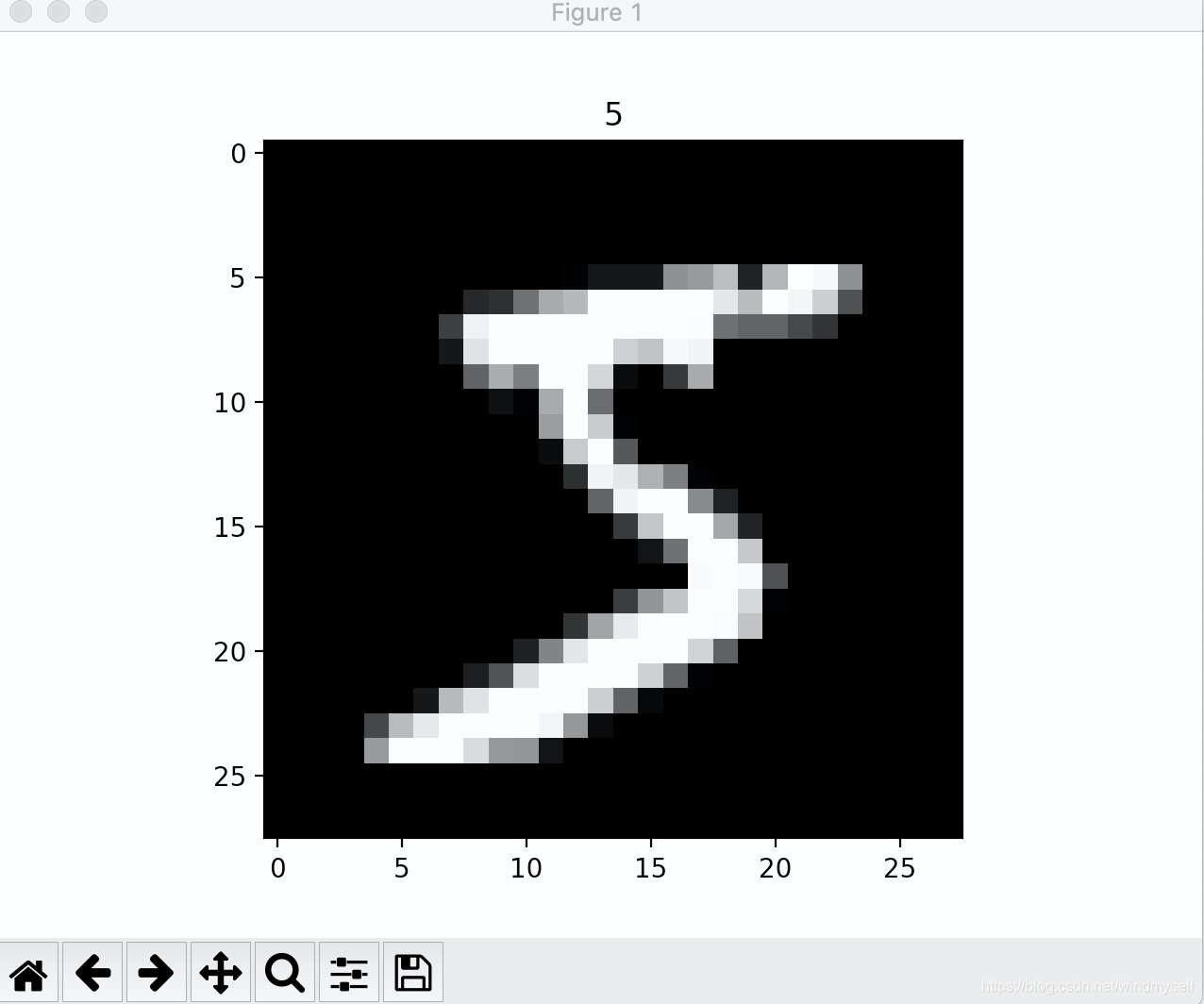

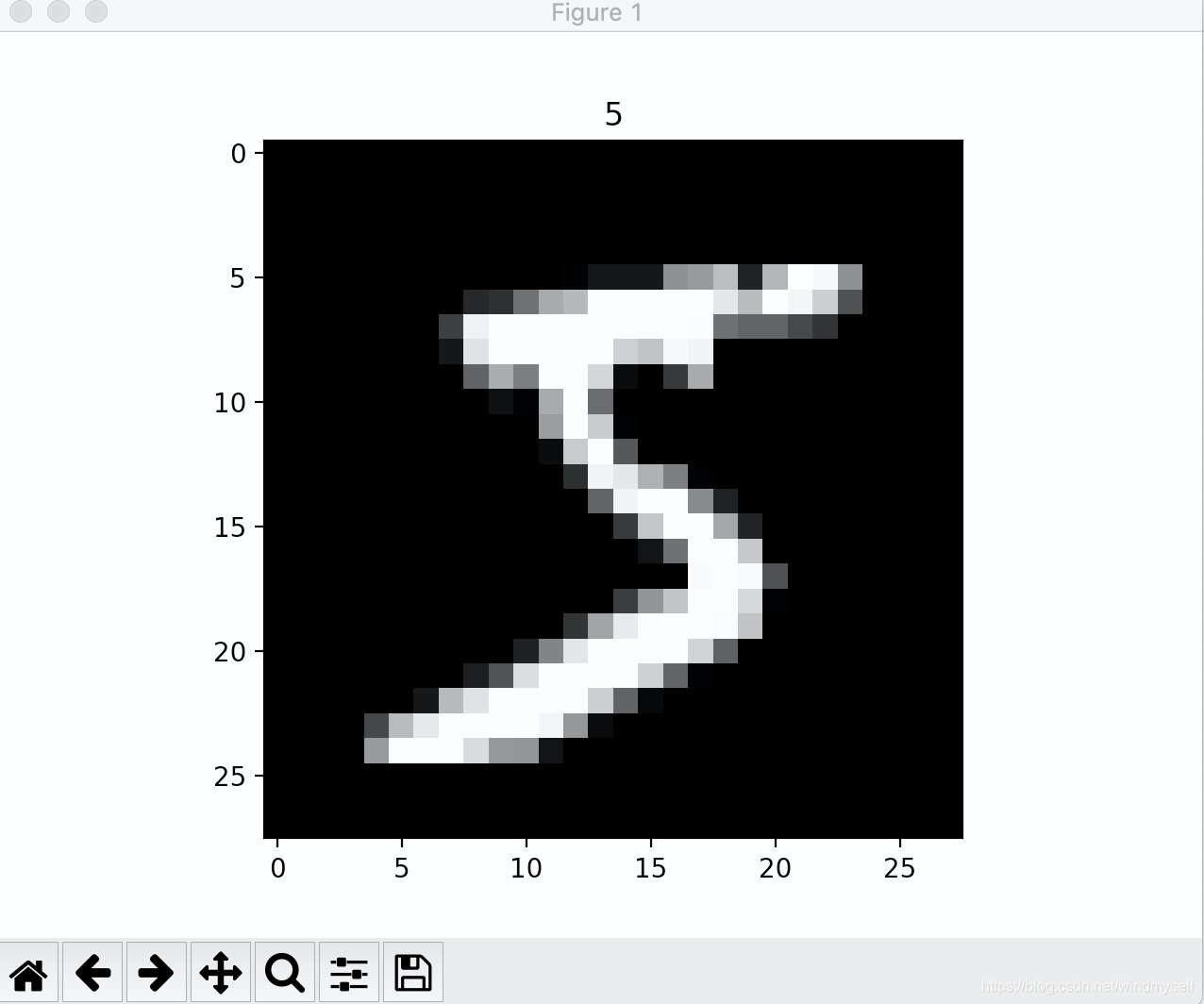

# 打印图片

print(train_data.data.size()) # 打印训练集的大小

print(train_data.targets.size()) # 打印训练集标签的大小

# 使用imshow()函数加载训练集中的图片

plt.imshow(train_data.data[0].numpy(), cmap='gray')

plt.title('%i' % train_data.targets[0])

plt.show()

# 训练

train_loader = Data.DataLoader(dataset=train_data, batch_size=BATCH_SIZE,

shuffle=True, num_workers=2) # 批量化(包装)处理数据集

test_data = torchvision.datasets.MNIST(root='./mnist', train=False)

'''#测试集shape from (2000, 28, 28) to (2000, 1, 28, 28), value in range(0,1)

test_x = torch.unsqueeze(test_data.data, dim=[:2000].type(torch.FloatTensor).cuda()/255.

'''#这里使用cuda()表示使用调用GPU加速跑测试集/训练集

# test_y = test_data.targets[:2000].cuda()

# test_x = Variable(torch.unsqueeze(test_data.test_data, dim=1), volatile=True).type(torch.FloatTensor)[:2000]/255

with torch.no_grad():

test_x = Variable(torch.unsqueeze(test_data.data, dim=1)).type(torch.FloatTensor)[:2000]/255.# 这行代码中的volatile=True在torch1.5版本以上就不支持了(包括1.5版本)

test_y = test_data.targets[:2000]

# 搭建CNN网络

if __name__ == '__main__':

class CNN(torch.nn.Module): # 定义一个神经网络层

def __init__(self): # 定义初始化

super(CNN, self).__init__() # 继承初始层

self.conv1 = torch.nn.Sequential(

nn.Conv2d(in_channels=1,

out_channels=16, # 卷积核个数

kernel_size=5, # 卷积核大小

stride=1, # 卷积核移动步长

padding=2, # 填充数目

), #-->卷积后的图片形状大小(28,28,16)

nn.ReLU(),

nn.MaxPool2d(kernel_size=2), #-->池化后的图片形状大小(14,14,16)

)

self.conv2 = nn.Sequential(

nn.Conv2d(16, 32, 5, 1, 2), #-->第二次卷积后的图片形状大小(14,14,32)

nn.ReLU(),

nn.MaxPool2d(kernel_size=2) #-->第二次池化后的图片形状大小(7,7,32)

)

self.out = nn.Linear(32*7*7, 10) # 全连接层

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = x.view(x.size(0), -1) # 数据展平为多维后的图片形状大小(batch size,7,7,32)

output = self.out(x)

return output

cnn = CNN()

print(cnn) # 打印CNN网络

# cnn.cuda() # CNN模型使用GPU加速

optimizer = torch.optim.Adam(cnn.parameters(), lr=LR, betas=(0.9, 0.99)) # Adam优化器

loss_func = nn.CrossEntropyLoss() # 损失函数

# 训练模型

for epoch in range(EPOCH):

for step, (b_x, b_y) in enumerate(train_loader):

# output = cnn(b_x.cuda()) # CNN预测输出

output = cnn(b_x) # CNN预测输出

# loss = loss_func(output, b_y.cuda())

loss = loss_func(output, b_y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

if step % 50 == 0:

# test_output = cnn(test_x.cuda())

test_output = cnn(test_x)

# test_pred = torch.max(test_output, 1)[1].cuda().data

test_pred = torch.max(test_output, 1)[1].data

test_accuracy = float((test_pred == test_y).sum().item()) / float(test_y.size(0))

print('Epoch:', epoch, 'Train loss:', loss.data.cpu().numpy(), 'Test Accuracy:', test_accuracy)

# 观察前20个数据误差

test_output = cnn(test_x[:20])

# pred_y = torch.max(test_output, 1)[1].cuda().data

pred_y = torch.max(test_output, 1)[1].data

print(pred_y.cpu().numpy(), 'prediction number')

print(test_y[:20].cpu().numpy(), 'real number')

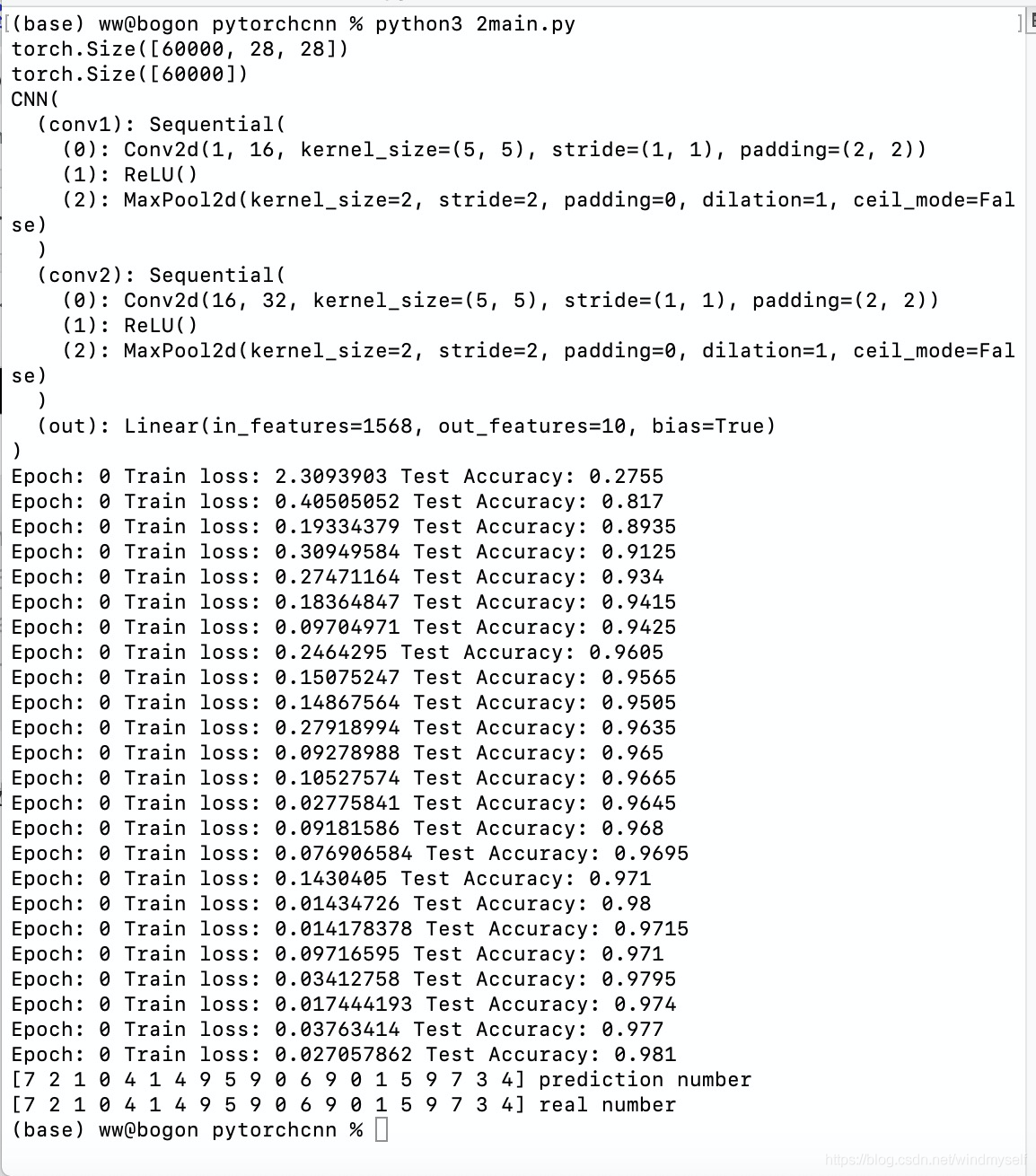

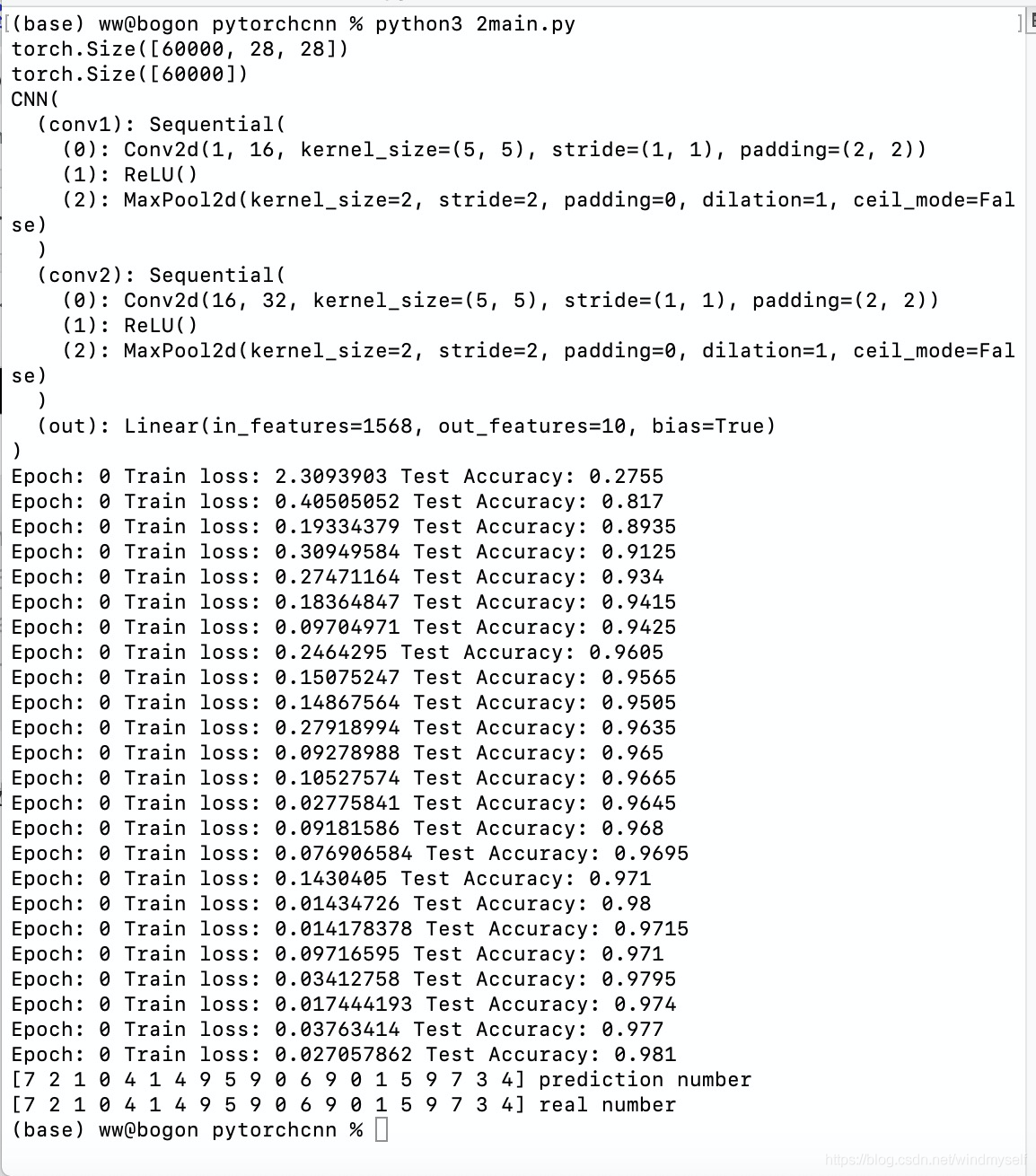

- 代码执行结果:

- 关掉显示窗口后程序继续执行