在完成Atlas编译以后,就可以进行Atlas的安装了。Atlas的安装主要是安装Atlas的Server端,也就Atlas的管理页面,并确保Atlas与Kafka Hbase Solr等组件的集成。

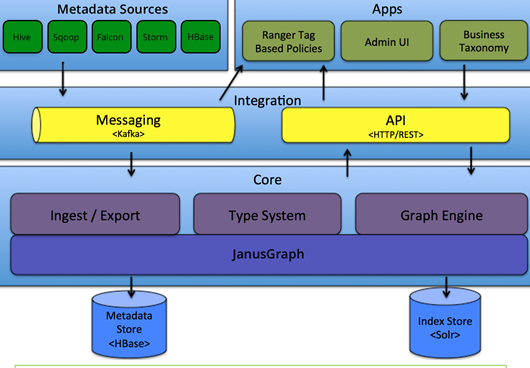

Atlas的系统架构如下,在确保 底层存储与UI界面正常后,之后就可以进行与Hive等组件的集成调试了。

一、环境准备

安装之前 先要准备好

JDK1.8

Zookeeper

Kafka

Hbase

Solr

在启动Atlas时会配置这些环境变量的地址,所以一定要确保以上组件正常运行。

由于在编译时可以选择内部集成,所以这些Atlas是可以自带的,但是JDK一定要安装好。

在安装Altas中,需要Solr 预先创建好collection

bin/solr create -c vertex_index -shards 3 -replicationFactor 2 bin/solr create -c edge_index -shards 3 -replicationFactor 2bin/solr create -c fulltext_index -shards 3 -replicationFactor 2

在solr中验证创建成功。

二、安装Atlas

到编译好的包的路径下 apache-atlas-sources-2.1.0/distro/target

将生成好的安装包 apache-atlas-2.1.0-server.tar.gz 拷贝到目标路径下。

解压:

tar -zxvf apache-atlas-2.1.0-server.tar.gz

三、修改配置

进入conf目录下:

vi atlas-env.sh

在此指定JAVA_HOME和是否要用内嵌启动

export JAVA_HOME=/opt/jdk1.8.0_191/export MANAGE_LOCAL_HBASE=trueexport MANAGE_LOCAL_SOLR=true

如果使用内嵌,那么配置结束,直接去 启动Atlas

但是大部分时候,需要使用已经有的组件进行集成,所以设置为false。

export JAVA_HOME=/opt/jdk1.8.0_191/export MANAGE_LOCAL_HBASE=falseexport MANAGE_LOCAL_SOLR=false #注意修改Hbase配置文件路径export HBASE_CONF_DIR=/opt/hbase/conf

修改其他配置

vim atlas-application.properties

这里就是设置Hbase Solr等配置

#Hbase地址 就是Hbase配置的zookeeper地址atlas.graph.storage.hostname=slave01:2181,slave02:2181,slave03:2181atlas.audit.hbase.zookeeper.quorum=slave01:2181,slave02:2181,slave03:2181#solr服务器地址atlas.graph.index..........